- Як відбувається A/B-тестування: шість кроків від припущення до висновку

- Як розділяється трафік: методи та інструменти

- Як здійснюється спліт-тестування у соціальних мережах

- Типові помилки в A/B-тестуванні

- Коли A/B-тестування не має сенсу

У цифрових продуктах навіть дрібні деталі можуть впливати на поведінку користувачів — від формулювання кнопки до фотографії на першому екрані. Проблема в тому, що наперед рідко зрозуміло, як саме спрацює та чи інша зміна. Навіть коли рішення здається очевидним, люди можуть реагувати зовсім інакше, ніж очікувалося. Тому замість прогнозів у якийсь момент логічніше просто подивитися, що користувачі роблять насправді.

Саме з цього підходу і виросло A/B тестування — як спосіб перевіряти ідеї в реальних умовах, а не обговорювати їх теоретично.

Зазвичай один варіант — це поточна версія, а другий відрізняється лише однією деталлю. Якщо ця деталь має значення, різниця проявляється в результатах.

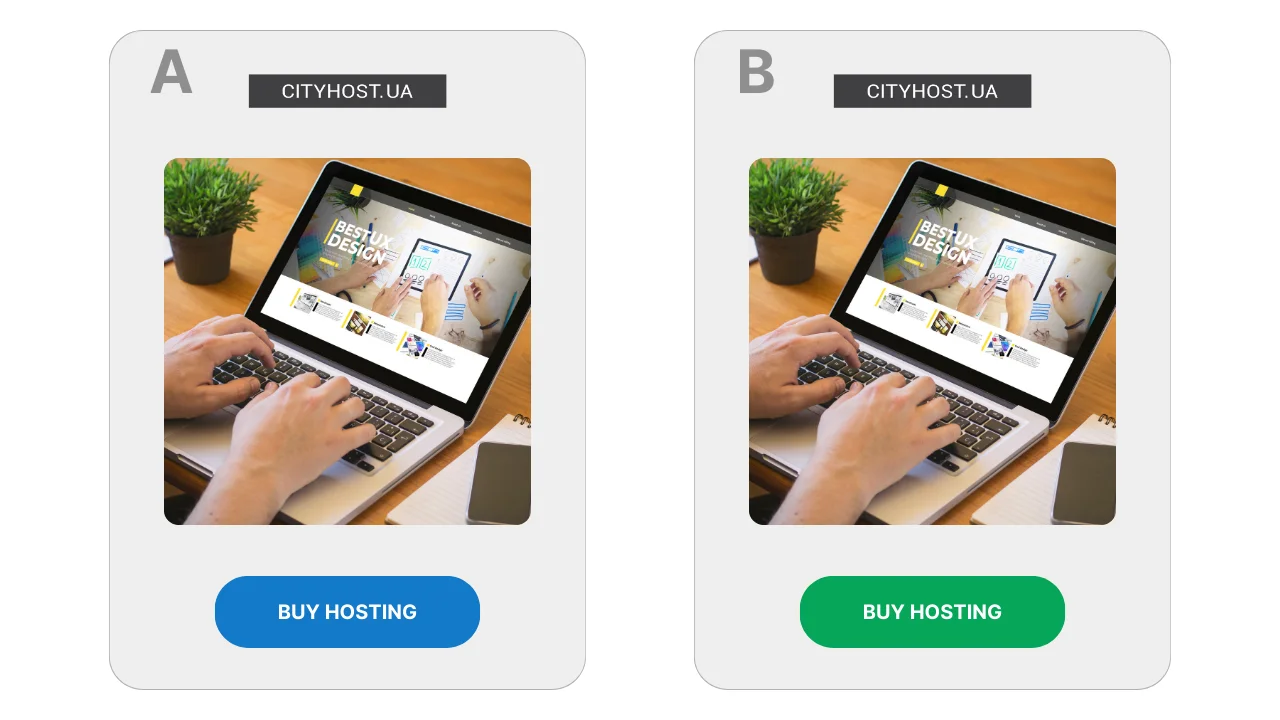

Наприклад, на сторінці з продажем хостингу для сайтів кнопку оформлюють у двох варіантах: синій та зелений. Якщо один із них приводить до більшої кількості переходів — саме його і залишають. Тут не йдеться про «правильний» дизайн, важлива лише реакція аудиторії.

Сам принцип порівняння двох варіантів сформувався задовго до появи інтернету. Його використовували в наукових дослідженнях, медицині, промисловості — скрізь, де потрібно було отримати об’єктивну відповідь, а не покладатися на інтуїцію. У цифровому середовищі A/B тестування стало масовим у 2000-х роках, коли з’явилася можливість швидко збирати дані про поведінку користувачів.

Читайте також: Що таке трафік сайту, як його дізнатися та навіщо контролювати

Як відбувається A/B-тестування: шість кроків від припущення до висновку

Спліт-тестування рідко виглядає як складний експеримент із формулами та графіками. Зазвичай це послідовність простих кроків, які повторюються від тесту до тесту, незалежно від того, що саме перевіряють — сторінку, рекламний матеріал чи окремий елемент інтерфейсу.

- З’являється сумнів або ідея. Тестування зазвичай починається з відчуття, що сторінка або рекламний матеріал могли б працювати краще. Формально все виглядає нормально: люди заходять, читають, іноді переходять далі. Але залишається питання — чи не реагували б користувачі інакше, якби подача була трохи змінена?

- Формулюється гіпотеза. На цьому етапі з’являється конкретне припущення про те, що саме може вплинути на поведінку користувачів. Наприклад, що абстрактна ілюстрація на першому екрані виглядає красиво, але не створює відчуття залученості — чому б не замінити її на фото реальної людини? Або що блок із відповідями на типові запитання варто показати раніше, щоб зняти частину сумнівів ще до ухвалення рішення.

- Готується два варіанти. Один варіант залишається без змін і слугує точкою відліку. Другий відрізняється лише однією деталлю, яку й перевіряють у тесті. Якщо змінювати кілька елементів одночасно, результат буде складно пояснити, навіть якщо він здаватиметься позитивним.

- Запускають тест і спостерігають. При цьому система запам’ятовує, який варіант було показано конкретному користувачу, і при повторних візитах демонструє той самий. Це важливо для чистоти експерименту — людина не має «перескакувати» між версіями.

- Обирають показник і дають тесту час. Заздалегідь визначають, на що саме будуть дивитися: чи переходять користувачі далі, чи взаємодіють із контентом, чи доходять до потрібного кроку. Перші результати зазвичай не показові, тому тесту дають попрацювати достатньо довго.

- Роблять висновок. Коли даних стає більше, стає зрозуміло, чи була між варіантами відчутна різниця. Іноді вона очевидна, іноді — настільки незначна, що змінювати щось не має сенсу. Буває й так, що тест не дає чіткої відповіді, і це теж результат: він означає, що конкретна зміна не вплинула на поведінку користувачів.

Такий підхід дозволяє перевіряти зміни без ризику зламати робочий варіант: поки тест триває, частина користувачів продовжує бачити звичну версію. Це особливо важливо, коли йдеться про сторінки, що вже приносять заявки або продажі.

Читайте також: Як підготувати сайт до підключення платіжної системи

Як розділяється трафік: методи та інструменти

- Основний принцип розподілу трафіку

- Чому не варто ділити трафік через дві різні сторінки

- Інструменти для розділення трафіку

У будь-якому A/B тесті ключовим є не сама ідея зміни, а те, як саме користувачі потрапляють на різні варіанти. Якщо цей етап організований неправильно, результати тесту втрачають сенс, навіть якщо цифри виглядають переконливо.

Трафік майже ніколи не ділять вручну. Причина проста: люди можуть повертатися на сайт кілька разів, заходити з різних пристроїв або потрапляти на сторінку з різних джерел. Без спеціальних інструментів неможливо гарантувати, що одна й та сама людина не побачить обидва варіанти.

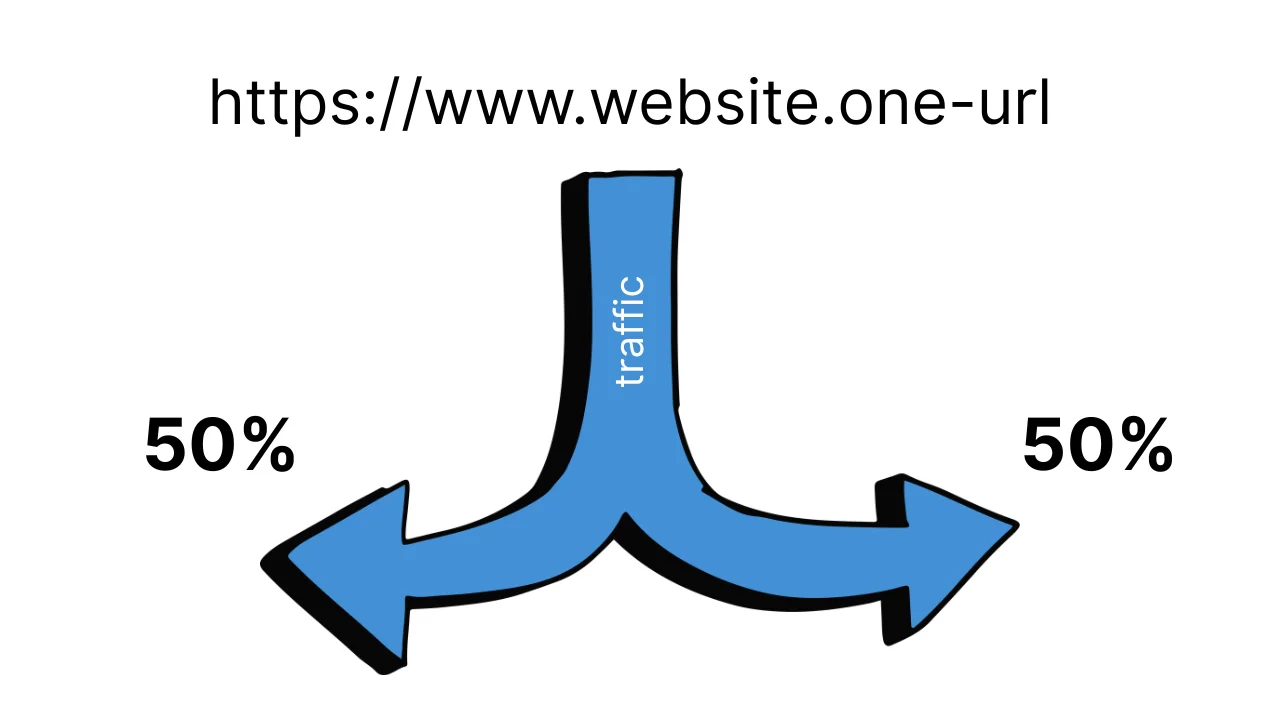

Основний принцип розподілу трафіку

У класичному A/B тестуванні використовується одна URL-адреса, а система тестування вже всередині вирішує, який варіант показати конкретному користувачу. Зазвичай це відбувається випадковим чином, наприклад у пропорції 50/50.

Важливий момент: після першого показу вибір фіксується. Якщо користувач повертається на сторінку, він бачить той самий варіант, що й раніше. Це дозволяє уникнути плутанини і не впливати на поведінку людей штучними «перемиканнями».

Чому не варто ділити трафік через дві різні сторінки

Поширена помилка — створити дві сторінки і просто вести на них трафік із різних рекламних оголошень. Формально це виглядає як тест, але при спробі його реалізації виникає кілька проблем:

- один користувач може побачити обидві версії;

- аудиторії в рекламі можуть перетинатися;

- результати сильно залежать від джерела трафіку, а не від самої зміни.

У такому форматі складно зрозуміти, що саме вплинуло на результат — сторінка, реклама чи випадковість.

Читайте також: Трафік + CPA-маркетинг: як заробити на партнерських оферах

Інструменти для розділення трафіку

Щоб уникнути цих проблем, використовують спеціальні сервіси для A/B тестування. Вони беруть на себе розподіл трафіку, фіксацію варіантів і збір статистики.

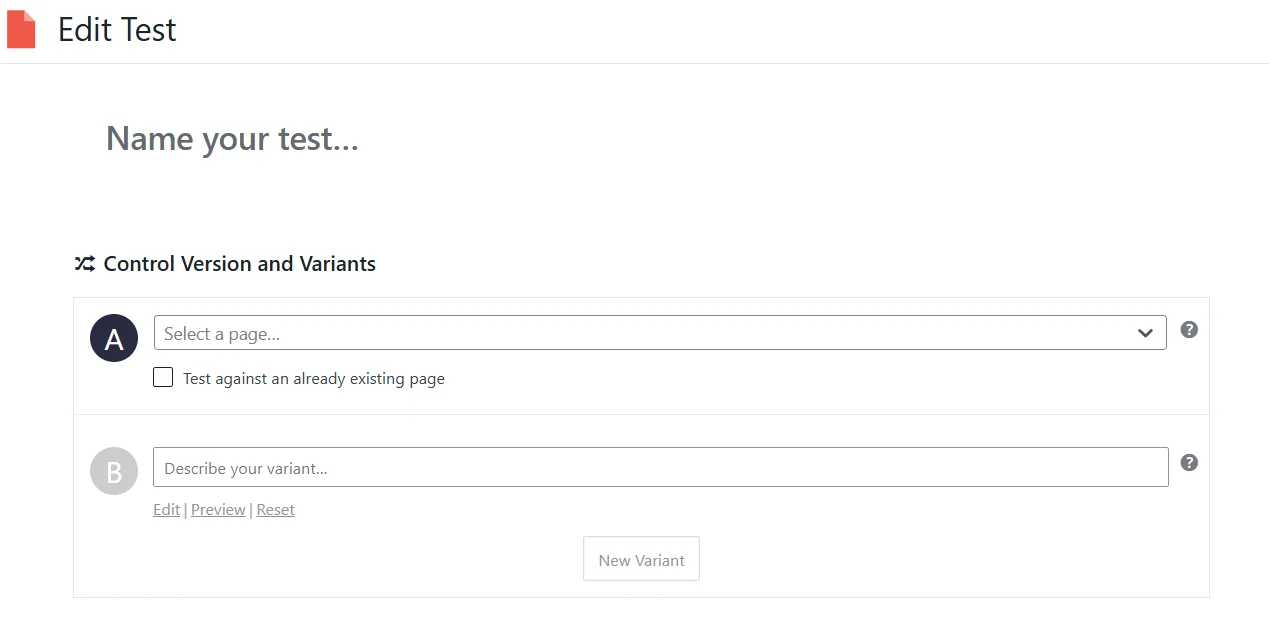

Для сайтів на WordPress часто обирають Nelio A/B Testing. Це плагін, який дозволяє тестувати сторінки, заголовки та окремі елементи без роботи з кодом. Варіанти створюються прямо в адмінці, а трафік ділиться автоматично.

Для лендінгів і маркетингових сторінок без складної логіки підходить Split Hero. Сервіс працює за принципом підміни сторінок і сам слідкує за тим, щоб користувачі бачили стабільний варіант.

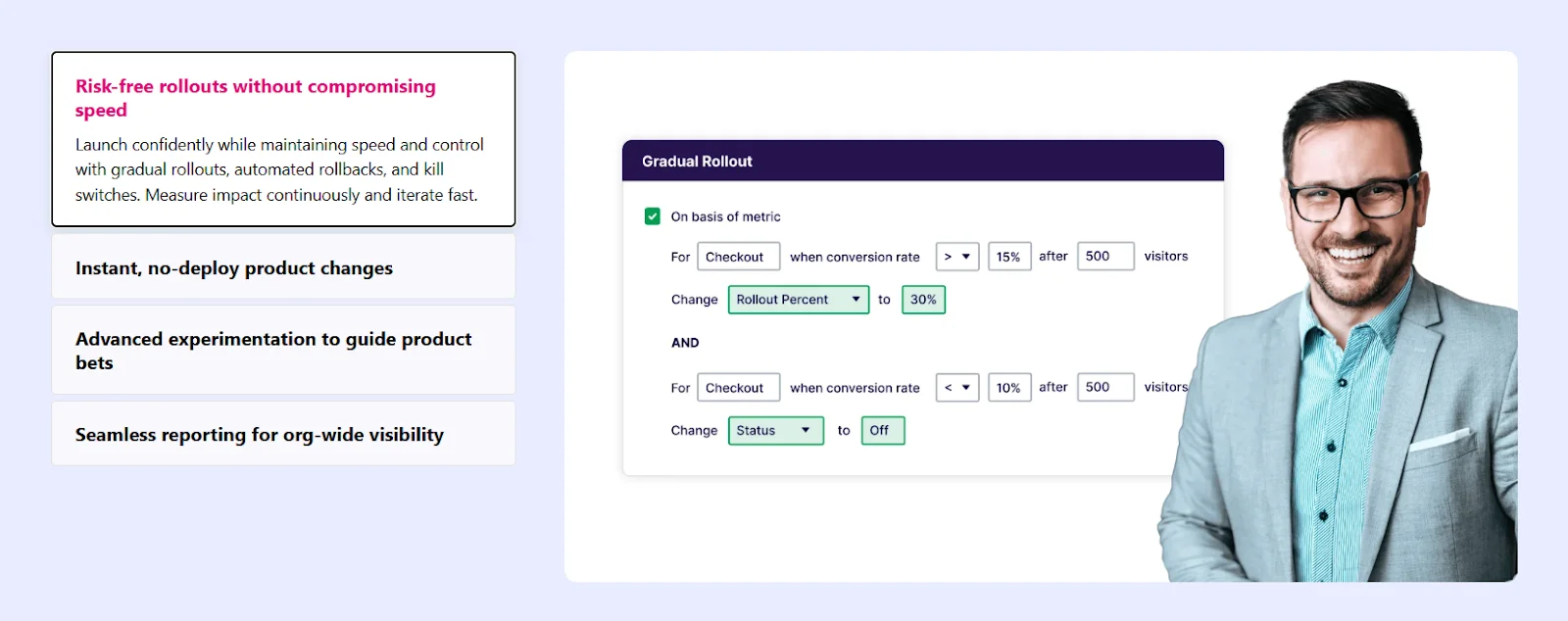

Більш універсальним рішенням вважається VWO. Він дозволяє тестувати як сторінки цілком, так і окремі елементи через візуальний редактор. Такі сервіси часто використовують у маркетингових командах, де важливо швидко запускати тести без залучення розробників.

Для великих проєктів і складних продуктів існують рішення на кшталт Optimizely, де розподіл трафіку може відбуватися на серверному рівні. Це дає більш чисті результати, але потребує технічних ресурсів і досвіду.

Як здійснюється спліт-тестування у соціальних мережах

- Як працює спліт-тестування реклами у Facebook

- Як запустити спліт-тестування реклами в TikTok

- Як проводити A/B-тестування в YouTube

У соціальних мережах спліт-тестування має принципове обмеження: для органічних дописів Facebook, Instagram, TikTik та YouTube не існує інструментів A/B тестування. Соцмережі не дають можливості контрольовано розділяти аудиторію між двома версіями поста, фіксувати показ для конкретного користувача або забезпечувати рівномірний розподіл переглядів. Тому коректно протестувати органічний контент технічно неможливо.

Ідея просто опублікувати два схожих дописи з різною подачею виглядає логічною, але насправді вона не дає достовірного результату. Одні й ті самі користувачі можуть побачити обидва пости, причому в різний час і в різних контекстах. Алгоритми соцмереж додатково втручаються в покази: якщо один допис швидше набирає реакції, він починає показуватися активніше, тоді як інший майже зникає зі стрічки. На результат також впливають час публікації, день тижня, загальний інформаційний фон і поточна активність аудиторії. У підсумку порівнюється не ефективність двох варіантів, а сукупність зовнішніх факторів і рішень алгоритму.

Водночас окремі платформи поступово впроваджують вбудовані автоматичні експерименти для конкретних форматів контенту. Наприклад, у Meta доступне A/B тестування для Reels. У цьому випадку платформа дозволяє створити кілька варіантів обкладинки або підпису до одного відео. Далі система сама ділить аудиторію на підгрупи, оцінює реакцію впродовж короткого часу (зазвичай за кількістю відтворень) і автоматично обирає варіант, який показав кращий результат.

Важливо розуміти, що такий механізм не є класичним A/B тестуванням. Користувач не контролює ані розподіл аудиторії, ані тривалість тесту, ані набір метрик — усі рішення ухвалює алгоритм платформи. По суті, це швидкий алгоритмічний відбір варіанту для подальшого поширення, а не повноцінний експеримент із детальним аналізом.

Повноцінне спліт-тестування в соціальних мережах можливе лише в рекламі. Рекламні кабінети платформ на кшталт Meta та TikTok мають спеціальні режими експериментів, у яких платформа сама ділить аудиторію між варіантами. У такому форматі кожен користувач бачить лише одну версію оголошення, а результати збираються паралельно й без перетину показів.

У рекламному спліт-тестуванні зазвичай змінюють один параметр: креатив, текст, заголовок, заклик до дії або аудиторію. Решта умов залишаються однаковими, що дозволяє пов’язати результат саме з конкретною зміною.

Як працює спліт-тестування реклами у Facebook

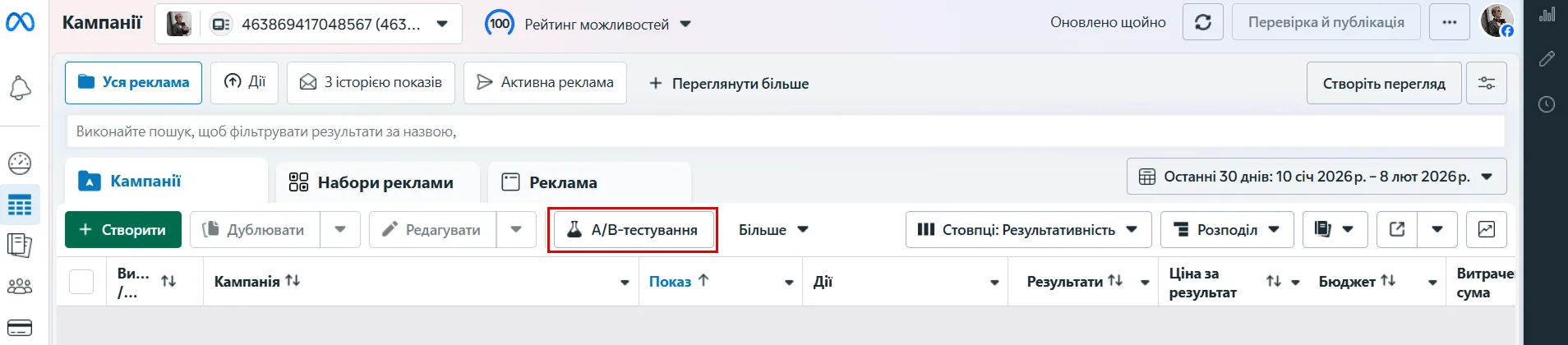

Варто знати, що спліт-тестування реклами в TikTok і Facebook доступне лише в браузерній версії рекламного кабінету. Мобільні застосунки не підтримують створення A/B тестів, тому запустити їх з телефона неможливо.

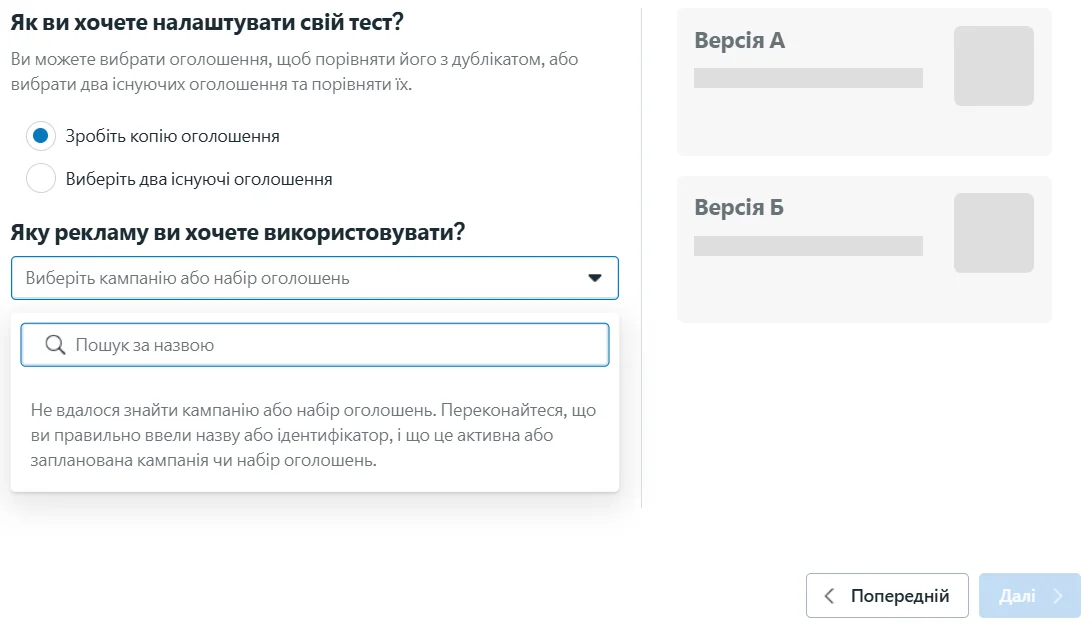

У рекламному кабінеті Facebook ця функція запускається через кнопку «A/B-тестування» у верхній панелі Ads Manager. Тестування завжди створюється на базі наявного рекламного об’єкта — кампанії, набору оголошень або конкретного рекламного допису.

Після натискання кнопки Facebook пропонує обрати, як саме буде налаштований тест. Є два варіанти: або взяти одне оголошення й створити його копію для порівняння, або вибрати два вже створені оголошення. У будь-якому випадку система просить вказати кампанію, набір оголошень або конкретний рекламний допис, який стане основою тесту.

Далі логіка тесту стандартна: система формує дві версії реклами, ділить аудиторію між ними й показує кожен варіант окремій групі користувачів. Після завершення тесту Facebook порівнює результати й показує, який варіант спрацював краще.

Як запустити спліт-тестування реклами в TikTok

Щоб запустити A/B-тестування в TikTok, потрібно працювати з браузерною версією рекламного кабінету. У самому застосунку TikTok або в TikTok Studio цієї функції немає, тому перший крок — зайти на сайт ads.tiktok.com і увійти у свій рекламний акаунт. Якщо акаунта ще немає, система проведе через стандартну реєстрацію з вибором країни, типу бізнесу та налаштуванням оплати.

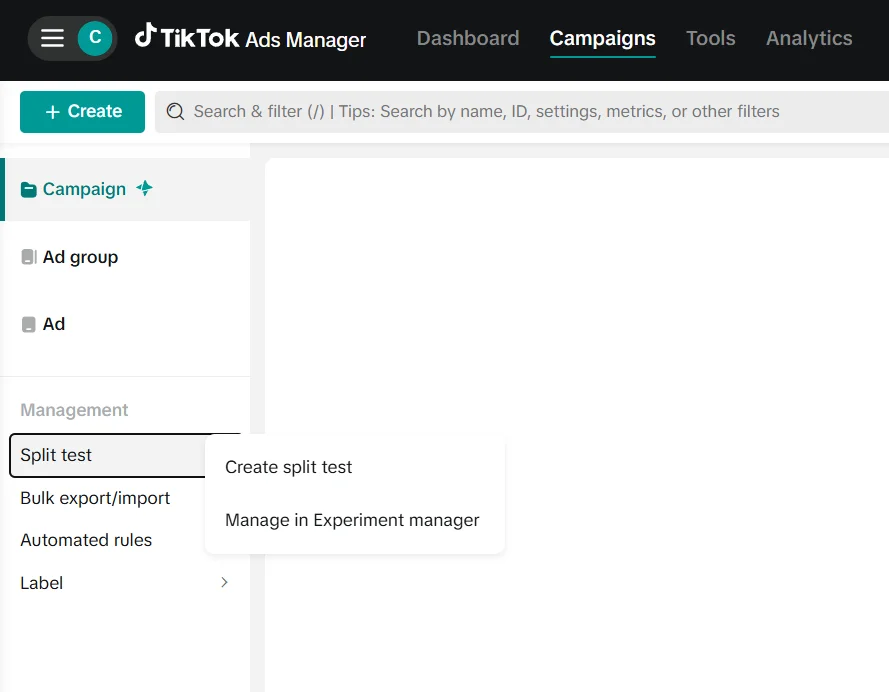

Після входу відкривається TikTok Ads Manager. У верхньому меню потрібно перейти в розділ Campaigns. Саме тут знаходяться всі кампанії, групи оголошень та інструменти керування рекламою. У лівій колонці, нижче основної структури кампаній, є блок Management. У ньому розташований пункт Split test — це і є точка входу до спліт-тестування.

Натиснувши Split test, потрібно обрати Create split test.

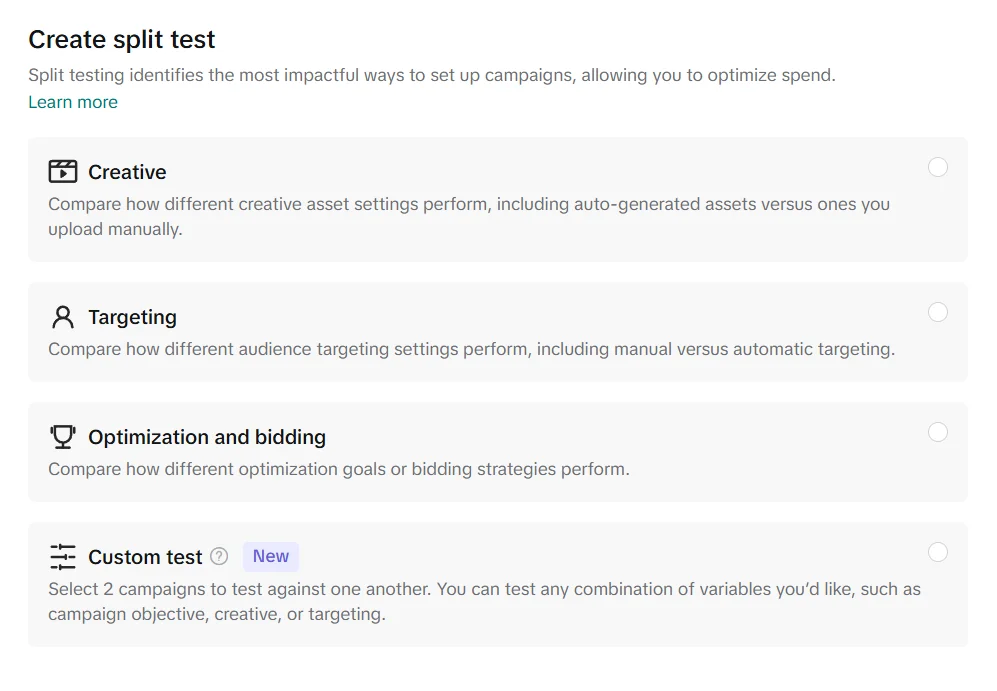

Після цього потрібно вибрати, що саме буде тестуватися. TikTok пропонує кілька варіантів: тестування креативів, налаштувань аудиторії або стратегій оптимізації та ставок. Є також режим Custom test, який дозволяє порівнювати дві кампанії з будь-якою комбінацією змін.

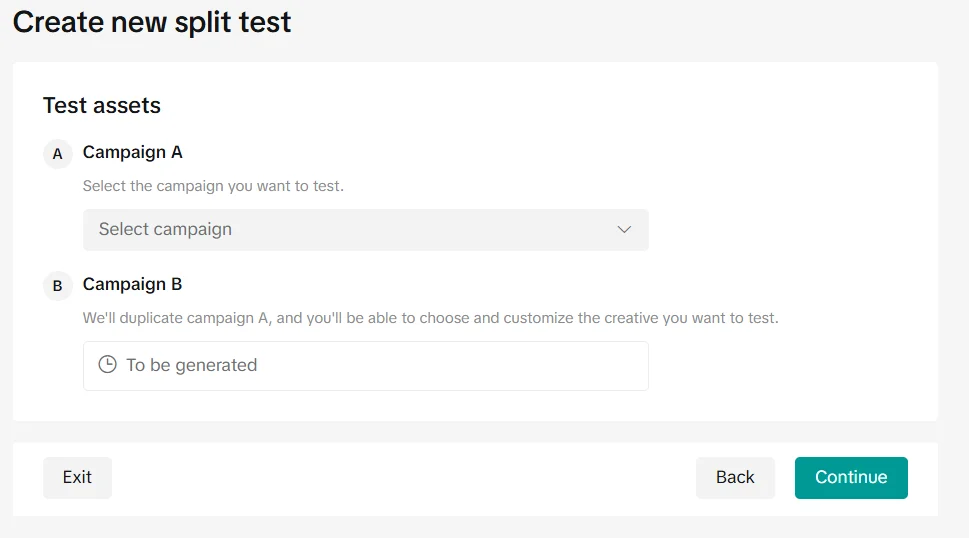

На наступному кроці потрібно вибрати рекламний об’єкт для порівняння. Система пропонує визначити Campaign A — існуючу кампанію, яка буде використана як базова версія. Campaign B створюється автоматично шляхом копіювання першої кампанії, після чого в ній можна змінити лише той параметр, який обрано для тестування. Таким чином обидві кампанії мають однакові налаштування, а різниця між ними зводиться до однієї контрольованої зміни.

Після підтвердження налаштувань і натискання Continue спліт-тест запускається. Після завершення тестування система показує, який варіант виявився ефективнішим за обраною метрикою.

Читайте також: Як розкрутити сайт за допомогою соцмереж

Як проводити A/B-тестування в YouTube

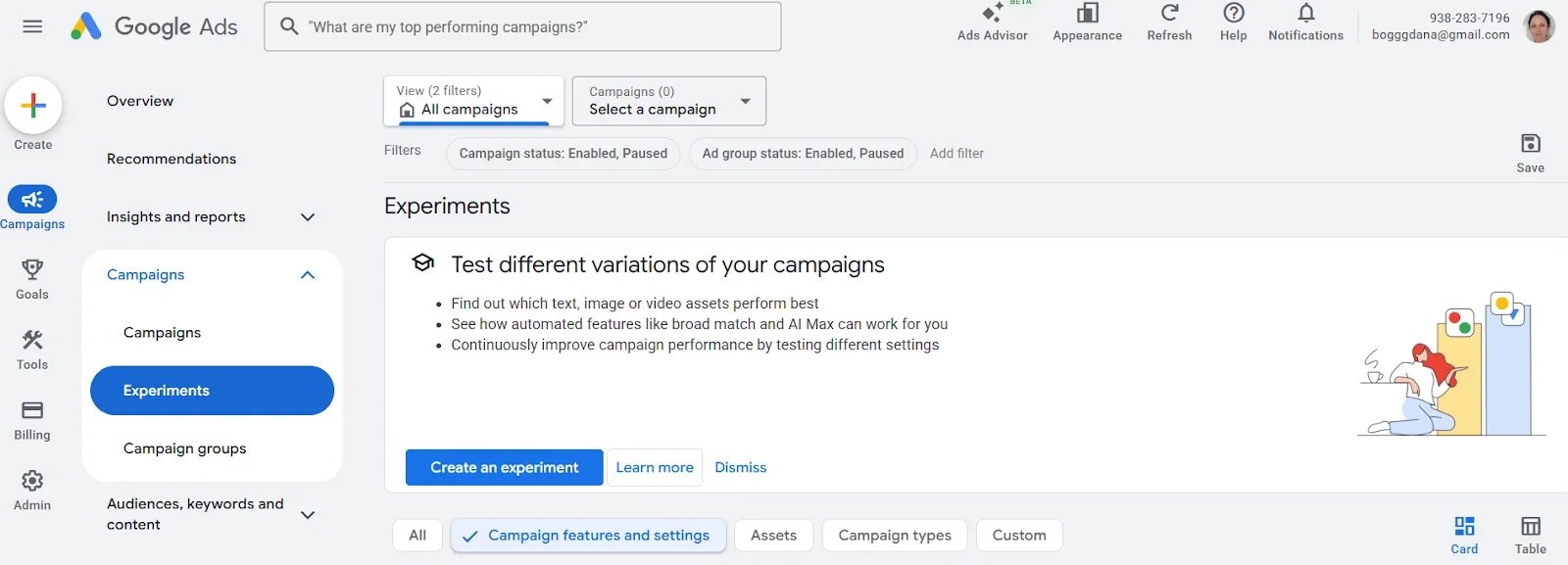

Спліт-тестування відеореклами YouTube проводиться не в YouTube Studio, а через рекламний кабінет Google Ads.

Перший крок — зайти на сайт ads.google.com та увійти у свій акаунт Google Ads. Після входу потрібно перейти в розділ кампаній і переконатися, що у вас уже є створена відеокампанія для YouTube або принаймні підготовлений креатив, з яким ви плануєте працювати.

Після переходу в Campaigns → Experiments відкривається сторінка для створення експериментів. Саме тут Google Ads пропонує протестувати різні варіації кампаній — креативи, налаштування або окремі параметри показу. Для запуску спліт-тесту потрібно натиснути кнопку Create an experiment.

Далі система просить вибрати базову кампанію, яка вже існує в акаунті. На її основі Google Ads створює тестову версію, у якій можна змінити один або кілька параметрів залежно від типу експерименту. Після цього задається розподіл трафіку між оригінальною кампанією та тестовою версією, а також тривалість експерименту.

Результати експерименту відображаються в цьому ж розділі Experiments і дозволяють побачити, яка версія реклами показала кращі результати за обраними метриками.

Типові помилки в A/B-тестуванні

Навіть правильно налаштоване A/B-тестування може дати хибні висновки, якщо помилитися на етапі планування або аналізу результатів. Найчастіше проблеми виникають не через інструменти, а через поспіх і неправильну інтерпретацію даних.

- Тестування кількох змін одночасно. Коли в одному тесті змінюють одразу кілька елементів, стає незрозуміло, що саме вплинуло на результат. Навіть позитивний підсумок у такому випадку складно використати на практиці.

- Занадто коротке тестування і мала кількість даних. Перші результати часто виглядають переконливо, але зазвичай це лише випадкові коливання. Якщо тест зупиняють рано або аналізують дані з невеликої вибірки, висновки можуть бути хибними.

- Зміна умов під час тесту. Коригування бюджету, таргетингу чи інших налаштувань у процесі тестування порушує рівність умов. У такій ситуації порівняння варіантів уже не є коректним.

- Очікування великого ефекту від незначних змін. Не кожна правка помітно впливає на поведінку користувачів. Відсутність різниці між варіантами — це нормальний результат, а не ознака провалу.

- Переконання, що тест завжди має дати чітку відповідь. Іноді A/B-тестування лише підтверджує, що обидва варіанти працюють однаково. Це сигнал не «шукати переможця», а формувати нові гіпотези.

Коли A/B-тестування не має сенсу

A/B-тестування часто сприймають як універсальний інструмент для ухвалення рішень. Але є ситуації, в яких воно або не дає корисної інформації, або створює ілюзію контролю, не наближаючи до реального розуміння проблеми. Найчастіше це трапляється в таких випадках.

- Коли замало трафіку. Якщо на сторінку чи рекламну кампанію приходить невелика кількість користувачів, результати тесту будуть нестабільними й випадковими.

Якщо на лендинг заходить 20-30 людей на день, і тестуються два варіанти кнопки, то через тиждень один варіант матиме чотири кліки, інший — шість. Формально різниця є, але вона легко пояснюється випадковістю, а не реальною перевагою.

- Коли продукт або пропозиція незрозумілі аудиторії. Якщо люди не розуміють, що їм пропонують і навіщо це їм потрібно, зміна заголовка, кнопки чи зображення не вплине на рішення.

Наприклад, сервіс продає доменні імена, але на першому екрані сторінки використовує розмиті формулювання. Команда запускає A/B-тест двох заголовків:

- «Інфраструктурні рішення для онлайн-присутності»

- «Запусти свій проєкт в інтернеті вже сьогодні»

Обидва варіанти показують схожі результати, бо користувачі так і не розуміють, що саме їм пропонують: домен, хостинг, VPS чи взагалі комплексну послугу. У такій ситуації тест не виявляє кращий варіант, адже проблема не в конкретному формулюванні, а в самій ясності пропозиції.

- Коли тестують не той рівень проблеми. Якщо реклама не працює через невдалу аудиторію або слабку ідею загалом, перевірка дрібних правок лише підтвердить відсутність результату.

Уявімо, що реклама показується дуже широкій аудиторії, яка не має потреби в продукті. Замість перегляду таргетингу запускають A/B-тест двох текстів оголошення. Обидва варіанти працюють погано — і тест лише фіксує це, не вирішуючи причину.

- Коли кампанія має короткий життєвий цикл. Рекламні кампанії або сторінки, які існують кілька днів чи тиждень, просто не встигають зібрати достатньо даних.

- Коли від тестування очікують готових відповідей. A/B-тест не підказує, що робити далі, якщо обидва варіанти показали схожі результати.

У підсумку A/B-тестування найкраще працює там, де є зрозумілий продукт, стабільний потік користувачів і чітка гіпотеза для перевірки. В інших випадках воно може бути передчасним — і це не помилка, а підказка змінити фокус роботи.

Добре налаштований тест показує, чи має конкретна зміна помітний вплив. Іноді він виявляє кращий варіант, іноді — підтверджує, що різниці немає. Обидва результати корисні, якщо їх правильно інтерпретувати.