Дуже часто пошукові боти досить агресивно сканують сайт і тим самим створюють підвищене навантаження. Для того щоб зупинити індексацію потрібно прописати в файлі robots.txt наступне правило:

User-agent: *

Disallow: /

Це правило повністю виключає сканування ботами сайту. Якщо повністю обмежити доступ до сайту для сканування, сайт може пропасти у видачі пошукових систем.

1. Тому можна обмежувати доступ тільки до конкретних папок, посиланнях, файлам і розширенням за допомогою директиви Disallow.

Приклади:

User-agent: *

Disallow: / directoria

User-agent: *

Disallow: /privatinfo.php

User-agent: *

Disallow: /privatpic.jpg

User-agent: *

Disallow: / * jpg $

Більш детальну інформацію по роботі з файлом можна знайти в інструкціях google.

2. Також можна обмежити доступ через файл .htaccess до певних сторінок сайту як це було описано в інструкції.

Для обмеження доступу з конкретної IP-адреси, досить прописати правило:

Order Allow, Deny

Allow from all

Deny from ***. ***. ***. ***

***. ***. ***. *** - замінити на IP-адресу. Дізнатися IP адреса можна відкривши логи сервера на FTP в папці logs.

3. Щоб заблокувати доступ усім крім українських IP можна скористатися інструкцією.

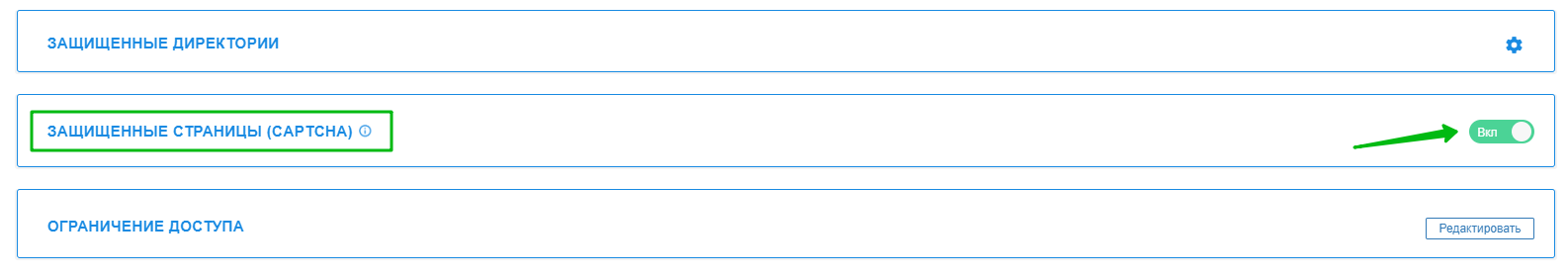

4. Закрити доступ ботам до уразливих сторінок можна через внутрішню капчу, яку можна знайти в розділі Хостинг 2.0 - Сайти - Безпека - ЗАХИЩЕНІ СТОРІНКИ (CAPTCHA) *:

* По-замовчуванню капча включена для наступних сторінок:

WP LOGIN PAGE : wp-admin, wp-login.php

JOOMLA ADMIN PAGE: /administrator, view=login

JOOMLA REGISTER PAGE : view=registration

OC ADMIN PAGE : /admin

MODX ADMIN PAGE: /manager

PRESTA SHOP ADMIN PAGE: /Backoffice

DRUPAL ADMIN PAGE : /user/login/

Більш детально про robots.txt описано у нас в блозі - https://cityhost.ua/blog/chto-takoe-robots-txt-kak-nastroit-robots-txt-dlya-wordpress.html

Всі категорії питань