Кто такие боты — это программное обеспечение, направленное на сбор и анализ информации в интернете, а также на выполнение повторяющихся действий, которые мог бы совершать пользователь. Например, боты могут парсить данные на сайтах, кликать по рекламе, заполнять формы обратной связи, давать запрограммированные ответы в чатах.

Термин «бот» имеет широкое использование, им называют и автоматизированные ответы в соцсетях и на сайтах (чат-боты), и людей, управляющих фиктивными аккаунтами в соцсетях. Мы же будем говорить именно о тех ботах, которые заходят на сайт и совершают там определенные действия без ведома владельца.

Благодаря большей скорости бот может совершить в сотни раз больше операций, чем человек за то же время. Кроме того, использование бота стоит дешевле, чем найм работников – например, для сбора данных. Поэтому роботы лежат в основе автоматизации многих процессов в сети.

Почти половина трафика в Интернете создается ботами. Согласно исследованиям Statista в 2021 году вредоносные боты создавали 27,7% трафика, тогда как полезные боты – только 14,6%. Людям в этом распределении досталось 57,7% трафика.

Каждый бот, входя на сайт, создает определенную нагрузку. И если с трафиком от полезных ботов придется смириться, то вредные боты влекут за собой сразу несколько проблем в зависимости от цели своего существования. Помимо нагрузки на сайт, это и несанкционированный сбор данных, и DDoS-атаки, и обход систем защиты.

Независимо от того, где размещен ваш сайт — на хостинге, выделенном сервере или VDS, боты отбирают ресурсы и вредят показателям быстрой загрузки.

Давайте разберемся, что такое вредоносные и полезные боты и какими они бывают.

Что такое вредоносные боты и чем они отличаются от полезных

Полезные и вредоносные боты очень похожи в техническом плане — разница заключается в цели их использования. В зависимости от целей они делятся на более узкие категории.

Вредоносные боты:

-

Боты-шпионы – сканируют сайты в поисках плохо защищенных контактных данных пользователей для создания базы спам-рассылки и других несанкционированных действий. Если на вашу электронную почту начали приходить подозрительные письма, то один из вариантов сценария: вы оставили адрес на плохо защищенном сайте, его нашел бот и включил в базу.

-

Кликботы — из названия можно догадаться, что они занимаются кликанием, а точнее, переходят по ссылкам. Больше всего неприятностей они создают в рекламном секторе в Google, сливая бюджет на объявлениях с оплатой за клики. Этим методом часто пользуются конкуренты.

-

Взломщики подбирают пароли доступа к аккаунтам администраторов или пользователей на сайте.

-

Боты-спамеры заполняют формы обратной связи и оставляют рекламные комментарии со ссылками, часто ведущими на фишинговые сайты.

-

Загрузчики скачивают файлы – их используют, чтобы создать видимость востребованного контента.

-

Боты для DDoS – ими часто становятся пользовательские устройства, зараженные вредоносным программным обеспечением. Такие боты посылают очень много запросов на сервер с целью «положить» его.

Полезные боты:

-

Поисковые боты (краулеры) — это работы поисковых систем, которые сканируют страницы сайтов с целью включения их в индекс, ранжирование и выдачу в SERP.

-

Боты сервисов SEO-аналитики — это инструменты Ahrefs, Serpstat, Semrush и других аналогов, которые мониторят на сайтах определенные показатели, необходимые для работы SEO-специалистов (трафик, обратные ссылки, ключи, по которым ранжируется сайт).

-

Сканеры для определения уникальности контента — их используют для проверки текстов копирайтеры. Антиплагиаторы проверяют все доступные в сети статьи для сопоставления и выявления скопированных текстов.

В этой классификации собраны наиболее распространенные боты — на самом деле их гораздо больше. Кроме того, такая классификация достаточно условна. Один и тот же бот можно использовать для разных целей — например, агрессивный парсинг данных может вызвать замедление и даже остановку работы сайта. Но тот же парсинг полезен для сайтов, ведь это часть работы поисковых систем, сервисов для сравнения цен и многих других платформ.

Как отследить активность ботов на сайте

Появление ботов можно отследить по нескольким критериям:

-

Всплески трафика — если у вас внезапно «скакнул» трафик, что не связано с маркетинговыми акциями, это может свидетельствовать об активности ботов.

-

Повышение нагрузки на сервер может также говорить об активности ботов.

-

Появление запросов из регионов, где вы не ведете бизнес.

-

Высокий показатель отказов: боты создают запросы, но не проводят на сайте достаточно времени. В IP-адресах ботов будет показатель 100% отказов.

Но лучше всего деятельность ботов на сайте можно увидеть, анализируя логи — это записи о сеансах посещения сайта, в которых указан ряд данных о визитере. В частности, это такой показатель как user-agent — программные агенты, под названием которых можно определить устройство или программу, которая заходила на сайт. Юзер-агенты есть у браузеров, поисковых роботов, мобильных приложений и т.д.

У каждого бота есть свое имя, например юзер-агент Google называется Googlebot, парсер Ahrefs — AhrefsBot, SE Ranking — SE Ranking bot.

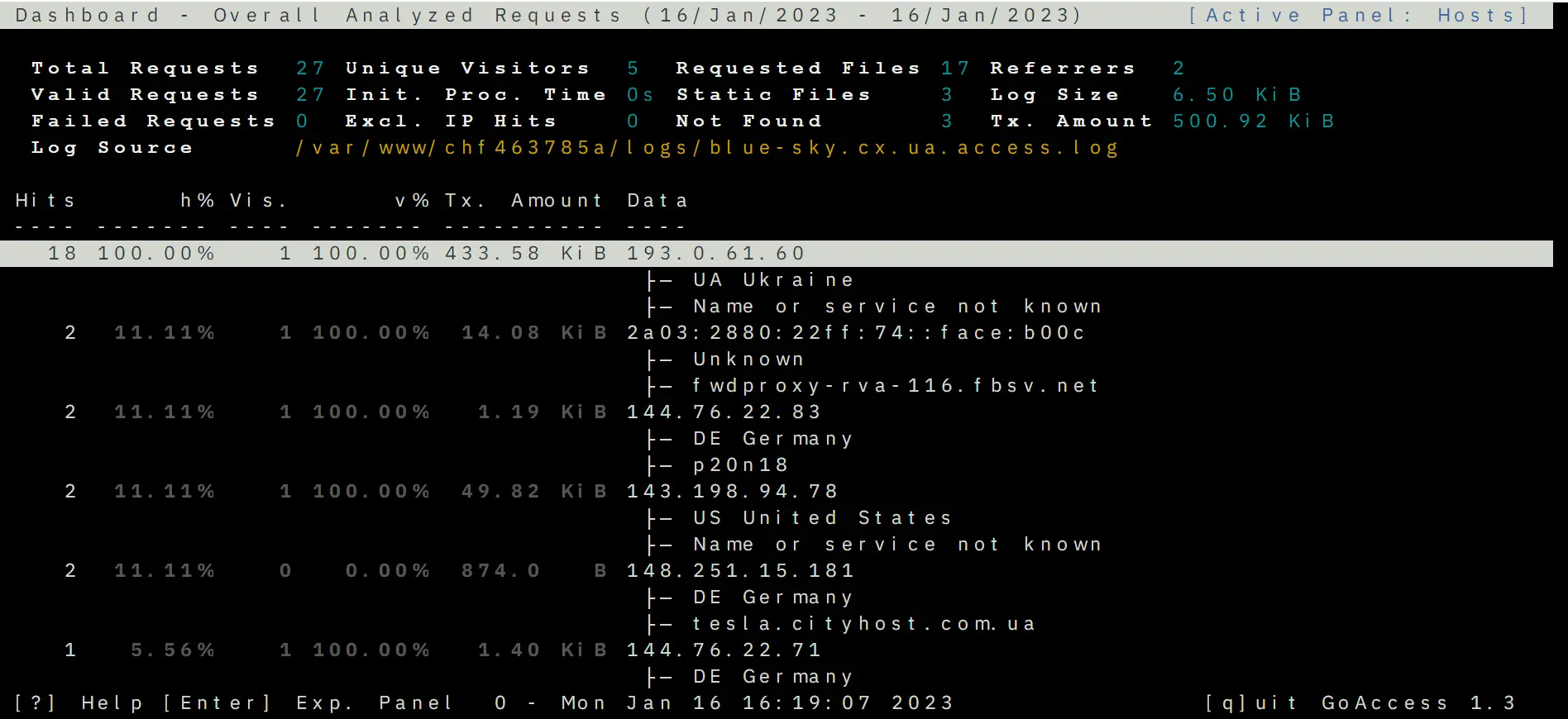

Чтобы посмотреть логи, используйте специальный инструмент GoAccess от Cityhost, который сортирует запросы и выдает статистику. Его можно найти в разделе Хостинг => Управление => SSH => Web SSH: Открыть. Далее рекомендуем воспользоваться инструкцией, как анализировать логи с помощью GoAccess.

С его помощью можно увидеть страну, из которой входили на сайт, IP-адрес, user-agent и другие параметры.

Если же у бота нет юзер-агента (пишется как Unknown robot) — тогда, скорее всего, это работа какого-нибудь любителя или одиночного хакера, которого можно забанить по IP-адресу. Читайте ниже, как это сделать.

Защита сайта от вредоносных ботов

Одна из сложностей защиты от ботов заключается в том, что они имитируют действия пользователей, и сервер не отличает запросы от ботов и людей. Не существует волшебной кнопки «Защита от ботов на сайте», которая одним движением избавит от проблем. От каждого класса роботов существует отдельная защита, к тому же часть незваных гостей приходится фильтровать вручную.

Закрывать доступ к сайту нужно не только откровенно вредоносным ботам, но и тем, которые не несут пользы, но создают лишнюю нагрузку. К примеру, когда сайт сканирует сервис аналитики или поисковый робот, который не нужен для вашей работы.

Перед веб-мастерами встает целый ряд сложных вопросов, которые не всегда можно решить — например, та же защита от парсинга. Автоматическими методами невозможно отличить хороший и плохой парсинг, к тому же по факту этот метод не является незаконным. Просматривать и собирать данные с сайтов может кто угодно, для этого они созданы. Когда пользователь листает страницы и выписывает цены, это тоже процесс сбора данных, просто парсер делает это быстрее. Такие тонкости усложняют процесс защиты сайта и делают его непрерывным. Следует постоянно отслеживать трафик и анализировать логи, чтобы увидеть сеансы входа на сайт вредоносных ботов и вручную заблокировать их.

Поскольку ботов часто используют для DDoS, рекомендуем вам прочитать статью о том, как защититься от DDoS-атак.

Методы блокировки вредоносных ботов

Здесь мы расскажем об инструментах, преимущественно предоставляемых клиентам Cityhost. Если вы используете услуги других провайдеров, методы могут несколько отличаться.

-

Блокировка источников трафика

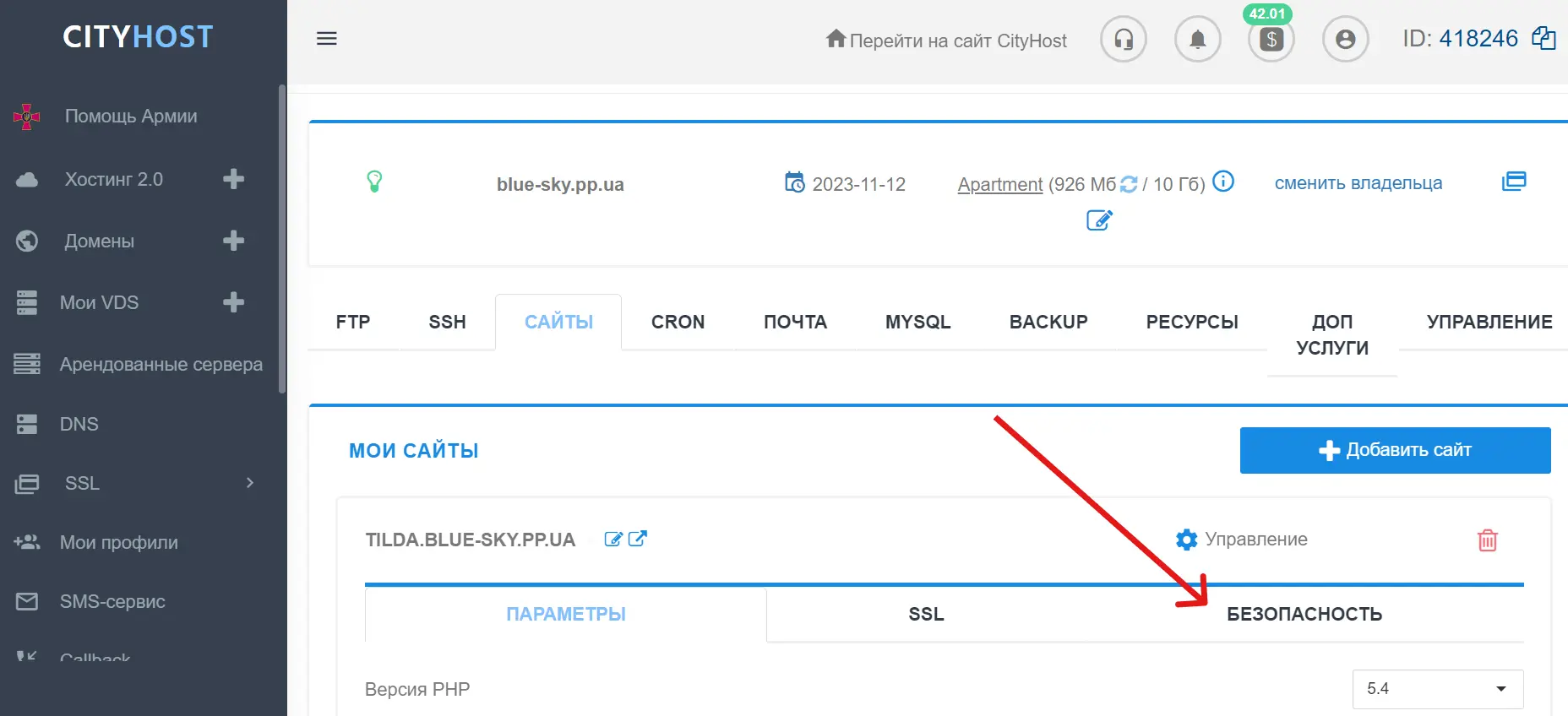

В панели управления Cityhost можно вручную заблокировать подозрительные источники трафика по IP-адресу и по URL. Найти инструменты для блокировки можно в разделе Хостинг => Управление => Безопасность.

Отдельно стоит сказать о блокировке по user-agent — в этом инструменте уже есть встроенный список распространенных вредоносных ботов. Пользователь может включить или отключить инструмент, а также убрать отметки c определенных юзер-агентов или выбрать все. Если же вы хотите заблокировать вручную конкретных юзер-агентов – для этого есть отдельный алгоритм действий, описанный ниже в статье.

Дополнительно в разделе «Безопасность» можно установить пароль на определенные директории, чтобы к важным папкам сайта в файловом менеджере имели доступ только те, кто знает этот пароль.

-

Капча для входа в аккаунт администратора

В том же разделе вы найдете капчу, созданную Cityhost — она защищает вход в админку на нашем сайте и в установленных на хостинге CMS. Это очень простой и ненавязчивый фильтр, в котором нужно отметить чекбокс «Я не робот» (никаких сложных процедур). Но даже такое простое действие бот уже не может выполнить.

-

Блокировка ботов в .htaccess

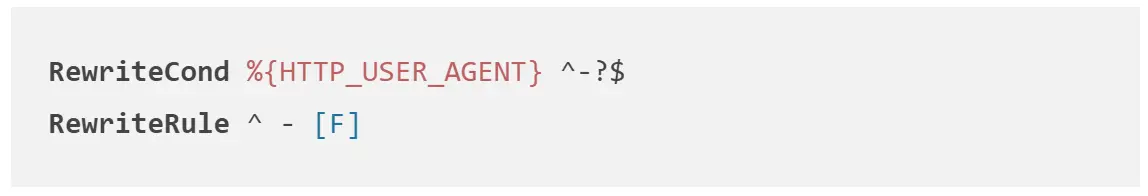

.htaccess — это файл в корневой папке сайта, содержащий определенные настройки работы веб-ресурса (редирект, создание страниц ошибок, блокировка доступа к сайту и отдельных файлов). В этом файле можно прописать запреты для юзер-агентов вредоносных роботов, которые не смогут в дальнейшем сканировать сайт.

Для этого необходимо открыть .htaccess в файловом менеджере и прописать в нем следующие правила, где UserAgentName заменить на реального юзер-агента.

Можно также заблокировать запросы от агентов, у которых нет имени.

-

Защита от спам-ботов

Боты, которые оставляют на сайте комментарии и заполняют формы обратной связи, требуют особого внимания. Для защиты от них используют следующие методы:

-

Капча в форме — обычно она выглядит как отметка чекбокса «Я не робот» и не слишком усложняет взаимодействие пользователя с сайтом.

-

Верификация почты — отправка письма на введенный адрес, чтобы пользователь прошел по ссылке и подтвердил его. Боты генерируют сотни несуществующих адресов, поэтому такой метод позволяет оставлять комментарии или заполнять формы только для реальных e-mail.

-

Ловушки для ботов — это невидимые поля, которые пользователи не заполнят просто потому, что не увидят. Боты заполняют все поля, поэтому таким образом их можно обнаруживать и фильтровать.

Как управлять деятельностью полезных ботов

Полезные боты иногда также не знают меры и посылают слишком много запросов, перегружая сайт. Но их можно «притормозить». Для каждого бота существуют свои настройки, в большинстве своем их можно найти в инструкциях на официальном сайте. Например, вот страницы, посвященные краулерам Google, Ahrefs и Serpstat:

Вы можете найти такие инструкции самостоятельно для всех полезных ботов и ограничить продолжительность и частоту сканирования, чтобы они не перегружали сайт.

В заключение отметим, что все виды вредоносных ботов можно заблокировать с помощью сервиса Cloudflare, о котором мы писали отдельную статью. Ознакомьтесь с ней и используйте эту платформу для дополнительной защиты.

Как проанализировать трафик от ботов на сайте

Посмотреть, снизилась ли нагрузка на сайт после внедрения какого-либо из методов защиты, можно в своей панели администратора на хостинге: Хостинг 2.0 => Управление => Ресурсы => разделы «Общая информация», CPU, MySQL. Но следует понимать, что изменения вы не увидите сразу — нужно, чтобы прошло хотя бы несколько часов.

Чтобы обезопасить сайт от ненужных запросов, рекомендуем регулярно мониторить показатели погрузки, логи и трафик, чтобы вовремя заблокировать ботов.

В материале использованы источники: