- Как происходит A/B-тестирование: шесть шагов от гипотезы до вывода

- Как делится трафик: методы и инструменты

- Как проводится сплит-тестирование в социальных сетях

- Типичные ошибки в A/B-тестировании

- Когда A/B-тестирование не имеет смысла

В цифровых продуктах даже мелкие детали могут влиять на поведение пользователей — от формулировки кнопки до фотографии на первом экране. Проблема в том, что заранее редко понятно, как именно сработает то или иное изменение. Даже когда решение кажется очевидным, люди могут реагировать совершенно иначе, чем ожидалось. Поэтому вместо прогнозов в какой-то момент логичнее просто посмотреть, что пользователи делают на самом деле.

Именно из этого подхода и выросло A/B тестирование — как способ проверять идеи в реальных условиях, а не обсуждать их теоретически.

Обычно один вариант — это текущая версия, а второй отличается лишь одной деталью. Если эта деталь имеет значение, разница проявляется в результатах.

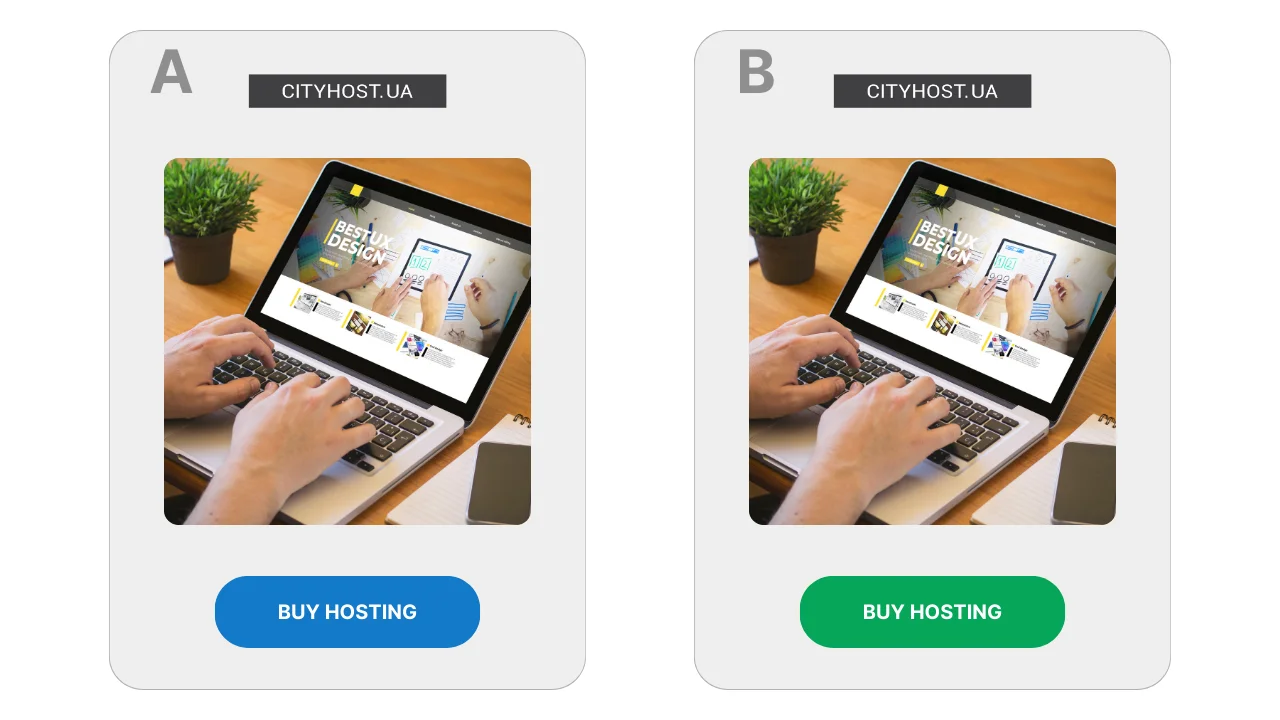

Например, на странице с продажей хостинга для сайтов кнопку оформляют в двух вариантах: синем и зеленом. Если один из них приводит к большему количеству переходов — именно его и оставляют. Здесь не идет речь о «правильном» дизайне, важна лишь реакция аудитории.

Сам принцип сравнения двух вариантов сформировался задолго до появления интернета. Его использовали в научных исследованиях, медицине, промышленности — везде, где нужно было получить объективный ответ, а не полагаться на интуицию. В цифровой среде A/B тестирование стало массовым в 2000-х годах, когда появилась возможность быстро собирать данные о поведении пользователей.

Читайте также: Что такое трафик сайта, как его узнать и зачем контролировать

Как происходит A/B-тестирование: шесть шагов от гипотезы до вывода

Сплит-тестирование редко выглядит как сложный эксперимент с формулами и графиками. Обычно это последовательность простых шагов, которые повторяются от теста к тесту, независимо от того, что именно проверяют — страницу, рекламный материал или отдельный элемент интерфейса.

- Появляется сомнение или идея. Тестирование обычно начинается с ощущения, что страница или рекламный материал могли бы работать лучше. Формально все выглядит нормально: люди заходят, читают, иногда переходят дальше. Но остается вопрос — не реагировали бы пользователи иначе, если бы подача была немного изменена?

- Формулируется гипотеза. На этом этапе появляется конкретное предположение о том, что именно может повлиять на поведение пользователей. Например, что абстрактная иллюстрация на первом экране выглядит красиво, но не создает ощущения вовлеченности — почему бы не заменить ее на фото реального человека? Или что блок с ответами на типичные вопросы стоит показать раньше, чтобы снять часть сомнений еще до принятия решения.

- Готовятся два варианта. Один вариант остается без изменений и служит точкой отсчета. Второй отличается лишь одной деталью, которую и проверяют в тесте. Если изменять несколько элементов одновременно, результат будет сложно объяснить, даже если он будет казаться положительным.

- Запускают тест и наблюдают. При этом система запоминает, какой вариант был показан конкретному пользователю, и при повторных визитах демонстрирует тот же. Это важно для чистоты эксперимента — человек не должен «перескакивать» между версиями.

- Выбирают показатель и дают тесту время. Заранее определяют, на что именно будут смотреть: переходят ли пользователи дальше, взаимодействуют с контентом, доходят до нужного шага. Первые результаты обычно не показательные, поэтому тесту дают поработать достаточно долго.

- Делают вывод. Когда данных становится больше, становится понятно, была ли между вариантами ощутимая разница. Иногда она очевидна, иногда — настолько незначительна, что менять что-то не имеет смысла. Бывает и так, что тест не дает четкого ответа, и это тоже результат: он означает, что конкретное изменение не повлияло на поведение пользователей.

Такой подход позволяет проверять изменения без риска сломать рабочий вариант: пока тест продолжается, часть пользователей продолжает видеть привычную версию. Это особенно важно, когда речь идет о страницах, которые уже приносят заявки или продажи.

Читайте также: Как подготовить сайт к подключению платежной системы

Как делится трафик: методы и инструменты

- Основной принцип распределения трафика

- Почему не стоит делить трафик через две разные страницы

- Инструменты для разделения трафика

В любом A/B тесте ключевым является не сама идея изменения, а то, как именно пользователи попадают на разные варианты. Если этот этап организован неправильно, результаты теста теряют смысл, даже если цифры выглядят убедительно.

Трафик почти никогда не делят вручную. Причина проста: люди могут возвращаться на сайт несколько раз, заходить с разных устройств или попадать на страницу из разных источников. Без специальных инструментов невозможно гарантировать, что один и тот же человек не увидит оба варианта.

Основной принцип распределения трафика

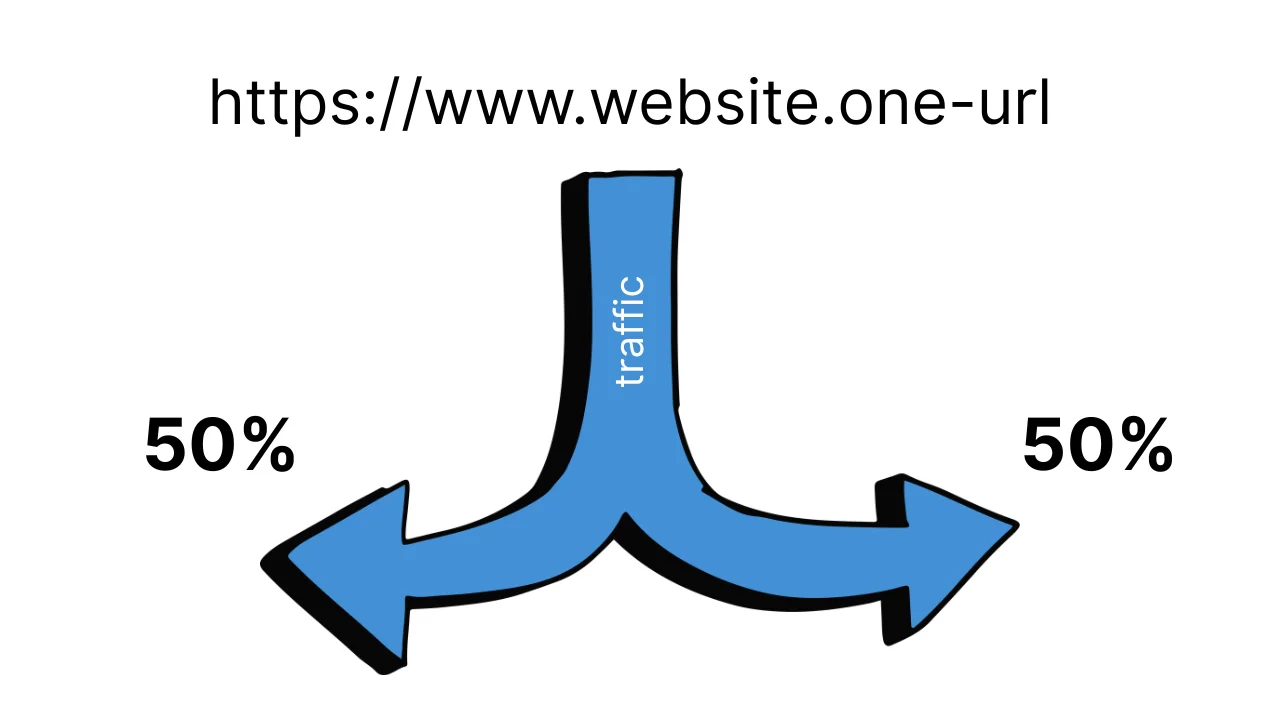

В классическом A/B тестировании используется один URL-адрес, а система тестирования уже внутри решает, какой вариант показать конкретному пользователю. Обычно это происходит случайным образом, например в пропорции 50/50.

Важный момент: после первого показа выбор фиксируется. Если пользователь возвращается на страницу, он видит тот же вариант, что и раньше. Это позволяет избежать путаницы и не влиять на поведение людей искусственными «переключениями».

Почему не стоит делить трафик через две разные страницы

Распространенная ошибка — создать две страницы и просто вести на них трафик из разных рекламных объявлений. Формально это выглядит как тест, но при попытке его реализации возникает несколько проблем:

- один пользователь может увидеть обе версии;

- аудитории в рекламе могут пересекаться;

- результаты сильно зависят от источника трафика, а не от самого изменения.

В таком формате сложно понять, что именно повлияло на результат — страница, реклама или случайность.

Читайте также: Трафик + CPA-маркетинг: как заработать на партнерских оферах

Инструменты для разделения трафика

Чтобы избежать этих проблем, используют специальные сервисы для A/B тестирования. Они берут на себя распределение трафика, фиксацию вариантов и сбор статистики.

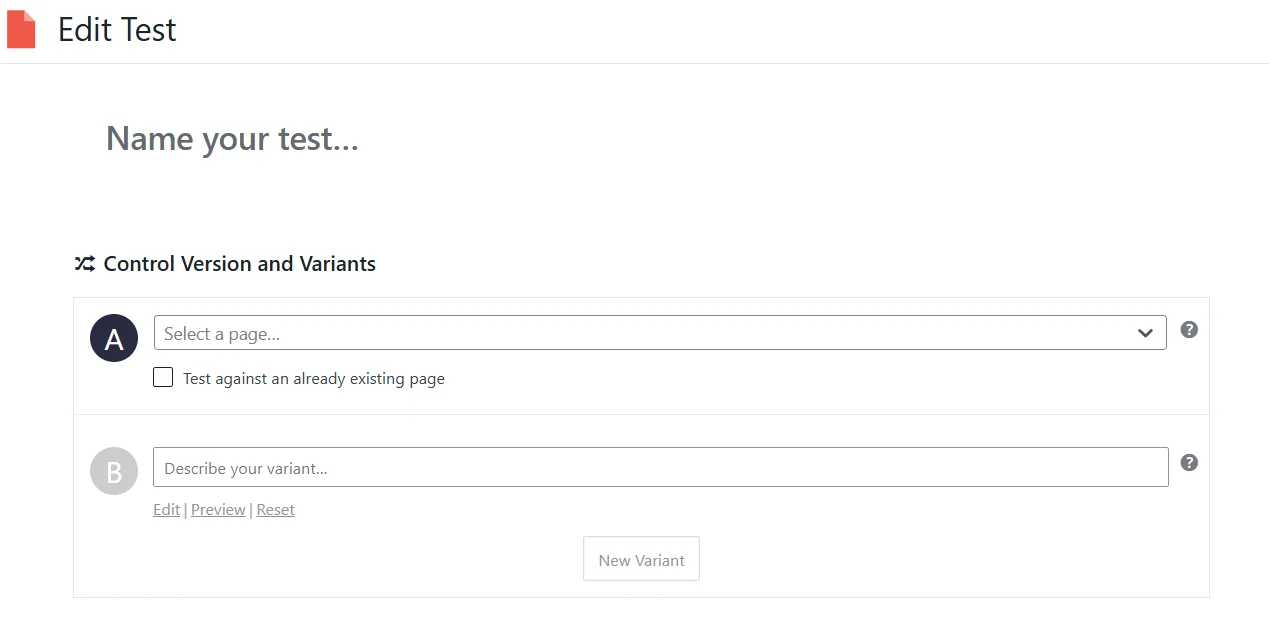

Для сайтов на WordPress часто выбирают Nelio A/B Testing. Это плагин, который позволяет тестировать страницы, заголовки и отдельные элементы без работы с кодом. Варианты создаются прямо в админке, а трафик делится автоматически.

Для лендингов и маркетинговых страниц без сложной логики подходит Split Hero. Сервис работает по принципу подмены страниц и сам следит за тем, чтобы пользователи видели стабильный вариант.

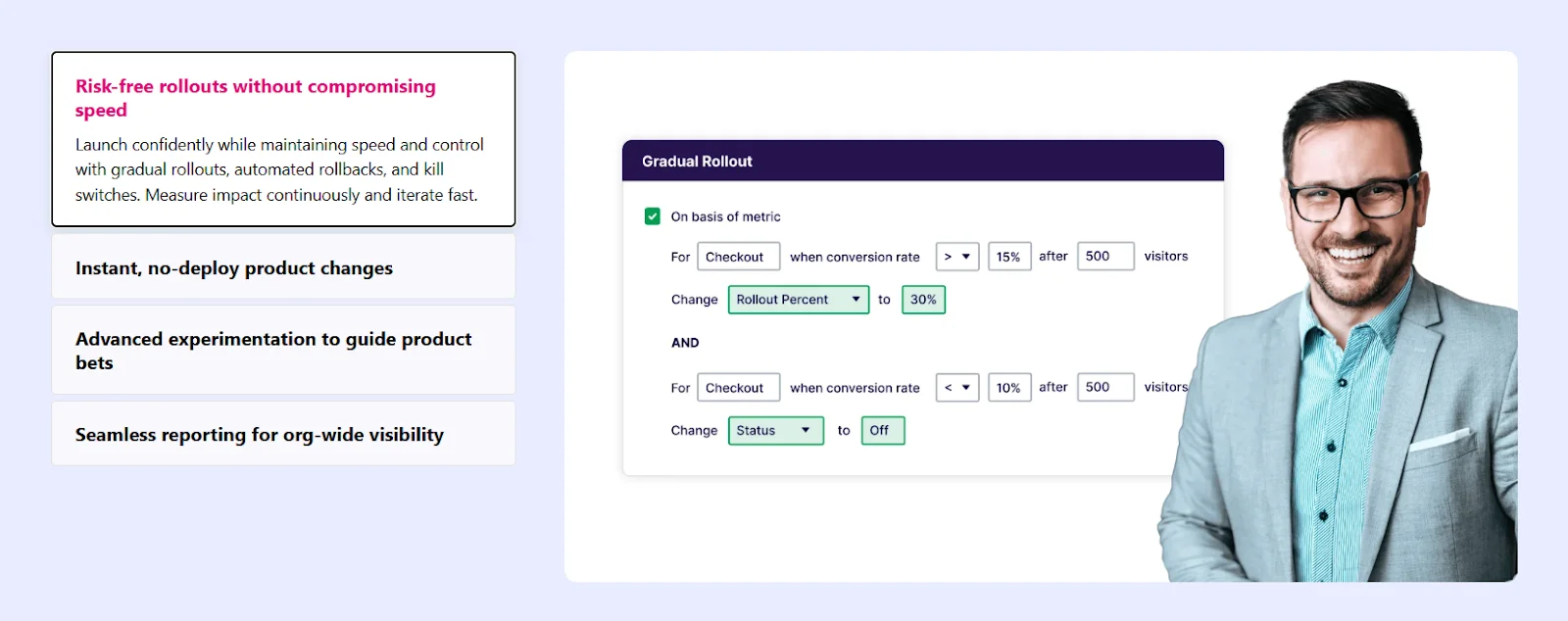

Более универсальным решением считается VWO. Он позволяет тестировать как страницы целиком, так и отдельные элементы через визуальный редактор. Такие сервисы часто используют в маркетинговых командах, где важно быстро запускать тесты без привлечения разработчиков.

Для крупных проектов и сложных продуктов существуют решения наподобие Optimizely, где распределение трафика может происходить на серверном уровне. Это дает более чистые результаты, но требует технических ресурсов и опыта.

Как осуществляется сплит-тестирование в социальных сетях

- Как работает сплит-тестирование рекламы в Facebook

- Как запустить сплит-тестирование рекламы в TikTok

- Как проводить A/B-тестирование в YouTube

В социальных сетях сплит-тестирование имеет принципиальное ограничение: для органических постов Facebook, Instagram, TikTok и YouTube не существует инструментов A/B тестирования. Соцсети не дают возможности контролируемо разделять аудиторию между двумя версиями поста, фиксировать показ для конкретного пользователя или обеспечивать равномерное распределение просмотров. Поэтому корректно протестировать органический контент технически невозможно.

Идея просто опубликовать два похожих поста с разной подачей выглядит логичной, но на самом деле она не дает достоверного результата. Одни и те же пользователи могут увидеть оба поста, причем в разное время и в разных контекстах. Алгоритмы соцсетей дополнительно вмешиваются в показы: если один пост быстрее набирает реакции, он начинает показываться активнее, тогда как другой почти исчезает из ленты. На результат также влияют время публикации, день недели, общий информационный фон и текущая активность аудитории. В итоге сравнивается не эффективность двух вариантов, а совокупность внешних факторов и решений алгоритма.

В то же время отдельные платформы постепенно внедряют встроенные автоматические эксперименты для конкретных форматов контента. Например, в Meta доступно A/B тестирование для Reels. В этом случае платформа позволяет создать несколько вариантов обложки или подписи к одному видео. Далее система сама делит аудиторию на подгруппы, оценивает реакцию в течение короткого времени (обычно по количеству воспроизведений) и автоматически выбирает вариант, который показал лучший результат.

Важно понимать, что такой механизм не является классическим A/B тестированием. Пользователь не контролирует ни распределение аудитории, ни продолжительность теста, ни набор метрик — все решения принимает алгоритм платформы. По сути, это быстрый алгоритмический отбор варианта для дальнейшего распространения, а не полноценный эксперимент с детальным анализом.

Полноценное сплит-тестирование в социальных сетях возможно только в рекламе. Рекламные кабинеты платформ наподобие Meta и TikTok имеют специальные режимы экспериментов, в которых платформа сама делит аудиторию между вариантами. В таком формате каждый пользователь видит лишь одну версию объявления, а результаты собираются параллельно и без пересечения показов.

В рекламном сплит-тестировании обычно меняют один параметр: креатив, текст, заголовок, призыв к действию или аудиторию. Остальные условия остаются одинаковыми, что позволяет связать результат именно с конкретным изменением.

Как работает сплит-тестирование рекламы в Facebook

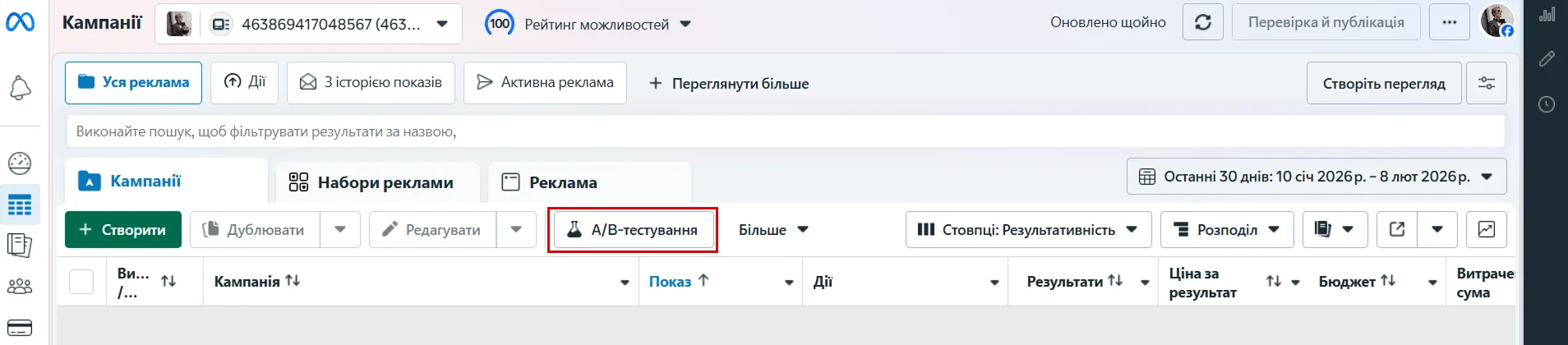

Стоит знать, что сплит-тестирование рекламы в TikTok и Facebook доступно только в браузерной версии рекламного кабинета. Мобильные приложения не поддерживают создание A/B тестов, поэтому запустить их с телефона невозможно.

В рекламном кабинете Facebook эта функция запускается через кнопку «A/B-тестирование» в верхней панели Ads Manager. Тестирование всегда создается на базе существующего рекламного объекта — кампании, набора объявлений или конкретного рекламного поста.

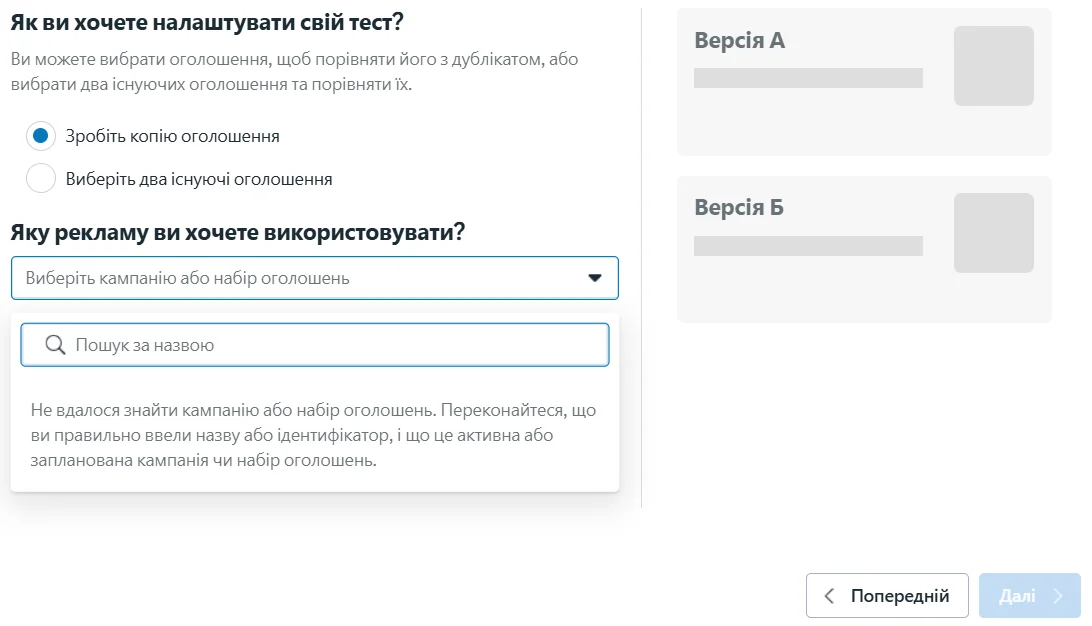

После нажатия кнопки Facebook предлагает выбрать, как именно будет настроен тест. Есть два варианта: либо взять одно объявление и создать его копию для сравнения, либо выбрать два уже созданных объявления. В любом случае система просит указать кампанию, набор объявлений или конкретный рекламный пост, который станет основой теста.

Далее логика теста стандартная: система формирует две версии рекламы, делит аудиторию между ними и показывает каждый вариант отдельной группе пользователей. После завершения теста Facebook сравнивает результаты и показывает, какой вариант сработал лучше.

Как запустить сплит-тестирование рекламы в TikTok

Чтобы запустить A/B-тестирование в TikTok, нужно работать с браузерной версией рекламного кабинета. В самом приложении TikTok или в TikTok Studio этой функции нет, поэтому первый шаг — зайти на сайт ads.tiktok.com и войти в свой рекламный аккаунт. Если аккаунта еще нет, система проведет через стандартную регистрацию с выбором страны, типа бизнеса и настройкой оплаты.

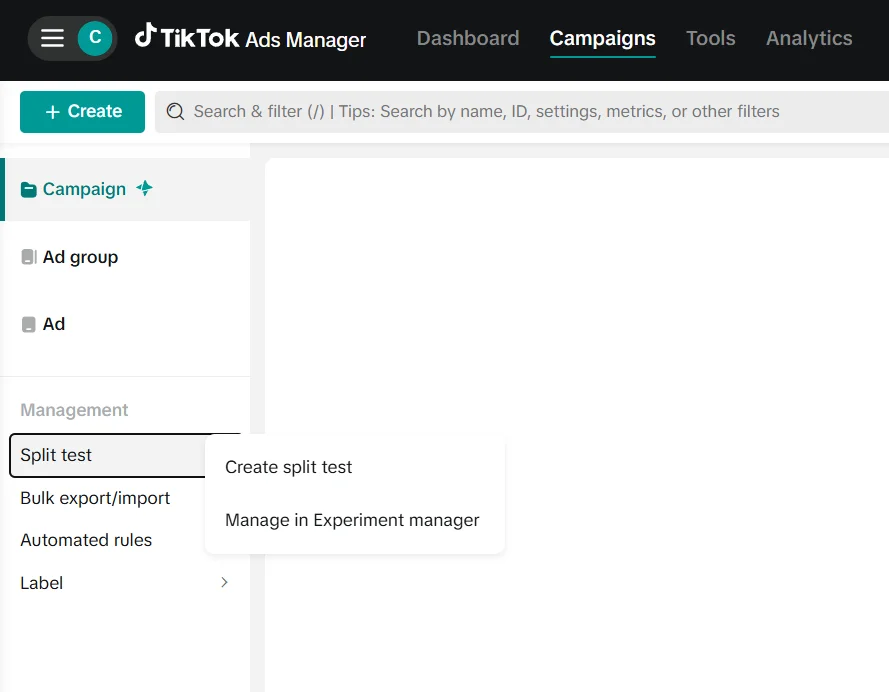

После входа открывается TikTok Ads Manager. В верхнем меню нужно перейти в раздел Campaigns. Именно здесь находятся все кампании, группы объявлений и инструменты управления рекламой. В левой колонке, ниже основной структуры кампаний, есть блок Management. В нем расположен пункт Split test — это и есть точка входа в сплит-тестирование.

Нажав Split test, нужно выбрать Create split test.

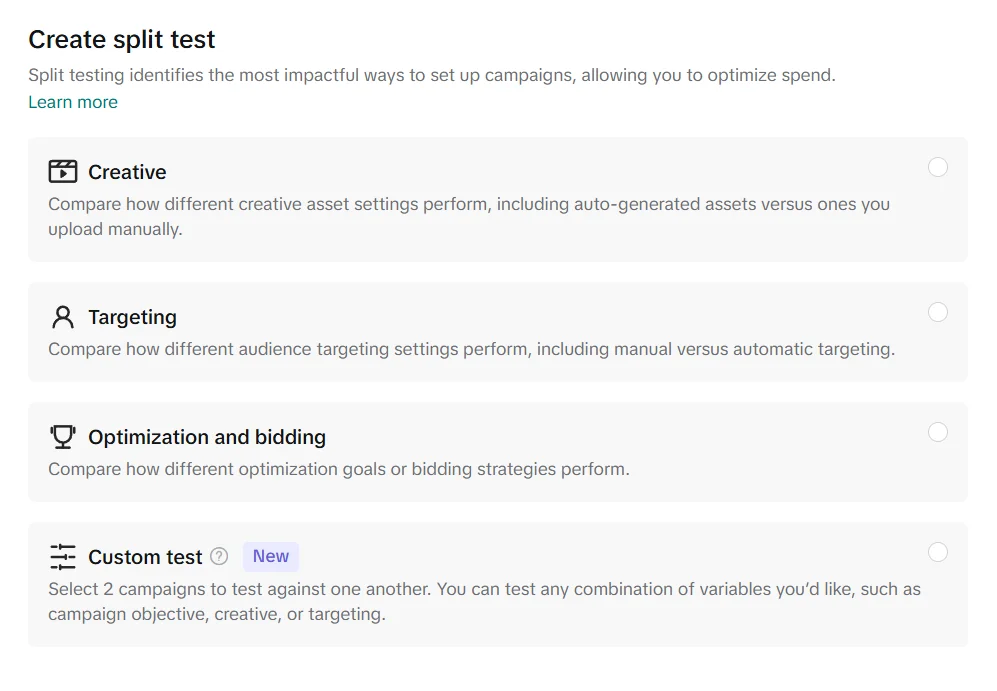

После этого нужно выбрать, что именно будет тестироваться. TikTok предлагает несколько вариантов: тестирование креативов, настроек аудитории или стратегий оптимизации и ставок. Есть также режим Custom test, который позволяет сравнивать две кампании с любой комбинацией изменений.

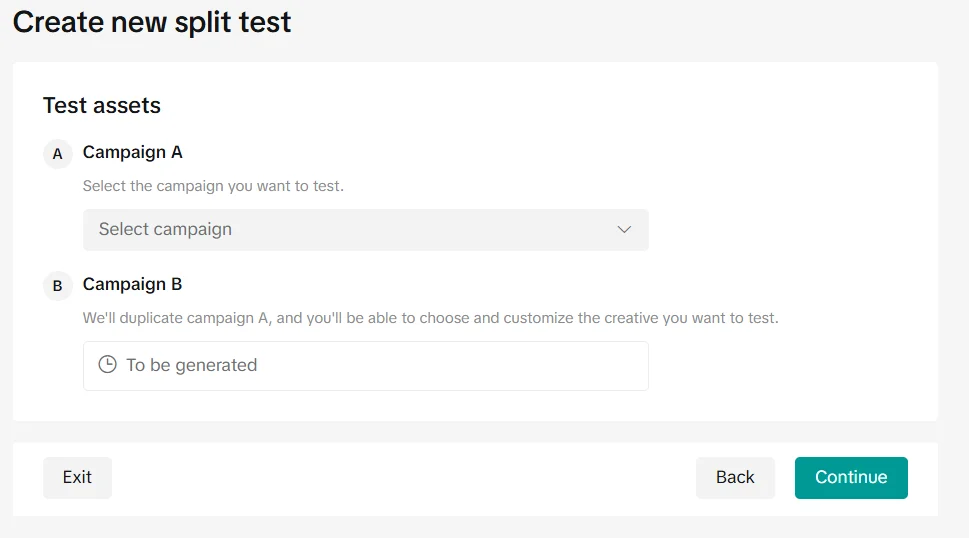

На следующем шаге нужно выбрать рекламный объект для сравнения. Система предлагает определить Campaign A — существующую кампанию, которая будет использована как базовая версия. Campaign B создается автоматически путем копирования первой кампании, после чего в ней можно изменить лишь тот параметр, который выбран для тестирования. Таким образом обе кампании имеют одинаковые настройки, а разница между ними сводится к одному контролируемому изменению.

После подтверждения настроек и нажатия Continue сплит-тест запускается. После завершения тестирования система показывает, какой вариант оказался эффективнее по выбранной метрике.

Читайте также: Как раскрутить сайт с помощью соцсетей

Как проводить A/B-тестирование в YouTube

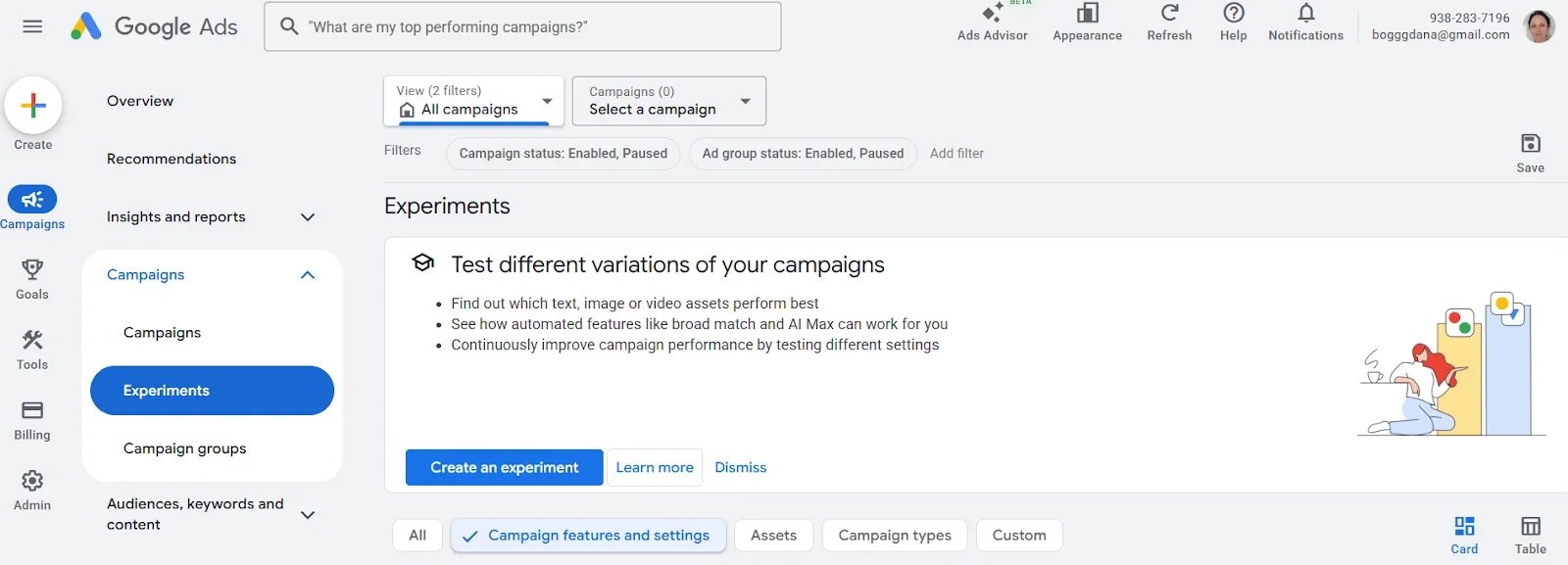

Сплит-тестирование видеорекламы YouTube проводится не в YouTube Studio, а через рекламный кабинет Google Ads.

Первый шаг — зайти на сайт ads.google.com и войти в свой аккаунт Google Ads. После входа нужно перейти в раздел кампаний и убедиться, что у вас уже есть созданная видеокампания для YouTube или по крайней мере подготовленный креатив, с которым вы планируете работать.

После перехода в Campaigns → Experiments открывается страница для создания экспериментов. Именно здесь Google Ads предлагает протестировать различные вариации кампаний — креативы, настройки или отдельные параметры показа. Для запуска сплит-теста нужно нажать кнопку Create an experiment.

Далее система просит выбрать базовую кампанию, которая уже существует в аккаунте. На ее основе Google Ads создает тестовую версию, в которой можно изменить один или несколько параметров в зависимости от типа эксперимента. После этого задается распределение трафика между оригинальной кампанией и тестовой версией, а также продолжительность эксперимента.

Результаты эксперимента отображаются в этом же разделе Experiments и позволяют увидеть, какая версия рекламы показала лучшие результаты по выбранным метрикам.

Типичные ошибки в A/B-тестировании

Даже правильно настроенное A/B-тестирование может дать ложные выводы, если ошибиться на этапе планирования или анализа результатов. Чаще всего проблемы возникают не из-за инструментов, а из-за спешки и неправильной интерпретации данных.

- Тестирование нескольких изменений одновременно. Когда в одном тесте меняют сразу несколько элементов, становится непонятно, что именно повлияло на результат. Даже положительный итог в таком случае сложно использовать на практике.

- Слишком короткое тестирование и малая выборка данных. Первые результаты часто выглядят убедительно, но обычно это лишь случайные колебания. Если тест останавливают рано или анализируют данные с небольшой выборки, выводы могут быть ложными.

- Изменение условий во время теста. Корректировка бюджета, таргетинга или других настроек в процессе тестирования нарушает равенство условий. В такой ситуации сравнение вариантов уже не является корректным.

- Ожидание большого эффекта от незначительных изменений. Не каждая правка заметно влияет на поведение пользователей. Отсутствие разницы между вариантами — это нормальный результат, а не признак провала.

- Убеждение, что тест всегда должен дать четкий ответ. Иногда A/B-тестирование лишь подтверждает, что оба варианта работают одинаково. Это сигнал не «искать победителя», а формировать новые гипотезы.

Когда A/B-тестирование не имеет смысла

A/B-тестирование часто воспринимается как универсальный инструмент для принятия решений. Но есть ситуации, в которых оно либо не дает полезной информации, либо создает иллюзию контроля, не приближая к реальному пониманию проблемы. Чаще всего это происходит в таких случаях.

- Когда недостаточно трафика. Если на страницу или рекламную кампанию приходит небольшое количество пользователей, результаты теста будут нестабильными и случайными.

Если на лендинг заходит 20-30 человек в день, и тестируются два варианта кнопки, то через неделю один вариант будет иметь четыре клика, другой — шесть. Формально разница есть, но она легко объясняется случайностью, а не реальным преимуществом.

- Когда продукт или предложение непонятны аудитории. Если люди не понимают, что им предлагают и зачем это им нужно, изменение заголовка, кнопки или изображения не повлияет на решение.

Например, сервис продает доменные имена, но на первом экране страницы использует размытые формулировки. Команда запускает A/B-тест двух заголовков:

- «Инфраструктурные решения для онлайн-присутствия»

- «Запусти свой проект в интернете уже сегодня»

Оба варианта показывают схожие результаты, потому что пользователи так и не понимают, что именно им предлагают: домен, хостинг, VPS или вообще комплексную услугу. В такой ситуации тест не выявляет лучший вариант, ведь проблема не в конкретном формулировании, а в самой ясности предложения.

- Когда тестируют не тот уровень проблемы. Если реклама не работает из-за неудачной аудитории или слабой идеи в целом, проверка мелких правок лишь подтвердит отсутствие результата.

Представим, что реклама показывается очень широкой аудитории, которая не имеет потребности в продукте. Вместо просмотра таргетинга запускают A/B-тест двух текстов объявления. Оба варианта работают плохо — и тест лишь фиксирует это, не решая причину.

- Когда кампания имеет короткий жизненный цикл. Рекламные кампании или страницы, которые существуют несколько дней или неделю, просто не успевают собрать достаточно данных.

- Когда от тестирования ожидают готовых ответов. A/B-тест не подсказывает, что делать дальше, если оба варианта показали схожие результаты.

В итоге A/B-тестирование лучше всего работает там, где есть понятный продукт, стабильный поток пользователей и четкая гипотеза для проверки. В других случаях оно может быть преждевременным — и это не ошибка, а подсказка изменить фокус работы.

Хорошо настроенный тест показывает, имеет ли конкретное изменение заметное влияние. Иногда он выявляет лучший вариант, иногда — подтверждает, что разницы нет. Оба результата полезны, если их правильно интерпретировать.