-

Wie man die Website mit robots.txt von der Indizierung ausschließt

-

Wie man die Website während der Entwicklung auf Serverebene versteckt

-

Wie man die Website während der Entwicklung mit Cityhost-Tools versteckt

-

Wie man herausfindet, ob die Website während der Entwicklung verborgen wurde

Bei der Erstellung einer Website auf Hosting sollte sie von der Indizierung ausgeschlossen werden, da sonst nicht optimierte Inhalte und Seiten-Duplikate sofort in die Suchergebnisse gelangen. Man sollte auch darauf achten, die Website vor Benutzern zu verbergen, da sie sofort weggehen, wenn sie auf eine leere Seite gelangen, was sich negativ auf das Ranking auswirken wird.

In diesem Artikel werden wir erläutern, wie man die Website während der Entwicklung versteckt und eine Schritt-für-Schritt-Anleitung zur Sperrung der Website mit Cityhost-Tools geben.

Wie man die Website während der Entwicklung mit robots.txt versteckt

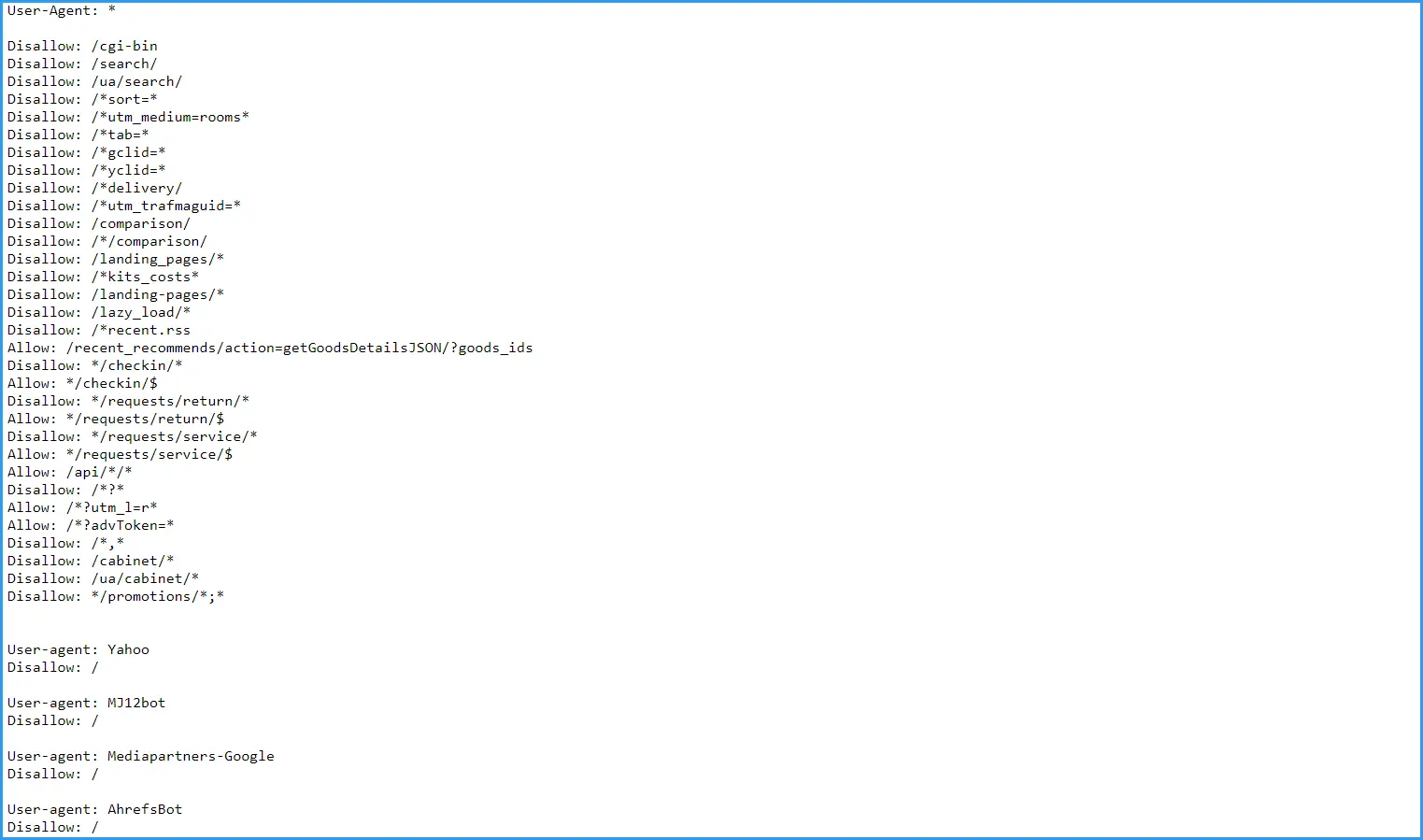

Die Datei robots.txt — ein Textdokument, das dazu dient, das Verhalten von Suchrobotern (Crawlers) beim Scannen eines Internetprojekts zu steuern. Sie greifen zuerst auf diese Datei zu und folgen dann den angegebenen Anweisungen (Direktiven): Zum Beispiel werden einige Teile der Website gescannt, während andere ignoriert werden.

Sie können Standardanweisungen verwenden, um die Website während der Entwicklung teilweise oder vollständig zu schließen. Um die Website richtig von der Indizierung auszuschließen, müssen Sie die grundlegenden Direktiven von robots.txt kennen:

-

User-agent — definiert einen oder eine Gruppe von Robotern, die sich an die angegebenen Anweisungen halten sollen;

-

Disallow — verbietet die Indizierung bestimmter Seiten oder ganzer Verzeichnisse;

-

Allow — erlaubt die Indizierung von Seiten oder Verzeichnissen, damit Sie den Zugriff der Roboter auf spezifische Informationen auf der Website genauer steuern können;

-

Sitemap — gibt den Pfad zur XML Sitemap-Datei an (enthält eine Liste aller verfügbaren Seiten), um den Suchrobotern zu helfen, die Website effizienter zu indizieren.

Basierend auf den oben beschriebenen Direktiven können Sie die Website problemlos von der Suche ausschließen, indem Sie folgende Kombination von Anweisungen verwenden:

User-agent: *

Disallow: /

Im obigen Beispiel zeigt das Zeichen «*» nach «User-agent», dass die Direktiven «Disallow» für alle Roboter gelten. Die Anweisung «Disallow: /» bedeutet, dass alle Seiten und Verzeichnisse auf der Website von der Indizierung ausgeschlossen sind.

Viele Benutzer fragen sich, wie man die Website von der Indizierung ausschließt, während der Zugang zu einer Suchmaschine erhalten bleibt. Dazu betrachten wir folgendes Beispiel:

User-agent: *

Disallow: /

User-agent: Google

Allow: /

In diesem Fall wird die Indizierung nur für die Google-Roboter verfügbar sein. Sie können jede andere Suchmaschine angeben, indem Sie ihren Namen anstelle von Google einsetzen.

Eine weitere nützliche Anweisung:

User-agent: *

Disallow: /

Allow: /$

Diese Direktive ermöglicht es, das Internetprojekt von der Indizierung auszuschließen und die Startseite verfügbar zu lassen. Dies ist besonders nützlich für neue Websites, da Sie das Projekt in Ruhe einrichten können, während die Suchmaschinen von seiner Existenz erfahren und es somit früher Vertrauen aufbauen wird.

Lesen Sie auch: Wie man die Autorität der Domain erhöht: Überprüfung und Verbesserung des DA-Werts

Wie man die Website während der Entwicklung auf Serverebene versteckt

Die Schließung der Website von der Indizierung über robots.txt ist die gebräuchlichste, aber nicht 100% sichere Methode. Sie gibt nur Anweisungen, aber ob diesen gefolgt wird oder nicht, entscheidet die jeweilige Suchmaschine. In einigen Fällen ignorieren Suchmaschinen die Verbote und indizieren alle Daten. Dies geschieht selten, aber es ist äußerst unerwünscht, ein junges Projekt diesem Risiko auszusetzen.

Wir empfehlen, zusätzlich die Daten auf Serverebene vor Suchmaschinen zu schützen. Dazu verwenden Sie die .htaccess-Datei, die im Stammverzeichnis der Website gespeichert ist (falls das Dokument fehlt, erstellen Sie es). Fügen Sie die folgende Zeile hinzu:

Options -Indexes

Sie können auch speziellen Code in die Datei einfügen, der das Scannen durch bestimmte Roboter verbietet. Zum Beispiel, wie man die Website von Google-Suche ausschließt. Fügen Sie der .htaccess-Datei folgende Direktive hinzu:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} UserAgentName [NC]

RewriteRule .* - [F,L]

Ersetzen Sie UserAgentName durch den Namen des Bots — für Google ist es Googlebot.

Durch die Kombination beider Methoden erzielen Sie die maximale Wirkung: robots.txt sorgt für die vollständige Schließung der Website, während .htaccess eine zusätzliche Sicherheitsebene bietet. Der einzige Nachteil ist, dass Sie wichtige Dateien der Website manuell bearbeiten müssen, was ein gewisses, wenn auch minimales Risiko birgt, diese zu beschädigen.

Wie man die Website auf WordPress versteckt

Nun lassen Sie uns den Algorithmus zur Schließung von Daten für Websites, die mit dem beliebten CMS WordPress entwickelt wurden, betrachten. Der gesamte Prozess kann in zwei Phasen unterteilt werden: Schließung der Daten vor Suchrobotern und Installation eines Dummy-Banners für Besucher.

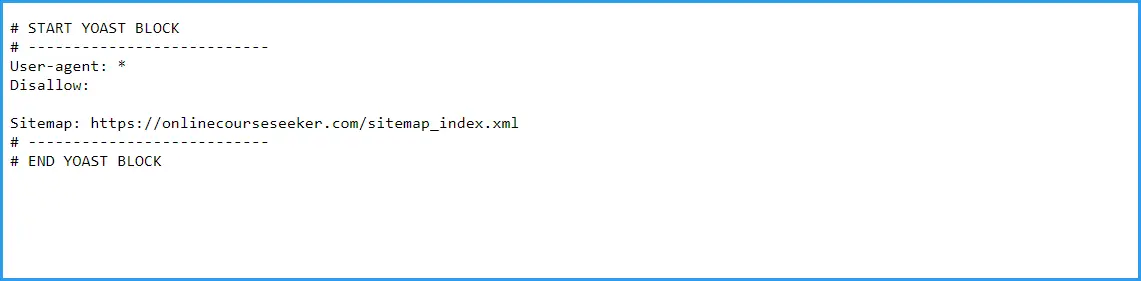

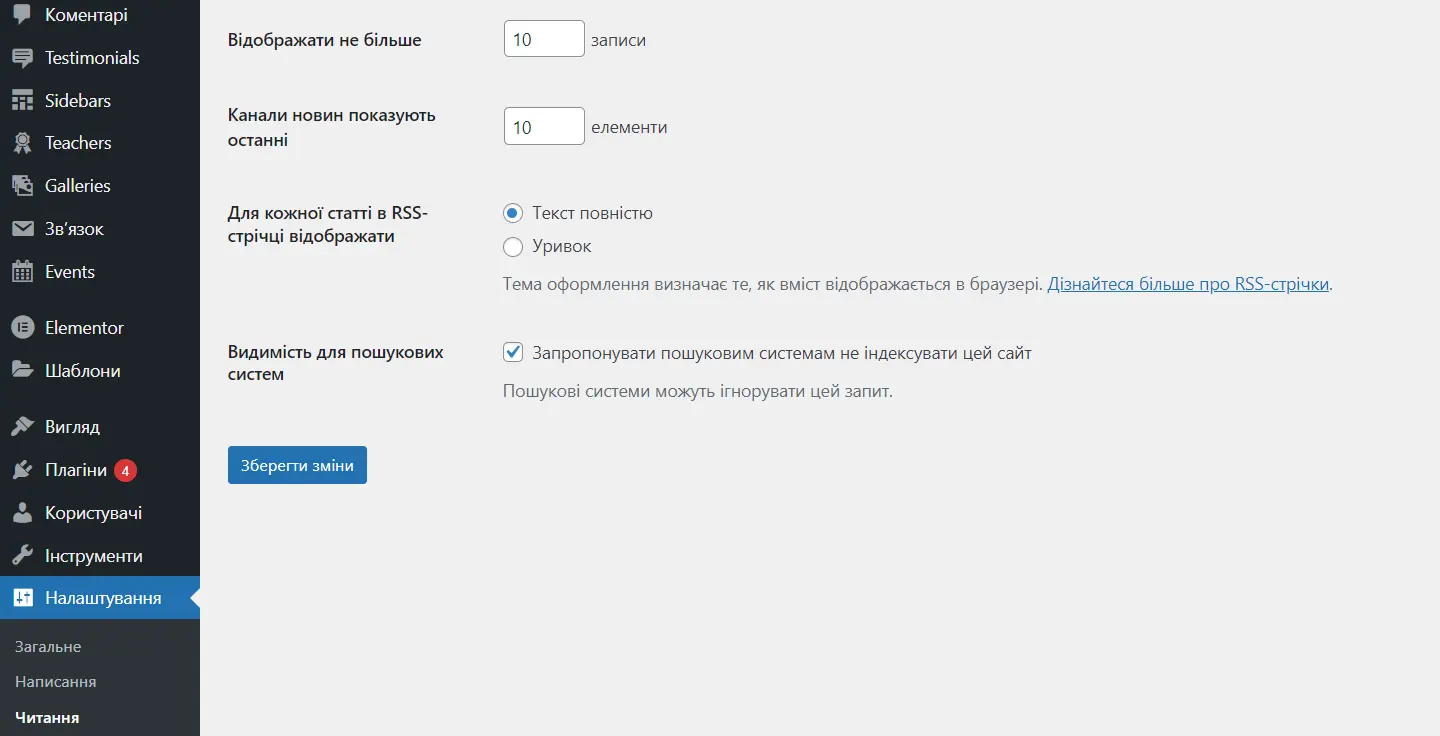

Wie man die Indizierung der Website auf WordPress verbietet

Die Entwickler des bekannten Content-Management-Systems WordPress haben die Möglichkeit vorgesehen, Daten vor Crawlers zu verstecken, und den Prozess dabei möglichst zu vereinfachen.

Gehen Sie im Dashboard zu «Einstellungen» — «Lesen», wählen Sie «Suchmaschinen bitten, die Website nicht zu indizieren», und klicken Sie auf «Änderungen speichern».

Das System bearbeitet automatisch die robots.txt-Datei, und es bleibt Ihnen nur noch, vor dem Start des Projekts das Kontrollkästchen zu deaktivieren. Wenn Sie das Plugin Yoast SEO verwenden, wird eine solche Erinnerung ständig beim Zugriff auf das Dashboard angezeigt.

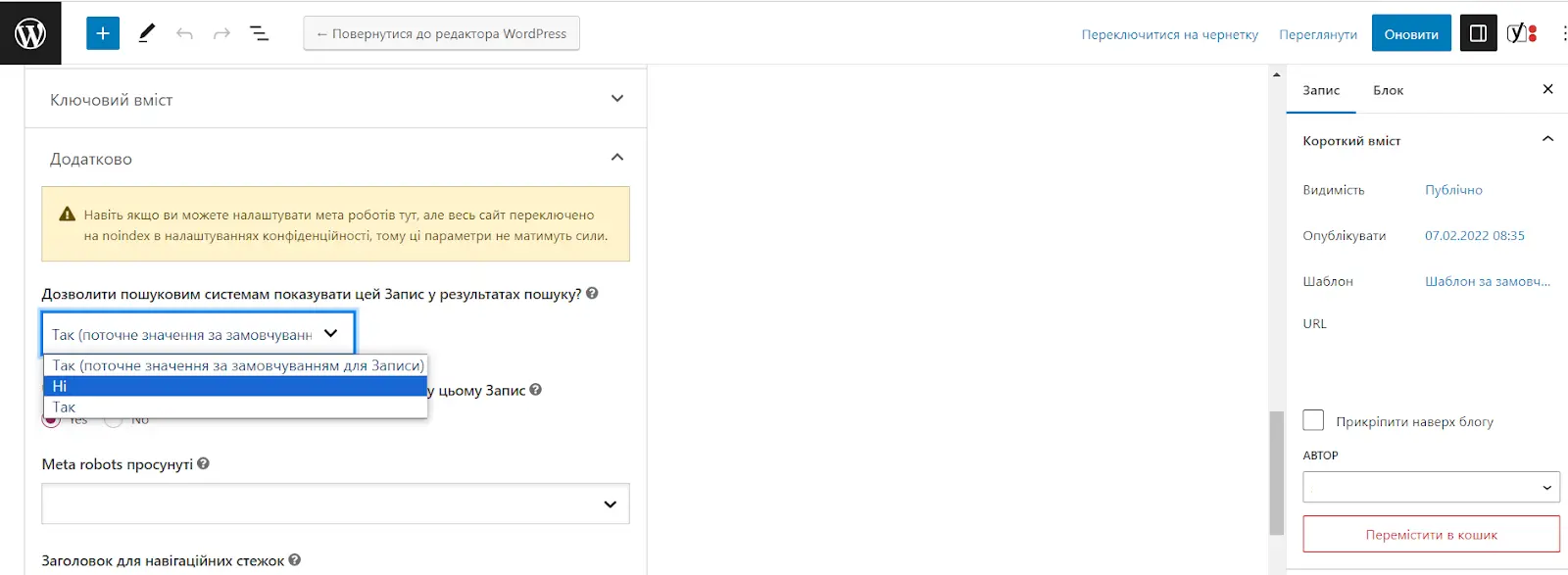

Übrigens ist das Plugin Yoast SEO praktisch, um einzelne Seiten von der Indizierung auszuschließen. Öffnen Sie einfach den Post (die Seite) zur Bearbeitung und suchen Sie die Registerkarte «Erweitert». Wählen Sie im Punkt «Suchmaschinen erlauben, den Beitrag in den Suchergebnissen anzuzeigen» die Option «Nein». Sie können auch angeben, ob die Roboter den Links in diesem Beitrag folgen sollen, und aus dem Dropdown-Menü der «Erweiterten Meta-Robots-Einstellungen» den Punkt «Bilder nicht indizieren» auswählen.

Sind Sie nicht auch der Meinung, dass es viel bequemer ist, ein Kontrollkästchen in den allgemeinen Einstellungen zu setzen, als die robots.txt-Datei manuell zu bearbeiten? Das Problem ist nur, dass nicht alle Content-Management-Systeme es so einfach ermöglichen, Daten vor Suchmaschinen zu verbergen. Aber hier wird Ihnen die Funktionalität von Cityhost helfen, die wir im Folgenden genauer erläutern, und lassen Sie uns zunächst lernen, wie man ein informatives Dummy-Banner auf WordPress installiert.

Lesen Sie auch: Wie man die Website auf WordPress schützt und nicht Opfer von Sicherheitsanfälligkeiten des offenen Codes wird

Wie man die Website auf Wordpress für Besucher sperrt

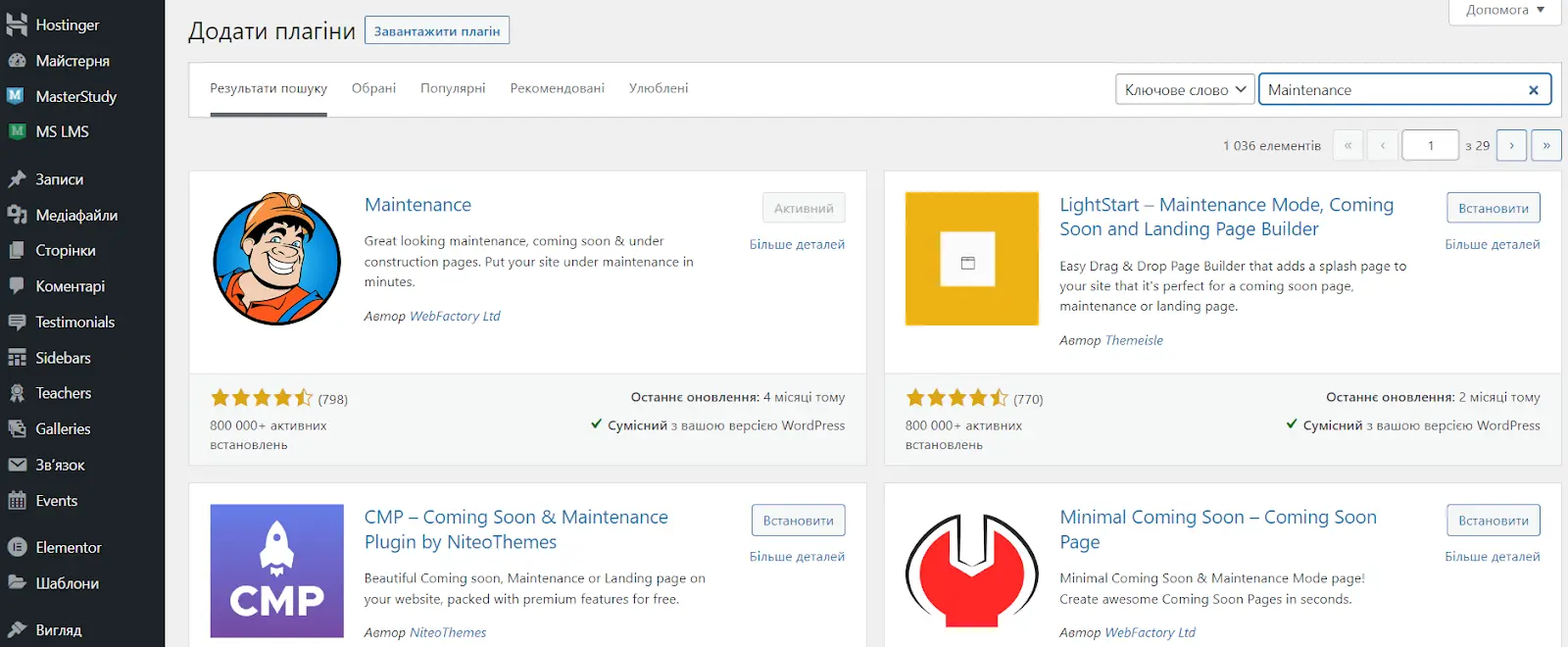

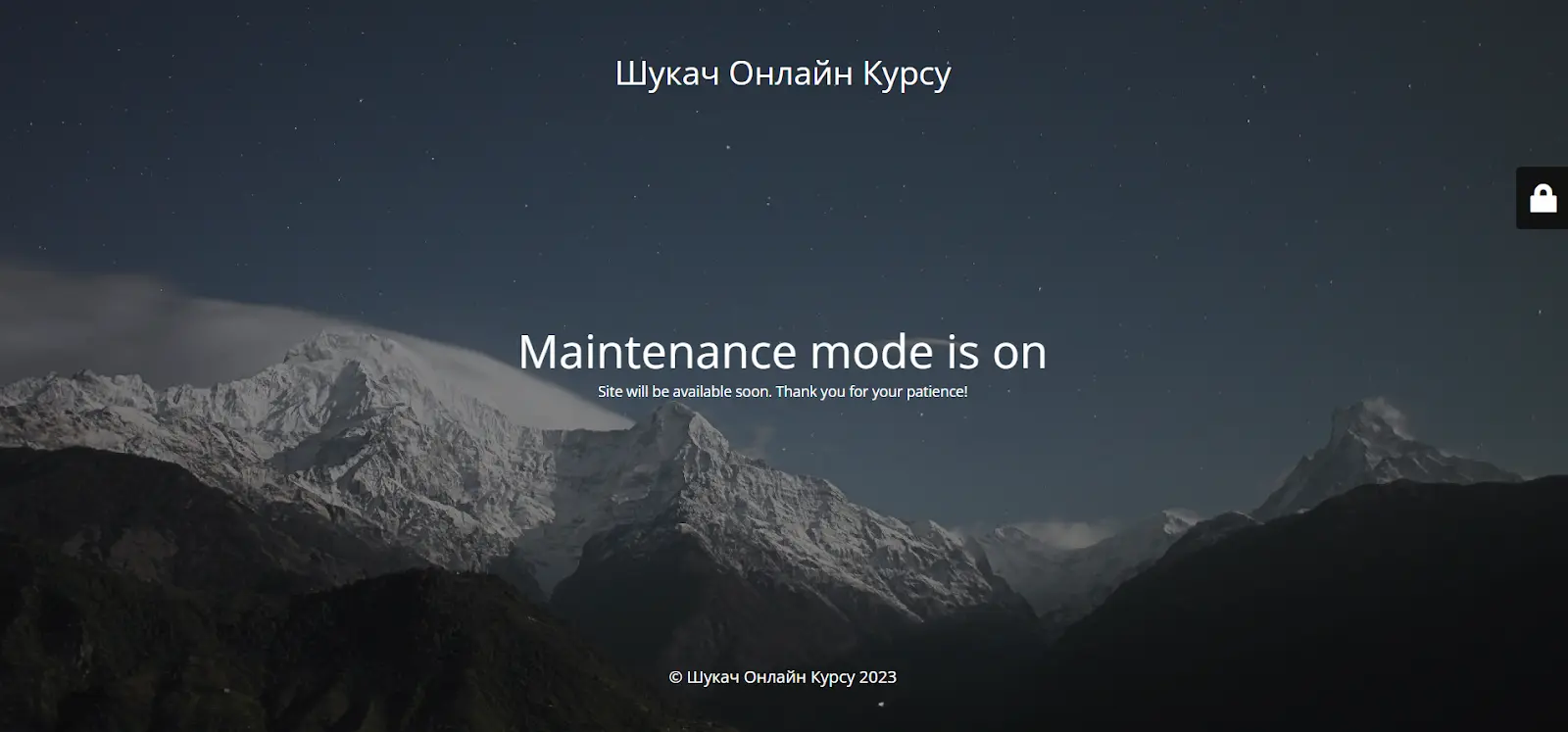

Maintenance — eines der beliebtesten WordPress-Plugins, das es ermöglicht, einfach ein Dummy-Banner zu installieren und einzurichten. Sie können ein Hintergrundbild hinzufügen, Nachrichten und Kontaktdaten hinterlassen, wodurch Sie während der Entwicklung der Website potenzielle Kunden nicht verlieren.

Um das Maintenance-Plugin zu installieren, gehen Sie wie folgt vor:

-

Gehen Sie im Dashboard zur Registerkarte «Plugins».

-

Klicken Sie auf «Neu hinzufügen».

-

Klicken Sie auf die Installation neben dem gewünschten Plugin (das erste in der Liste).

-

Aktivieren Sie die Erweiterung.

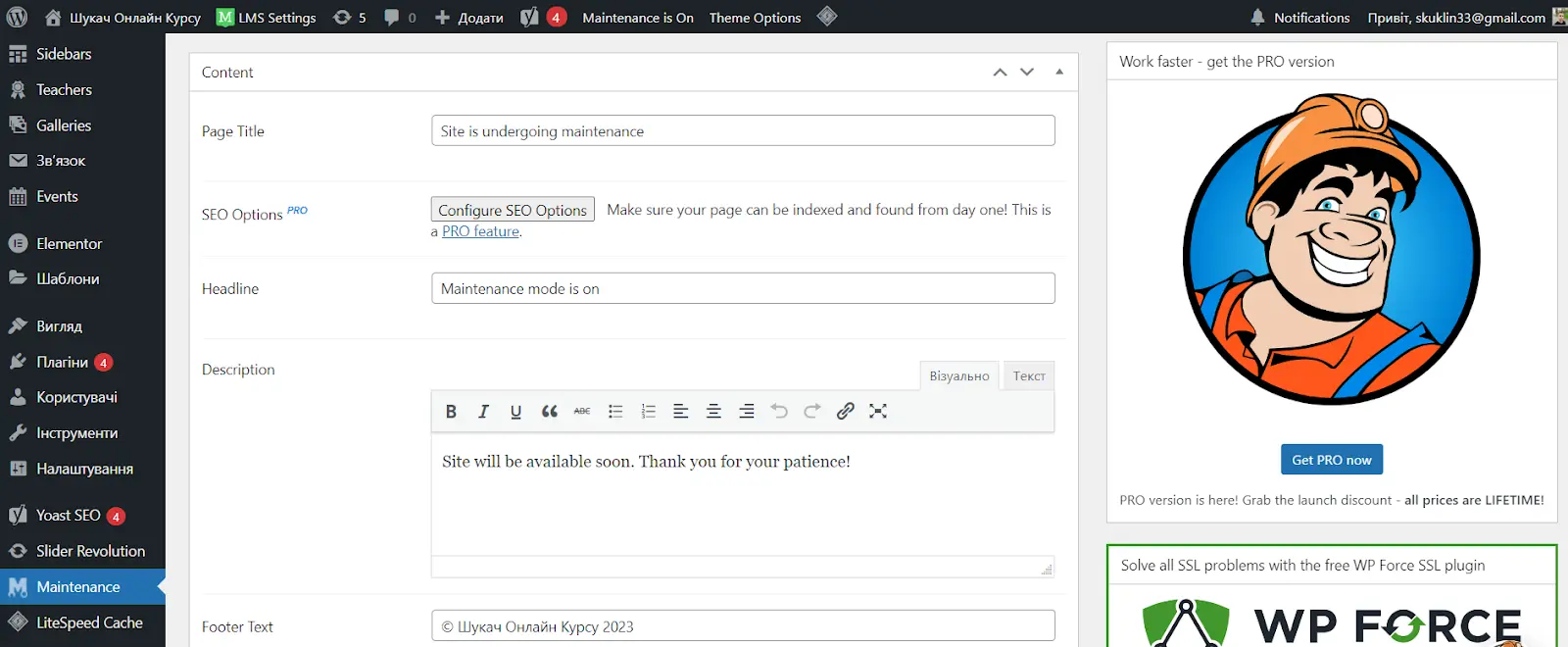

Jetzt ist das Dummy-Banner aktiv, es bleibt nur, es nach Ihren Wünschen einzurichten. Gehen Sie einfach zur Registerkarte Maintenance, ändern Sie den Seitennamen, den Titel, die Beschreibung, den Text im Footer, fügen Sie ein Logo und ein Hintergrundbild hinzu und sogar Ihren CSS-Code. Außerdem können Sie die Google Analytics-ID hinzufügen, um Informationen über die Besucher während der Entwicklung der Website zu erhalten.

Das Plugin hat eine PRO-Version, aber die kostenlose Version reicht für die grundlegende Einrichtung der Hauptseite aus.

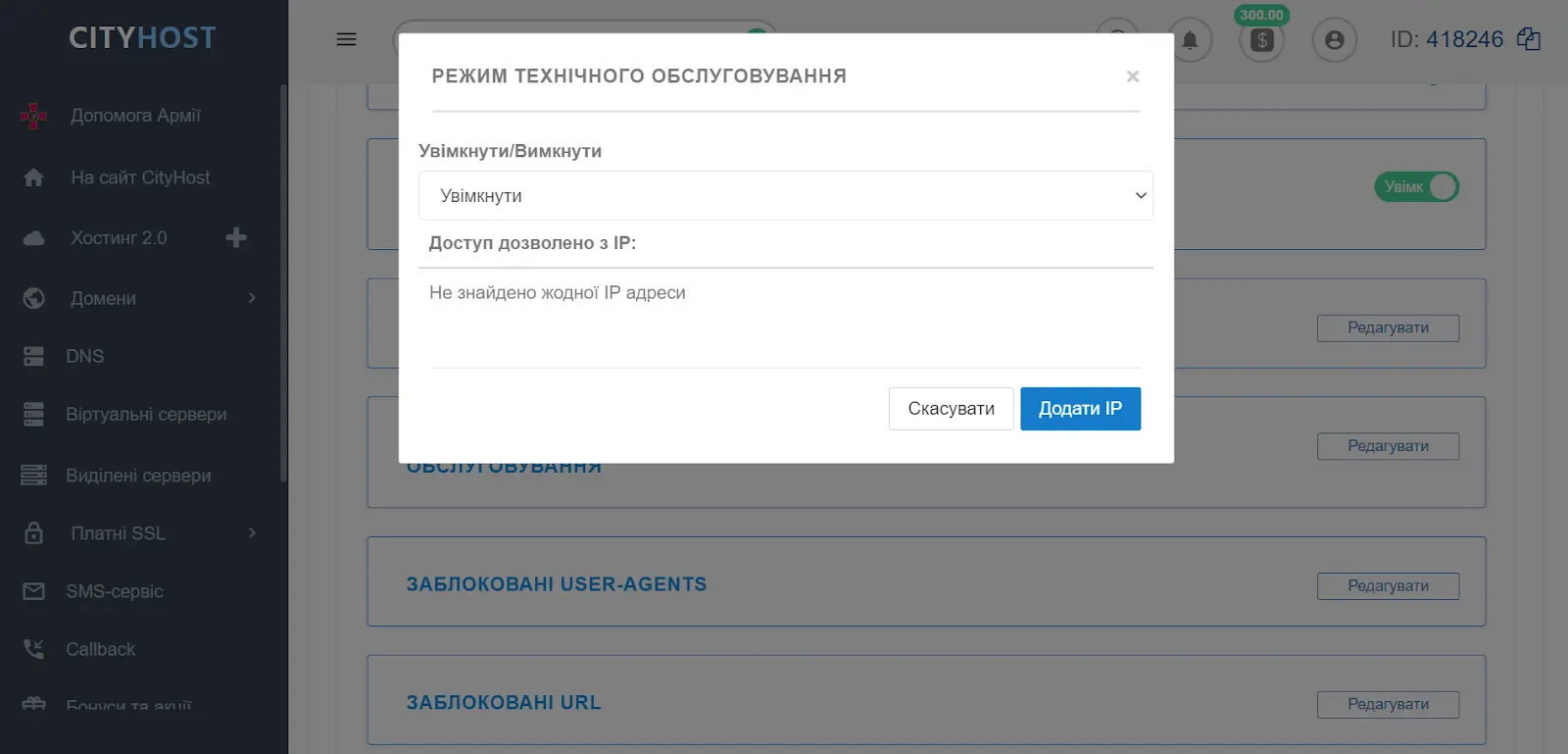

Wie man die Website während der Entwicklung mit Cityhost-Tools versteckt

Ohne falsche Bescheidenheit können wir sagen, dass Cityhost eine enorme Menge an Tools für die Arbeit mit Websites anbietet. Zum Beispiel gibt es in den Optionen des Dashboards die Möglichkeit, die Website sehr einfach von Crawlers zu schließen und ein Dummy-Banner auf der Website zu installieren.

Wie man die Website von Suchmaschinen sperrt

Mit Hilfe der Tools im Dashboard können Sie Suchbots einfach nach User-Agent sperren, ohne den Code der Website zu bearbeiten.

-

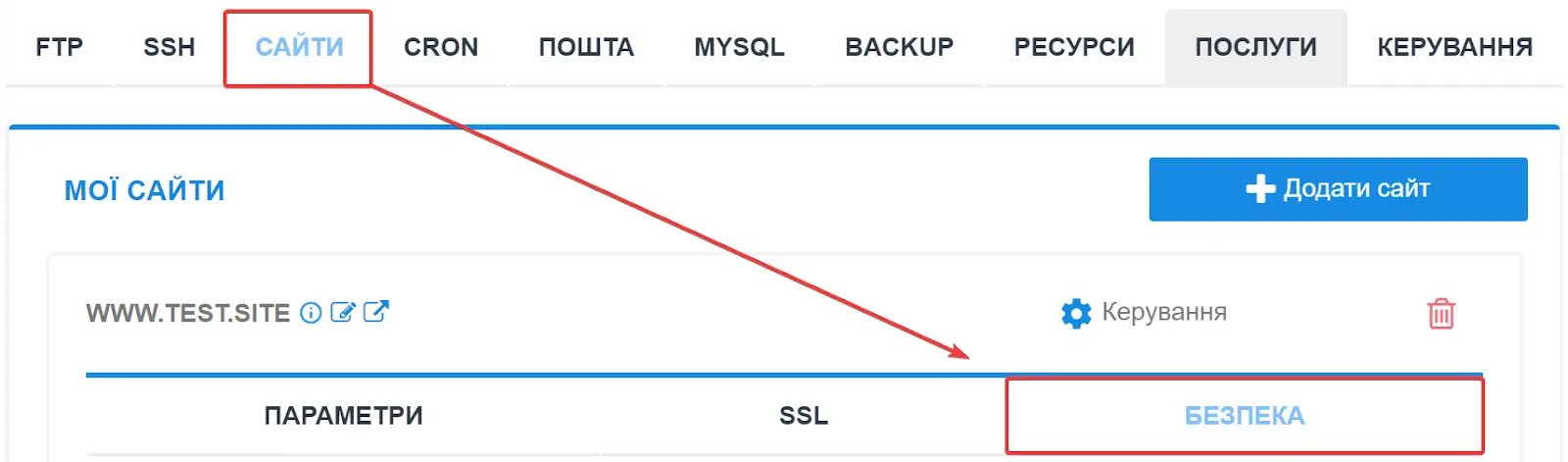

Öffnen Sie das Panel cp.cityhost.ua und gehen Sie zu den Hosting-Einstellungen.

-

Wählen Sie in den Einstellungen des gewünschten Projekts «Sicherheit».

-

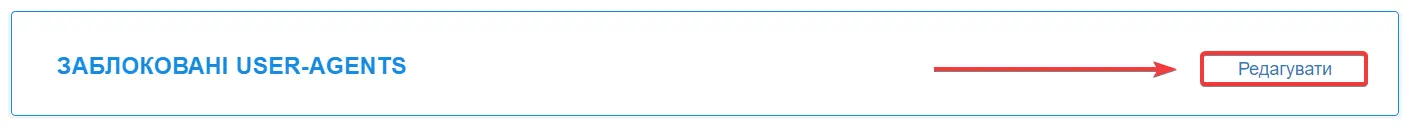

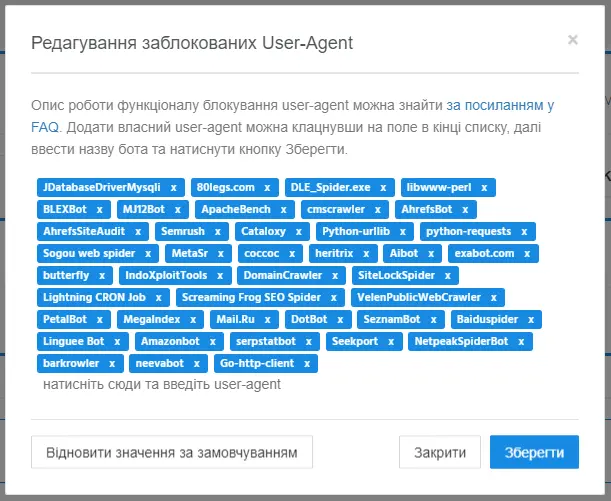

Klicken Sie auf «Bearbeiten» neben dem Punkt «Blockierte User-Agents».

-

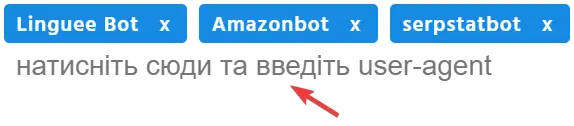

Geben Sie im neuen Fenster die Liste der Suchmaschinen-Roboter ein, z.B. GoogleBot, YandexBot, BingBot, SlurpBot (Yahoo-Suche).

Sie können auch jeden schädlichen Bot hinzufügen, dessen Ziel es ist, Statistiken für Dritte zu sammeln, Preise für Waren und Dienstleistungen zu scrapen, versteckte Seiten, Schwachstellen usw. zu entdecken. Einige schädliche Bots erzeugen auch eine übermäßige Belastung der Website, wodurch die Ladegeschwindigkeit der Seiten sinkt.

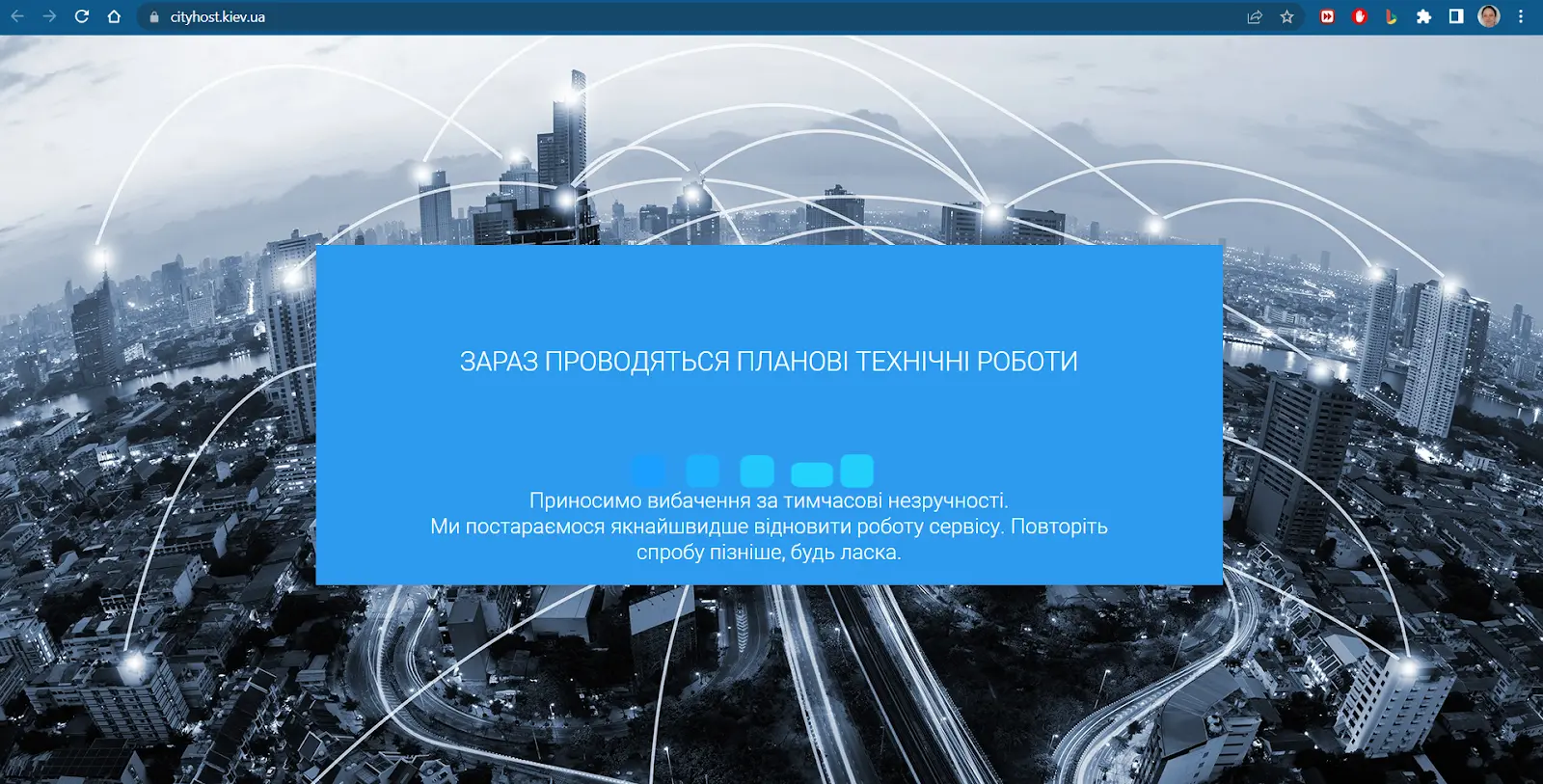

Wie man ein Dummy-Banner installiert

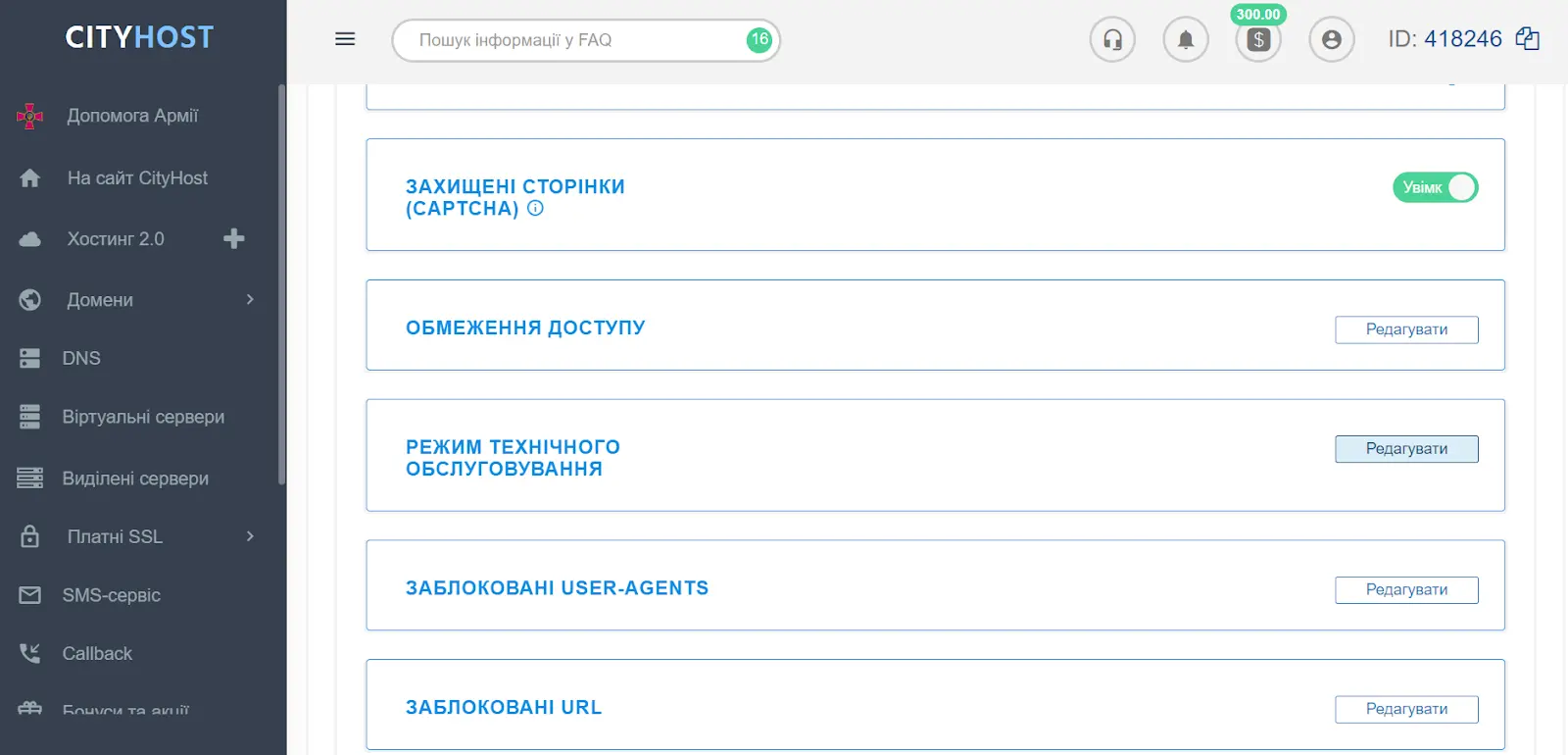

Auf Cityhost kann man die Website genauso leicht von Besuchern schließen, indem man ein Dummy-Banner installiert:

-

Melden Sie sich im Dashboard des Hosting an.

-

Klicken Sie auf die Schaltfläche «Bearbeiten» neben der Funktion «Wartungsmodus».

-

Wählen Sie in der Liste «Aktivieren».

Sie können sofort IP-Adressen von Personen hinzufügen, denen der Zugang zur Website gestattet ist. Dies ist eine unglaublich nützliche Funktion, wenn gleichzeitig mehrere Personen an dem Projekt arbeiten, z.B. der Kunde, Tester, Content-Manager.

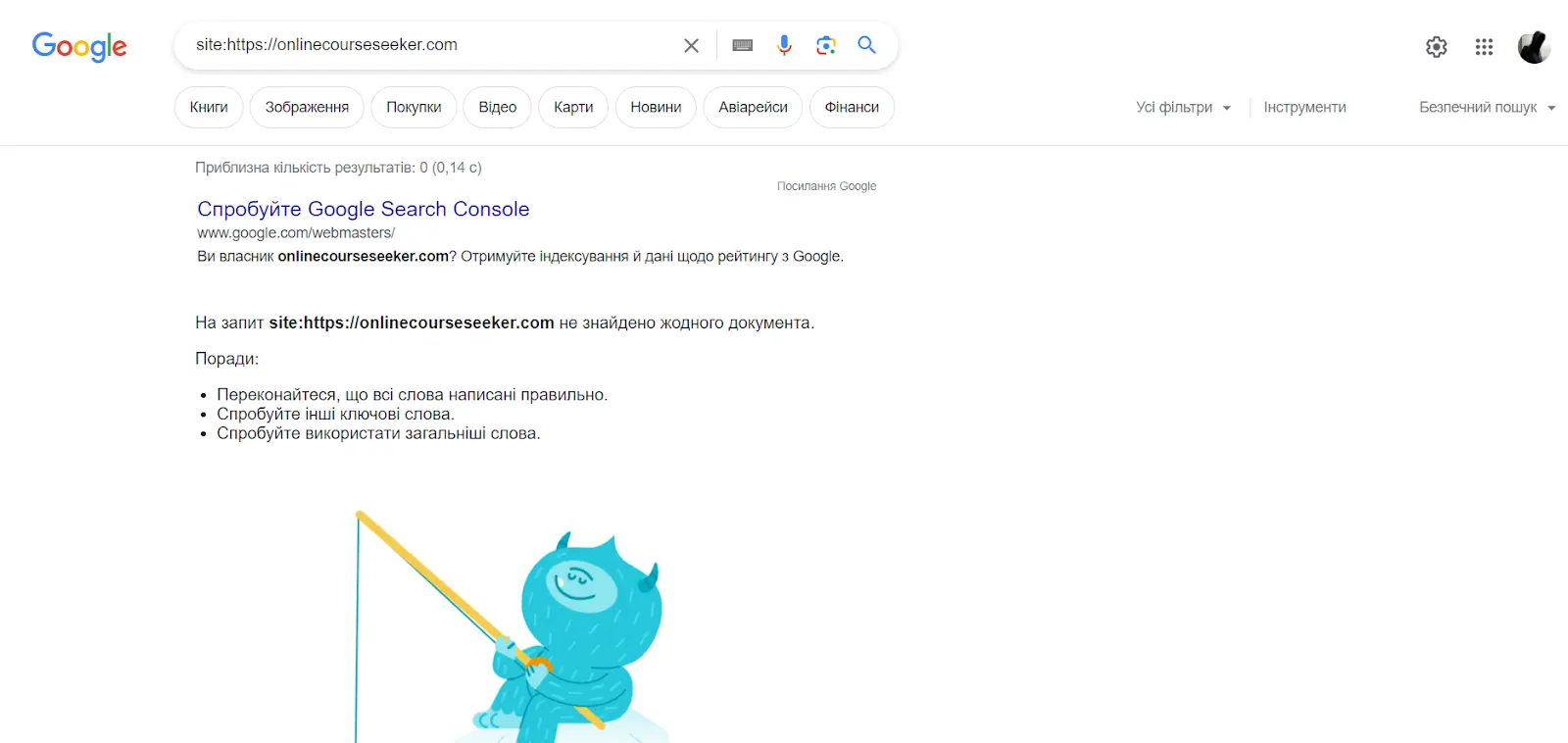

Wie man herausfindet, ob die Website während der Entwicklung verborgen wurde

In diesem Artikel haben wir effektive Methoden zur Schließung der Website während der Entwicklung sowohl von Besuchern als auch von Crawlers beschrieben. Mit einem Dummy-Banner gibt es nie Probleme, da er sofort über ein Plugin oder die Cityhost-Tools installiert werden kann. Um zu überprüfen, geben Sie einfach die Adresse der Website in die Suchzeile ein und sehen Sie sich das Ergebnis an (wir empfehlen, über einen neuen Tab im Inkognito-Modus zu gehen).

Der gesamte Prozess der Schließung von Daten vor Suchrobotern ist ebenfalls einfach, aber das endgültige Ergebnis hängt von den Crawlers ab. In einigen Fällen können sie einfach die Verbote ignorieren und entscheiden, die Website zu indizieren. Deshalb ist es notwendig, regelmäßig zu überprüfen, ob es gelungen ist, die Website von der Indizierung auszuschließen, und dies kann mithilfe von:

-

Suchoperator — geben Sie in die Adresszeile site:https:// + URL Ihrer Ressource ein und sehen Sie, welche Seiten in den Ergebnissen vorhanden sind;

-

Suchkonsole — das Verfahren hängt vom jeweiligen System ab. Beispielsweise erfolgt die Überprüfung der Website in den Google-Ergebnissen über die Google Search Console. Sie melden sich einfach im Dienst an, wählen «URL überprüfen» und fügen die Adresse der Website ein;

-

Browsererweiterung — verwenden Sie eine beliebige Anwendung zur schnellen Analyse der Website. Installieren und aktivieren Sie beispielsweise RDS Bar, gehen Sie dann zum Projekt und sehen Sie sich die Informationen dazu an.

Das ideale Ergebnis: In den Ergebnissen gibt es keine Seite Ihrer Website! Aber dieses Ergebnis ist natürlich ideal, wenn es um die Entwicklung des Projekts geht. Sobald es fertig ist, erlauben Sie den Suchrobotern wieder, die Seiten zu analysieren und in den Ergebnissen anzuzeigen. Wenn Sie Hilfe beim Schließen der Website oder bei anderen Einstellungen in unserem Dashboard benötigen, wenden Sie sich an den Kundenservice von Cityhost, und unsere Spezialisten werden Ihnen eine professionelle Beratung anbieten.

Lesen Sie auch: Technischer Support Cityhost.ua - wie das funktioniert