- Wie A/B-Tests funktionieren: sechs Schritte von der Hypothese bis zur Schlussfolgerung

- Wie der Verkehr aufgeteilt wird: Methoden und Werkzeuge

- Wie Split-Tests in sozialen Medien durchgeführt werden

- Häufige Fehler bei A/B-Tests

- Wann A/B-Tests keinen Sinn machen

In digitalen Produkten können selbst kleine Details das Verhalten der Benutzer beeinflussen — von der Formulierung des Buttons bis zum Foto auf dem ersten Bildschirm. Das Problem ist, dass es im Voraus selten klar ist, wie genau eine bestimmte Änderung wirken wird. Selbst wenn eine Entscheidung offensichtlich erscheint, können die Menschen ganz anders reagieren, als erwartet. Daher ist es an einem bestimmten Punkt logischer, einfach zu beobachten, was die Benutzer tatsächlich tun, anstatt Vorhersagen zu treffen.

Genau aus diesem Ansatz heraus ist das A/B-Testing entstanden — als Methode, um Ideen unter realen Bedingungen zu testen, anstatt sie theoretisch zu diskutieren.

In der Regel ist eine Variante die aktuelle Version, während die andere sich nur in einem Detail unterscheidet. Wenn dieses Detail von Bedeutung ist, zeigt sich der Unterschied in den Ergebnissen.

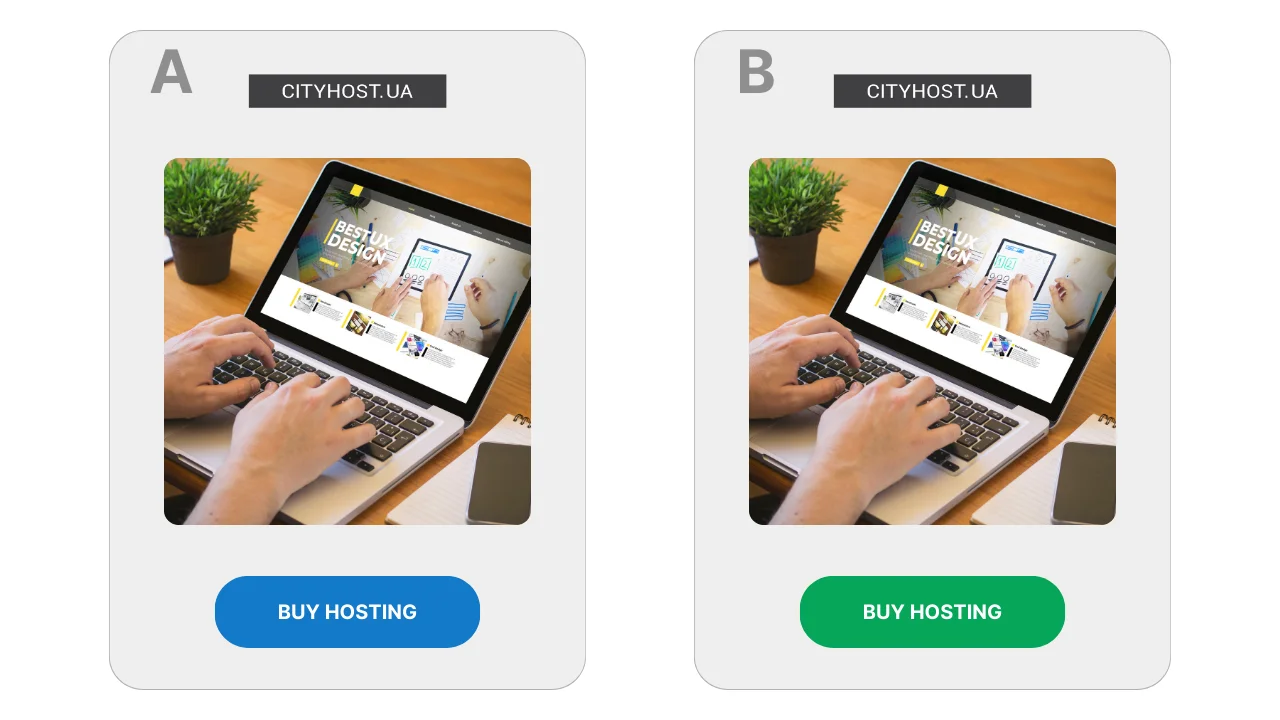

Zum Beispiel wird auf der Seite für den Verkauf von Webhosting der Button in zwei Varianten gestaltet: blau und grün. Wenn eine von ihnen zu mehr Klicks führt — bleibt genau diese. Hier geht es nicht um das «richtige» Design, sondern nur um die Reaktion des Publikums.

Das Prinzip des Vergleichs von zwei Varianten wurde lange vor dem Internet entwickelt. Es wurde in wissenschaftlichen Studien, in der Medizin, in der Industrie — überall dort eingesetzt, wo eine objektive Antwort erforderlich war und nicht auf Intuition vertraut werden konnte. Im digitalen Umfeld wurde A/B-Testing in den 2000er Jahren populär, als es möglich wurde, schnell Daten über das Verhalten der Benutzer zu sammeln.

Lesen Sie auch: Was ist Website-Traffic, wie man ihn herausfindet und warum man ihn kontrollieren sollte

Wie A/B-Tests funktionieren: sechs Schritte von der Hypothese bis zur Schlussfolgerung

Split-Testing sieht selten wie ein komplexes Experiment mit Formeln und Grafiken aus. In der Regel handelt es sich um eine Abfolge einfacher Schritte, die von Test zu Test wiederholt werden, unabhängig davon, was genau getestet wird — eine Seite, ein Werbematerial oder ein einzelnes Element der Benutzeroberfläche.

- Ein Zweifel oder eine Idee taucht auf. Das Testen beginnt normalerweise mit dem Gefühl, dass die Seite oder das Werbematerial besser funktionieren könnte. Formal sieht alles in Ordnung aus: Die Leute kommen, lesen, klicken manchmal weiter. Aber es bleibt die Frage — würden die Benutzer anders reagieren, wenn die Präsentation leicht geändert würde?

- Eine Hypothese wird formuliert. In diesem Stadium entsteht eine konkrete Annahme darüber, was das Verhalten der Benutzer beeinflussen könnte. Zum Beispiel, dass eine abstrakte Illustration auf dem ersten Bildschirm schön aussieht, aber kein Gefühl der Einbindung erzeugt — warum nicht durch ein Foto einer realen Person ersetzen? Oder dass der Block mit Antworten auf häufige Fragen früher angezeigt werden sollte, um einige Zweifel bereits vor der Entscheidungsfindung auszuräumen.

- Zwei Varianten werden vorbereitet. Eine Variante bleibt unverändert und dient als Ausgangspunkt. Die andere unterscheidet sich nur in einem Detail, das im Test überprüft wird. Wenn mehrere Elemente gleichzeitig geändert werden, wird es schwierig, das Ergebnis zu erklären, selbst wenn es positiv erscheint.

- Der Test wird gestartet und beobachtet. Dabei merkt sich das System, welche Variante einem bestimmten Benutzer angezeigt wurde, und zeigt bei wiederholten Besuchen dieselbe an. Dies ist wichtig für die Sauberkeit des Experiments — die Person sollte nicht zwischen den Versionen «springen».

- Ein Indikator wird ausgewählt und dem Test wird Zeit gegeben. Im Voraus wird festgelegt, worauf genau geachtet wird: ob die Benutzer weiterklicken, ob sie mit dem Inhalt interagieren oder ob sie den gewünschten Schritt erreichen. Die ersten Ergebnisse sind normalerweise nicht aussagekräftig, daher wird dem Test genügend Zeit gegeben.

- Eine Schlussfolgerung wird gezogen. Wenn mehr Daten verfügbar sind, wird klar, ob es einen spürbaren Unterschied zwischen den Varianten gab. Manchmal ist er offensichtlich, manchmal so gering, dass es keinen Sinn macht, etwas zu ändern. Es kann auch vorkommen, dass der Test keine klare Antwort gibt, und das ist auch ein Ergebnis: es bedeutet, dass die spezifische Änderung das Verhalten der Benutzer nicht beeinflusst hat.

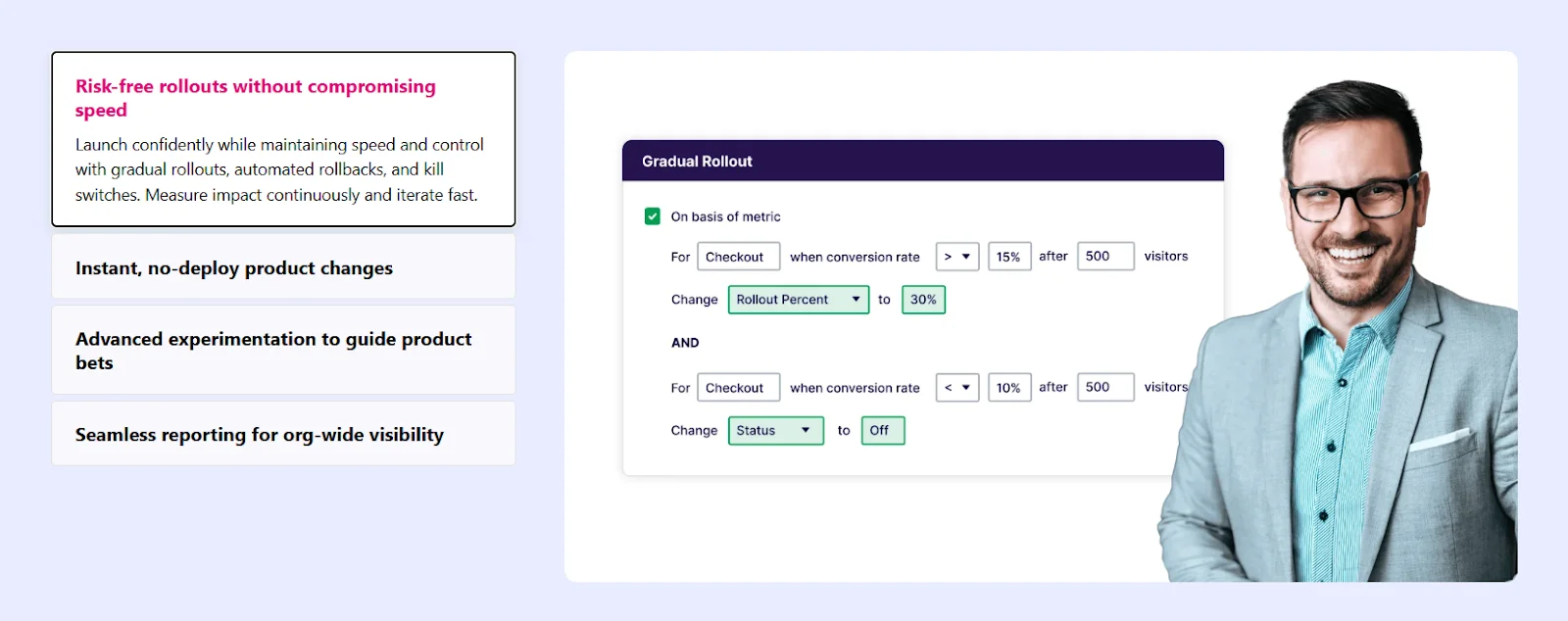

Dieser Ansatz ermöglicht es, Änderungen zu testen, ohne das funktionierende Modell zu gefährden: Während der Test läuft, sieht ein Teil der Benutzer weiterhin die gewohnte Version. Dies ist besonders wichtig, wenn es um Seiten geht, die bereits Anfragen oder Verkäufe generieren.

Lesen Sie auch: Wie man eine Website auf die Anbindung eines Zahlungssystems vorbereitet

Wie der Verkehr aufgeteilt wird: Methoden und Werkzeuge

- Das Hauptprinzip der Verkehrsverteilung

- Warum man den Verkehr nicht auf zwei verschiedene Seiten aufteilen sollte

- Werkzeuge zur Verkehrsaufteilung

In jedem A/B-Test ist nicht die Idee der Änderung entscheidend, sondern wie die Benutzer auf die verschiedenen Varianten gelangen. Wenn dieser Schritt nicht richtig organisiert ist, verlieren die Testergebnisse ihren Sinn, selbst wenn die Zahlen überzeugend aussehen.

Der Verkehr wird fast nie manuell aufgeteilt. Der Grund ist einfach: Menschen können mehrmals auf die Website zurückkehren, von verschiedenen Geräten aus zugreifen oder von verschiedenen Quellen auf die Seite gelangen. Ohne spezielle Werkzeuge ist es unmöglich zu garantieren, dass dieselbe Person nicht beide Varianten sieht.

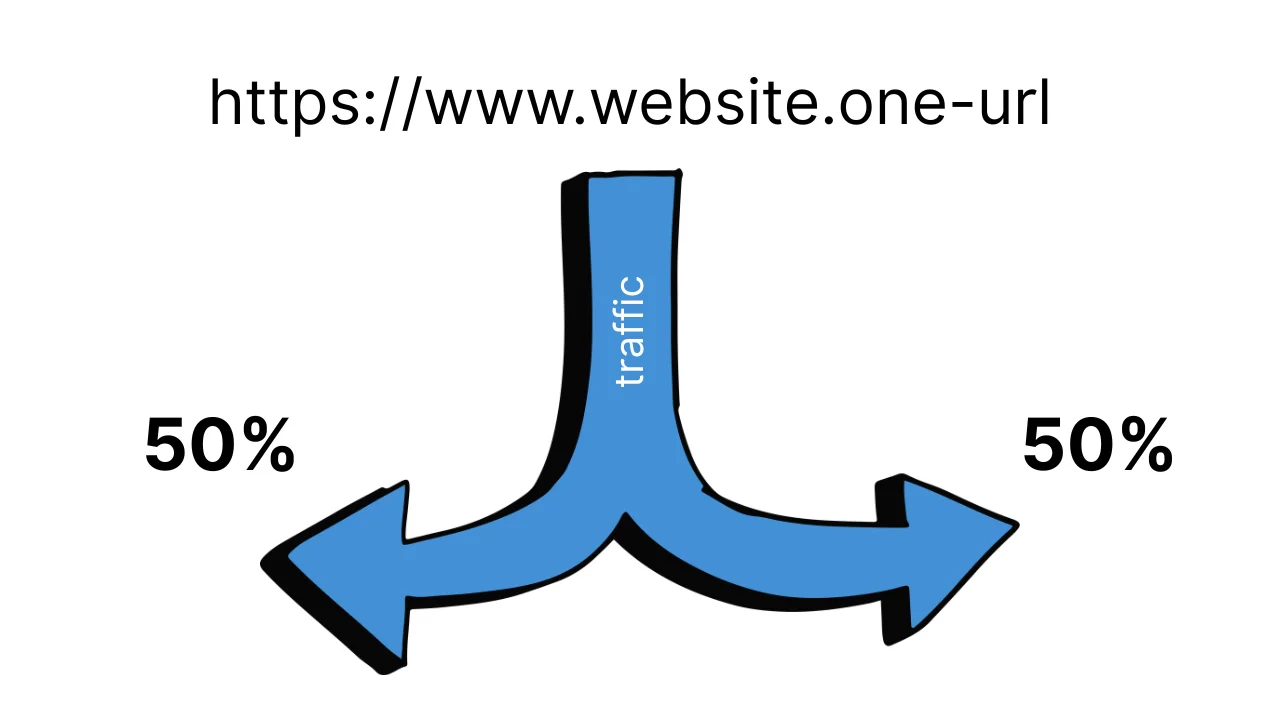

Das Hauptprinzip der Verkehrsverteilung

Beim klassischen A/B-Testing wird eine URL-Adresse verwendet, und das Testsystem entscheidet intern, welche Variante einem bestimmten Benutzer angezeigt wird. Dies geschieht normalerweise zufällig, zum Beispiel im Verhältnis 50/50.

Wichtiger Punkt: Nach der ersten Anzeige wird die Auswahl fixiert. Wenn der Benutzer zur Seite zurückkehrt, sieht er dieselbe Variante wie zuvor. Dies hilft, Verwirrung zu vermeiden und das Verhalten der Menschen nicht durch künstliche «Umschaltungen» zu beeinflussen.

Warum man den Verkehr nicht auf zwei verschiedene Seiten aufteilen sollte

Ein häufiger Fehler ist es, zwei Seiten zu erstellen und einfach den Verkehr von verschiedenen Werbeanzeigen darauf zu lenken. Formal sieht das wie ein Test aus, aber bei der Umsetzung treten mehrere Probleme auf:

- Ein Benutzer kann beide Versionen sehen;

- Die Zielgruppen in der Werbung können sich überschneiden;

- Die Ergebnisse hängen stark von der Quelle des Verkehrs ab und nicht von der Änderung selbst.

In diesem Format ist es schwierig zu verstehen, was genau das Ergebnis beeinflusst hat — die Seite, die Werbung oder der Zufall.

Lesen Sie auch: Traffic + CPA-Marketing: wie man mit Partnerangeboten Geld verdient

Werkzeuge zur Verkehrsaufteilung

Um diese Probleme zu vermeiden, werden spezielle Dienste für A/B-Tests verwendet. Sie übernehmen die Verkehrsverteilung, die Fixierung der Varianten und die Datensammlung.

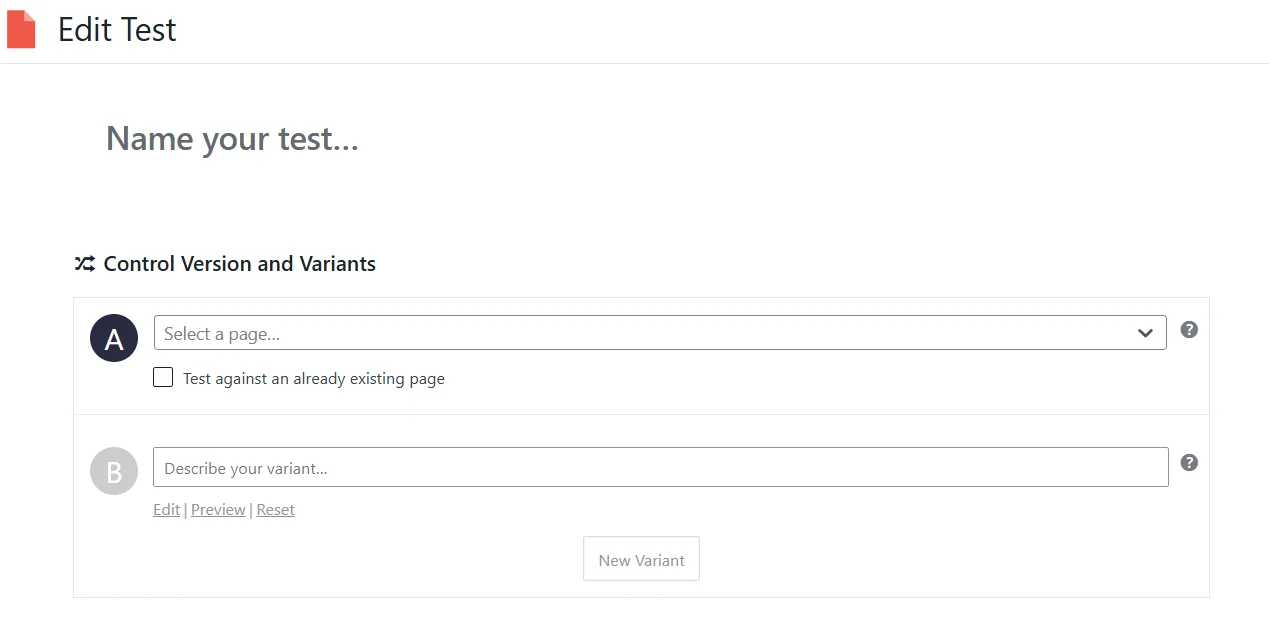

Für Websites auf WordPress wird häufig Nelio A/B Testing gewählt. Dies ist ein Plugin, das es ermöglicht, Seiten, Überschriften und einzelne Elemente ohne Programmierkenntnisse zu testen. Die Varianten werden direkt im Adminbereich erstellt, und der Verkehr wird automatisch aufgeteilt.

Für Landingpages und Marketingseiten ohne komplexe Logik eignet sich Split Hero. Der Dienst funktioniert nach dem Prinzip des Seitenwechsels und überwacht selbst, dass die Benutzer eine stabile Variante sehen.

Eine universellere Lösung ist VWO. Es ermöglicht das Testen sowohl ganzer Seiten als auch einzelner Elemente über einen visuellen Editor. Solche Dienste werden häufig in Marketingteams verwendet, wo es wichtig ist, Tests schnell ohne Entwickler zu starten.

Für große Projekte und komplexe Produkte gibt es Lösungen wie Optimizely, bei denen die Verkehrsverteilung auf Serverebene erfolgen kann. Dies liefert sauberere Ergebnisse, erfordert jedoch technische Ressourcen und Erfahrung.

Wie Split-Tests in sozialen Medien durchgeführt werden

- Wie das Split-Testing von Werbung auf Facebook funktioniert

- Wie man das Split-Testing von Werbung in TikTok startet

- Wie man A/B-Tests auf YouTube durchführt

In sozialen Medien hat das Split-Testing eine grundlegende Einschränkung: Für organische Beiträge gibt es in Facebook, Instagram, TikTok und YouTube keine A/B-Testwerkzeuge. Soziale Netzwerke bieten keine Möglichkeit, die Zielgruppe kontrolliert zwischen zwei Versionen eines Beitrags aufzuteilen, die Anzeige für einen bestimmten Benutzer zu fixieren oder eine gleichmäßige Verteilung der Aufrufe zu gewährleisten. Daher ist es technisch unmöglich, organische Inhalte korrekt zu testen.

Die Idee, einfach zwei ähnliche Beiträge mit unterschiedlicher Präsentation zu veröffentlichen, erscheint logisch, liefert jedoch in Wirklichkeit kein zuverlässiges Ergebnis. Dieselben Benutzer können beide Beiträge sehen, und zwar zu unterschiedlichen Zeiten und in unterschiedlichen Kontexten. Die Algorithmen der sozialen Netzwerke greifen zusätzlich in die Anzeigen ein: Wenn ein Beitrag schneller Reaktionen erhält, wird er aktiver angezeigt, während der andere fast aus dem Feed verschwindet. Auch die Veröffentlichungszeit, der Wochentag, der allgemeine Informationshorizont und die aktuelle Aktivität des Publikums beeinflussen das Ergebnis. Letztendlich wird nicht die Effektivität der beiden Varianten verglichen, sondern eine Kombination aus externen Faktoren und algorithmischen Entscheidungen.

Gleichzeitig führen einzelne Plattformen schrittweise integrierte automatische Experimente für spezifische Inhaltsformate ein. Zum Beispiel bietet Meta A/B-Testing für Reels an. In diesem Fall erlaubt die Plattform, mehrere Varianten des Covers oder der Beschreibung für ein Video zu erstellen. Das System teilt dann die Zielgruppe in Untergruppen auf, bewertet die Reaktion über einen kurzen Zeitraum (normalerweise anhand der Anzahl der Aufrufe) und wählt automatisch die Variante aus, die das beste Ergebnis erzielt hat.

Es ist wichtig zu verstehen, dass dieser Mechanismus kein klassisches A/B-Testing ist. Der Benutzer kontrolliert weder die Verteilung der Zielgruppe, noch die Dauer des Tests, noch die Metriken — alle Entscheidungen trifft der Algorithmus der Plattform. Im Grunde genommen handelt es sich um eine schnelle algorithmische Auswahl der Variante für die weitere Verbreitung und nicht um ein vollständiges Experiment mit detaillierter Analyse.

Vollwertige Split-Tests in sozialen Medien sind nur in der Werbung möglich. Die Werbeplattformen von Meta und TikTok verfügen über spezielle Experimentiermodi, in denen die Plattform selbst die Zielgruppe zwischen den Varianten aufteilt. In diesem Format sieht jeder Benutzer nur eine Version der Anzeige, und die Ergebnisse werden parallel und ohne Überschneidungen der Anzeigen gesammelt.

Im Werbe-Split-Test wird normalerweise ein Parameter geändert: Kreativ, Text, Überschrift, Call-to-Action oder Zielgruppe. Die übrigen Bedingungen bleiben gleich, was es ermöglicht, das Ergebnis genau mit der spezifischen Änderung zu verknüpfen.

Wie das Split-Testing von Werbung auf Facebook funktioniert

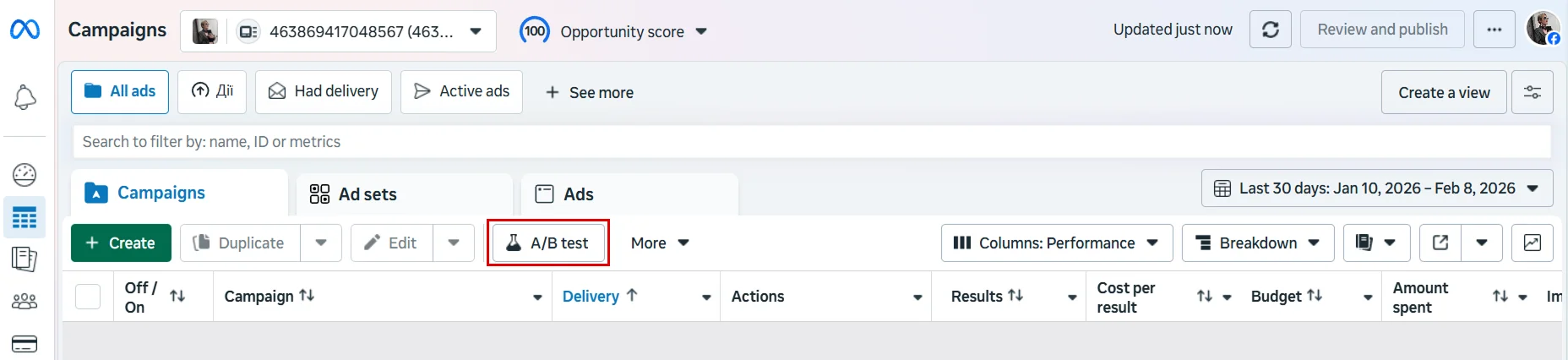

Es ist wichtig zu wissen, dass das Split-Testing von Werbung in TikTok und Facebook nur in der Browser-Version des Werbeanzeigenmanagers verfügbar ist. Mobile Apps unterstützen die Erstellung von A/B-Tests nicht, daher ist es nicht möglich, sie von einem Telefon aus zu starten.

Im Werbeanzeigenmanager von Facebook wird diese Funktion über die Schaltfläche «A/B-Test» in der oberen Leiste des Ads Managers gestartet. Das Testen wird immer auf der Grundlage eines vorhandenen Werbeobjekts erstellt — einer Kampagne, einer Anzeigengruppe oder eines bestimmten Werbeposts.

Nach dem Klicken auf die Schaltfläche bietet Facebook an, wie der Test eingerichtet werden soll. Es gibt zwei Optionen: entweder eine Anzeige zu nehmen und eine Kopie davon zum Vergleich zu erstellen oder zwei bereits erstellte Anzeigen auszuwählen. In jedem Fall fordert das System dazu auf, die Kampagne, die Anzeigengruppe oder den bestimmten Werbepost anzugeben, der die Grundlage für den Test bildet.

Die Logik des Tests ist dann standardmäßig: Das System erstellt zwei Versionen der Anzeige, teilt die Zielgruppe zwischen ihnen auf und zeigt jede Variante einer separaten Benutzergruppe. Nach Abschluss des Tests vergleicht Facebook die Ergebnisse und zeigt, welche Variante besser abgeschnitten hat.

Wie man das Split-Testing von Werbung in TikTok startet

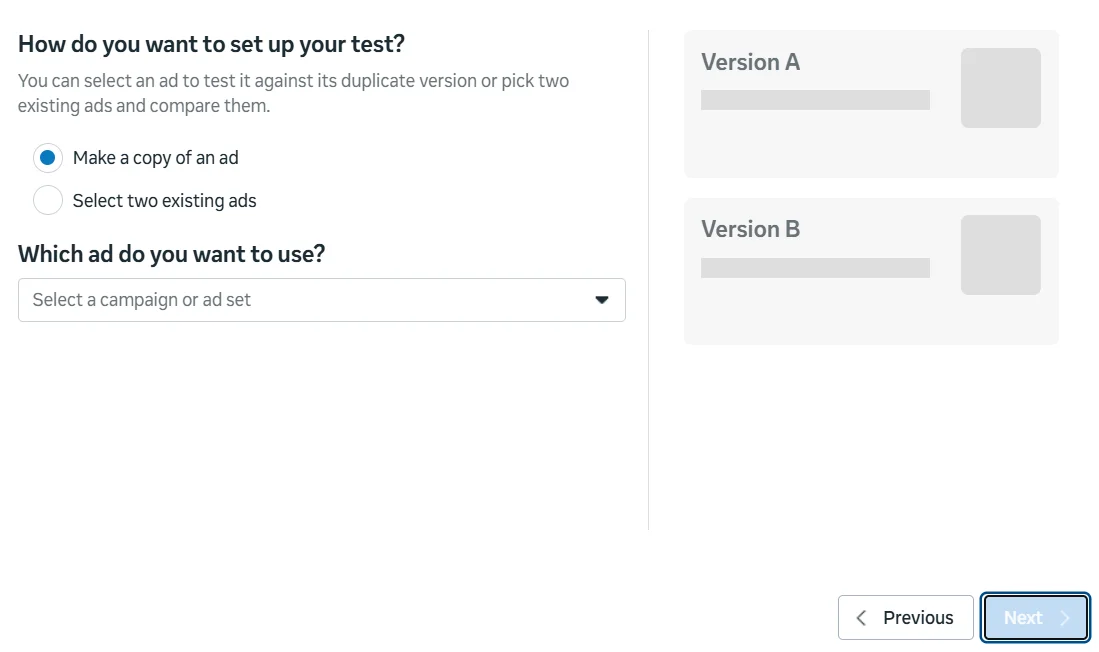

Um A/B-Tests in TikTok zu starten, muss man mit der Browser-Version des Werbeanzeigenmanagers arbeiten. In der TikTok-App oder im TikTok Studio gibt es diese Funktion nicht, daher ist der erste Schritt, die Website ads.tiktok.com zu besuchen und sich in sein Werbekonto einzuloggen. Wenn man noch kein Konto hat, führt das System durch die Standardregistrierung mit der Auswahl des Landes, des Geschäftstyps und der Zahlungseinstellungen.

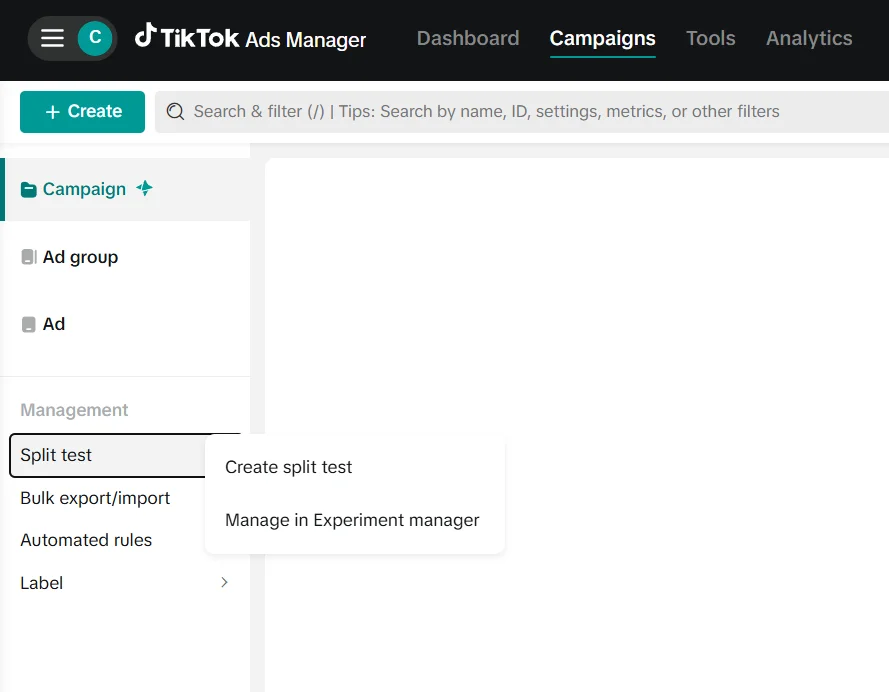

Nach dem Einloggen öffnet sich der TikTok Ads Manager. Im oberen Menü muss man zum Abschnitt Kampagnen wechseln. Hier befinden sich alle Kampagnen, Anzeigengruppen und Werbeverwaltungswerkzeuge. In der linken Spalte, unter der Hauptstruktur der Kampagnen, befindet sich der Block Management. Dort ist der Punkt Split-Test zu finden — das ist der Einstiegspunkt für das Split-Testing.

Nachdem man auf Split-Test geklickt hat, muss man Create Split Test auswählen.

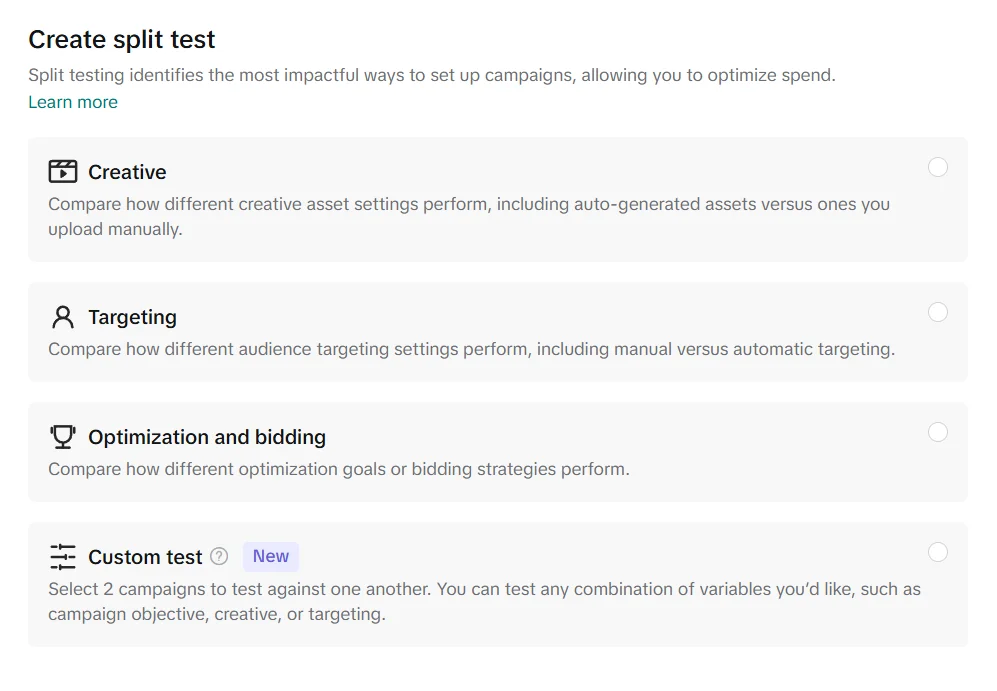

Im nächsten Schritt muss man auswählen, was genau getestet werden soll. TikTok bietet mehrere Optionen: das Testen von Kreativen, von Zielgruppeneinstellungen oder von Optimierungs- und Gebotsstrategien. Es gibt auch den Modus Custom Test, der es ermöglicht, zwei Kampagnen mit beliebigen Kombinationen von Änderungen zu vergleichen.

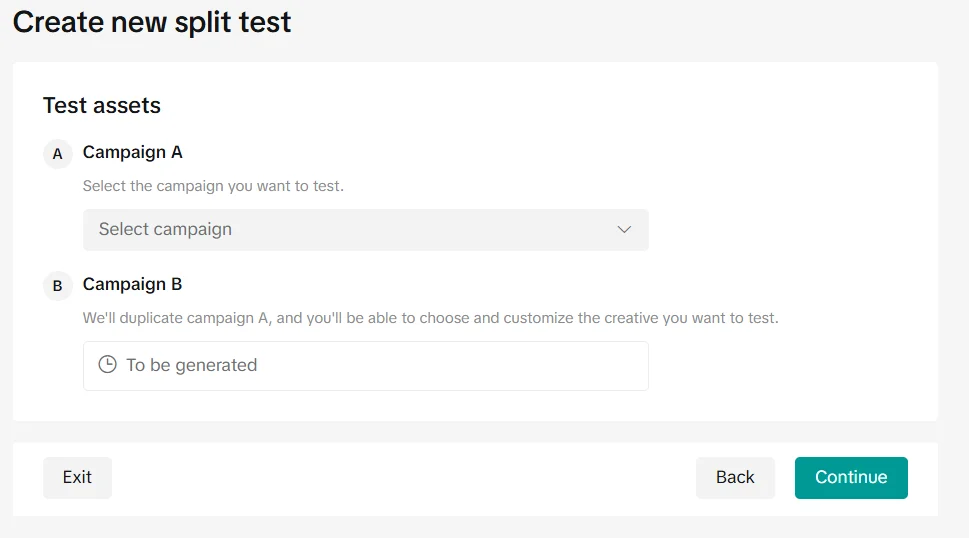

Im nächsten Schritt muss man das Werbeobjekt für den Vergleich auswählen. Das System bietet an, Campaign A — eine bestehende Kampagne, die als Basisversion verwendet wird, festzulegen. Campaign B wird automatisch durch Kopieren der ersten Kampagne erstellt, wonach nur der Parameter geändert werden kann, der für das Testen ausgewählt wurde. Auf diese Weise haben beide Kampagnen dieselben Einstellungen, und der Unterschied zwischen ihnen beschränkt sich auf eine kontrollierte Änderung.

Nach Bestätigung der Einstellungen und dem Klicken auf Continue wird der Split-Test gestartet. Nach Abschluss des Tests zeigt das System, welche Variante anhand der gewählten Metrik effektiver war.

Lesen Sie auch: Wie man eine Website mit sozialen Medien bewirbt

Wie man A/B-Tests auf YouTube durchführt

Split-Testing von Videoanzeigen auf YouTube wird nicht in YouTube Studio, sondern über den Google Ads-Werbeanzeigenmanager durchgeführt.

Der erste Schritt besteht darin, die Website ads.google.com zu besuchen und sich in sein Google Ads-Konto einzuloggen. Nach dem Einloggen muss man zum Kampagnenbereich wechseln und sicherstellen, dass bereits eine Video-Kampagne für YouTube erstellt wurde oder zumindest ein Kreativ vorbereitet ist, mit dem man arbeiten möchte.

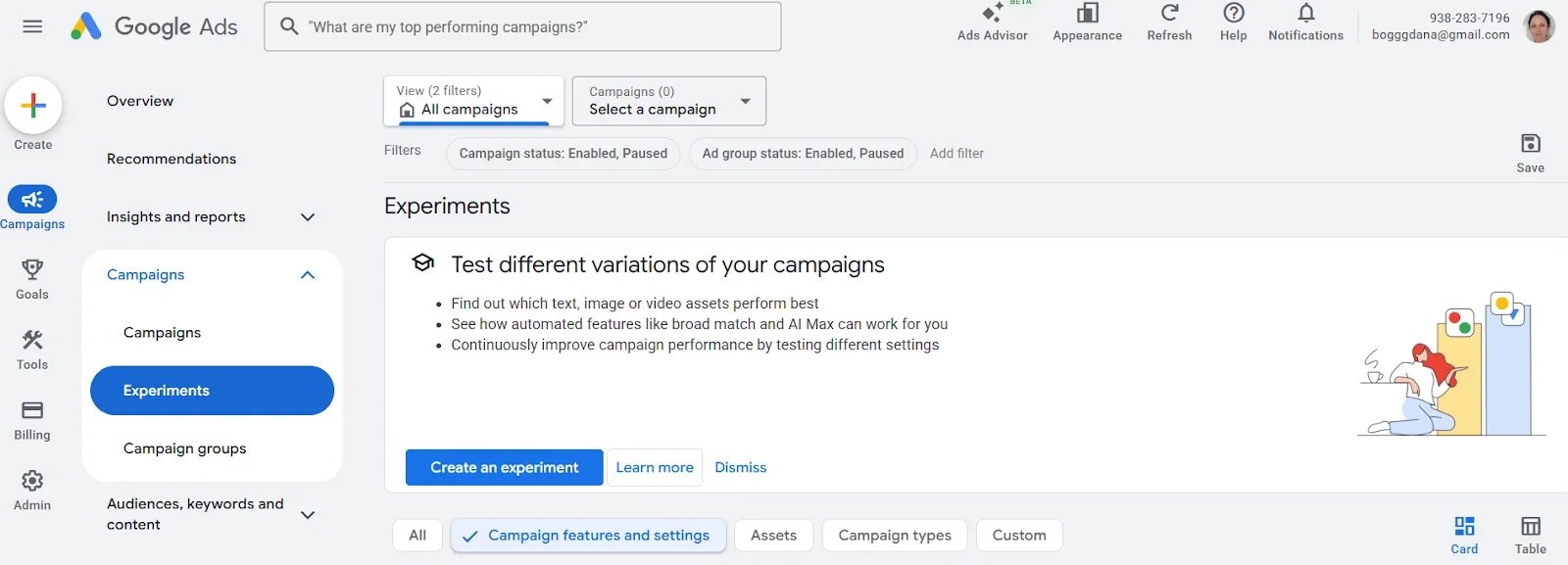

Nach dem Wechsel zu Campaigns → Experiments öffnet sich die Seite zur Erstellung von Experimenten. Hier bietet Google Ads an, verschiedene Varianten von Kampagnen zu testen — Kreative, Einstellungen oder einzelne Anzeigeparameter. Um einen Split-Test zu starten, muss man die Schaltfläche Create an Experiment klicken.

Das System fordert dann auf, eine Basis-Kampagne auszuwählen, die bereits im Konto existiert. Auf deren Grundlage erstellt Google Ads eine Testversion, in der ein oder mehrere Parameter je nach Art des Experiments geändert werden können. Danach wird die Verkehrsverteilung zwischen der Originalkampagne und der Testversion sowie die Dauer des Experiments festgelegt.

Die Ergebnisse des Experiments werden im selben Abschnitt Experiments angezeigt und ermöglichen es, zu sehen, welche Version der Anzeige die besten Ergebnisse bei den gewählten Metriken erzielt hat.

Häufige Fehler bei A/B-Tests

Selbst ein richtig eingerichtetes A/B-Testing kann falsche Schlussfolgerungen liefern, wenn man in der Planungs- oder Analysephase Fehler macht. Die häufigsten Probleme entstehen nicht durch die Werkzeuge, sondern durch Eile und falsche Dateninterpretation.

- Gleichzeitiges Testen mehrerer Änderungen. Wenn in einem Test mehrere Elemente gleichzeitig geändert werden, ist unklar, was genau das Ergebnis beeinflusst hat. Selbst ein positives Ergebnis ist in einem solchen Fall schwer praktisch zu nutzen.

- Zu kurzes Testen und eine geringe Datenmenge. Die ersten Ergebnisse sehen oft überzeugend aus, sind aber normalerweise nur zufällige Schwankungen. Wenn der Test zu früh gestoppt wird oder Daten aus einer kleinen Stichprobe analysiert werden, können die Schlussfolgerungen falsch sein.

- Änderung der Bedingungen während des Tests. Anpassungen des Budgets, der Zielgruppenansprache oder anderer Einstellungen während des Tests stören die Gleichheit der Bedingungen. In einer solchen Situation ist der Vergleich der Varianten nicht mehr korrekt.

- Erwartung eines großen Effekts von geringfügigen Änderungen. Nicht jede Anpassung hat einen spürbaren Einfluss auf das Verhalten der Benutzer. Das Fehlen eines Unterschieds zwischen den Varianten ist ein normales Ergebnis und kein Zeichen des Scheiterns.

- Überzeugung, dass der Test immer eine klare Antwort geben muss. Manchmal bestätigt A/B-Testing nur, dass beide Varianten gleich gut funktionieren. Dies ist ein Signal, nicht «nach einem Gewinner zu suchen», sondern neue Hypothesen zu formulieren.

Wann A/B-Tests keinen Sinn machen

A/B-Testing wird oft als universelles Werkzeug für Entscheidungsfindungen angesehen. Aber es gibt Situationen, in denen es entweder keine nützlichen Informationen liefert oder eine Illusion der Kontrolle schafft, ohne ein echtes Verständnis des Problems zu fördern. Dies geschieht am häufigsten in folgenden Fällen.

- Wenn der Verkehr zu gering ist. Wenn nur wenige Benutzer auf die Seite oder die Werbekampagne kommen, werden die Testergebnisse instabil und zufällig sein.

Wenn auf die Landingpage täglich 20-30 Personen kommen und zwei Varianten eines Buttons getestet werden, wird eine Variante nach einer Woche vier Klicks haben, die andere — sechs. Formal gibt es einen Unterschied, aber dieser lässt sich leicht durch Zufall erklären und nicht durch einen tatsächlichen Vorteil.

- Wenn das Produkt oder das Angebot für die Zielgruppe unverständlich ist. Wenn die Menschen nicht verstehen, was ihnen angeboten wird und warum sie es brauchen, wird eine Änderung der Überschrift, des Buttons oder des Bildes keinen Einfluss auf die Entscheidung haben.

Zum Beispiel verkauft ein Dienst Domainnamen, verwendet aber auf dem ersten Bildschirm der Seite vage Formulierungen. Das Team startet einen A/B-Test mit zwei Überschriften:

- «Infrastruktur Lösungen für die Online-Präsenz»

- «Starte dein Projekt im Internet noch heute»

Beide Varianten zeigen ähnliche Ergebnisse, weil die Benutzer nicht verstehen, was ihnen angeboten wird: eine Domain, Hosting, VPS oder überhaupt einen umfassenden Service. In einer solchen Situation zeigt der Test nicht die bessere Variante, da das Problem nicht in der spezifischen Formulierung liegt, sondern in der Klarheit des Angebots selbst.

- Wenn nicht das richtige Problembewusstsein getestet wird. Wenn die Werbung aufgrund einer ungeeigneten Zielgruppe oder einer schwachen Idee insgesamt nicht funktioniert, wird das Testen kleiner Änderungen nur das Fehlen von Ergebnissen bestätigen.

Stellen wir uns vor, dass die Werbung einer sehr breiten Zielgruppe angezeigt wird, die kein Interesse an dem Produkt hat. Anstatt die Zielgruppenansprache zu überprüfen, startet man einen A/B-Test mit zwei Anzeigentexten. Beide Varianten funktionieren schlecht — und der Test dokumentiert dies nur, ohne die Ursache zu lösen.

- Wenn die Kampagne einen kurzen Lebenszyklus hat. Werbekampagnen oder Seiten, die nur einige Tage oder Wochen existieren, haben einfach nicht genug Zeit, um genügend Daten zu sammeln.

- Wenn man von den Tests fertige Antworten erwartet. A/B-Tests geben keine Hinweise darauf, was als Nächstes zu tun ist, wenn beide Varianten ähnliche Ergebnisse zeigen.

Zusammenfassend lässt sich sagen, dass A/B-Tests am besten dort funktionieren, wo ein verständliches Produkt, ein stabiler Benutzerfluss und eine klare Hypothese zur Überprüfung vorhanden sind. In anderen Fällen kann es verfrüht sein — und das ist kein Fehler, sondern ein Hinweis, den Fokus der Arbeit zu ändern.

Ein gut eingerichteter Test zeigt, ob eine spezifische Änderung einen spürbaren Einfluss hat. Manchmal identifiziert er die bessere Variante, manchmal bestätigt er, dass es keinen Unterschied gibt. Beide Ergebnisse sind nützlich, wenn sie richtig interpretiert werden.