Was sind Bots — Software, die darauf abzielt, Informationen im Internet zu sammeln und zu analysieren sowie wiederholte Aktionen durchzuführen, die ein Benutzer ausführen könnte. Zum Beispiel können Bots Daten auf Websites parsen, auf Werbung klicken, Feedback-Formulare ausfüllen und programmierte Antworten in Chats geben.

Der Begriff «Bot» wird breit verwendet, er bezeichnet sowohl automatisierte Antworten in sozialen Netzwerken und auf Websites (Chatbots) als auch Personen, die gefälschte Konten in sozialen Netzwerken verwalten. Wir werden jedoch über jene Bots sprechen, die auf die Website gelangen und dort bestimmte Aktionen ohne Wissen des Eigentümers durchführen.

Dank ihrer höheren Geschwindigkeit kann ein Bot Hunderte von Operationen mehr ausführen als ein Mensch in derselben Zeit. Darüber hinaus kostet die Nutzung eines Bots weniger als die Einstellung von Mitarbeitern – zum Beispiel für die Datensammlung. Daher liegen Bots der Automatisierung vieler Prozesse im Internet zugrunde.

Fast die Hälfte des Internet-Traffics wird von Bots erzeugt. Laut Statista erzeugten im Jahr 2021 bösartige Bots 27,7% des Traffics, während nützliche Bots nur 14,6% erzeugten. Den Menschen blieb in dieser Verteilung 57,7% des Traffics.

Jeder Bot, der auf die Website zugreift, erzeugt eine bestimmte Last. Und während man mit dem Traffic nützlicher Bots leben muss, bringen bösartige Bots mehrere Probleme mit sich, abhängig von ihrem Zweck. Neben der Last auf der Website sind das auch unbefugte Datensammlungen, DDoS-Angriffe und das Umgehen von Schutzsystemen.

Unabhängig davon, wo Ihre Website gehostet wird — auf einem Hosting, dedizierten Server oder VDS, Bots beanspruchen Ressourcen und schädigen die Kennzahlen für schnelle Ladezeiten.

Lassen Sie uns herausfinden, was bösartige und nützliche Bots sind und welche Typen es gibt.

Was sind bösartige Bots und wie unterscheiden sie sich von nützlichen

Nützliche und bösartige Bots sind in technischer Hinsicht sehr ähnlich — der Unterschied liegt im Zweck ihrer Verwendung. Je nach Zweck werden sie in engere Kategorien unterteilt.

Bösartige Bots:

-

Spionage-Bots – scannen Websites auf der Suche nach schlecht geschützten Kontaktdaten von Benutzern, um eine Spam-Verteilerliste und andere unbefugte Handlungen zu erstellen. Wenn Sie plötzlich verdächtige E-Mails erhalten, könnte einer der möglichen Szenarien sein: Sie haben Ihre Adresse auf einer schlecht geschützten Website hinterlassen, die von einem Bot gefunden und in eine Datenbank aufgenommen wurde.

-

Click-Bots – aus dem Namen kann man erraten, dass sie sich mit dem Klicken beschäftigen, genauer gesagt, sie klicken auf Links. Die meisten Probleme verursachen sie im Werbesektor bei Google, indem sie das Budget für bezahlte Anzeigen aufbrauchen. Diese Methode wird häufig von Mitbewerbern verwendet.

-

Hacker versuchen, Zugangspasswörter für die Konten von Administratoren oder Benutzern auf der Website zu erraten.

-

Spam-Bots füllen Feedback-Formulare aus und hinterlassen Werbe-Kommentare mit Links, die oft auf Phishing-Websites führen.

-

Downloader laden Dateien herunter – sie werden verwendet, um den Anschein von gefragtem Inhalt zu erwecken.

-

DDoS-Bots – häufig sind dies Benutzergeräte, die mit Schadsoftware infiziert sind. Solche Bots senden sehr viele Anfragen an den Server, um ihn «zum Absturz zu bringen».

Nützliche Bots:

-

Suchbots (Crawler) – dies sind die Arbeiter von Suchmaschinen, die die Seiten von Websites scannen, um sie in den Index aufzunehmen, zu bewerten und in den SERP anzuzeigen.

-

SEO-Analyse-Bots – dies sind Tools wie Ahrefs, Serpstat, Semrush und andere, die auf Websites bestimmte Kennzahlen überwachen, die für die Arbeit von SEO-Spezialisten erforderlich sind (Traffic, Backlinks, Schlüsselwörter, nach denen die Website eingestuft wird).

-

Scanner zur Bestimmung der Einzigartigkeit von Inhalten – sie werden von Textern zur Überprüfung von Texten verwendet. Plagiatsprüfer durchsuchen alle verfügbaren Artikel im Netz, um Übereinstimmungen zu finden und kopierte Texte zu identifizieren.

Diese Klassifikation umfasst die gängigsten Bots – tatsächlich gibt es viel mehr. Darüber hinaus ist eine solche Klassifikation ziemlich bedingt. Derselbe Bot kann für verschiedene Zwecke verwendet werden – beispielsweise kann aggressives Datensammeln zu einer Verlangsamung und sogar zum Stillstand der Website führen. Aber dasselbe Sammeln von Daten ist nützlich für Websites, da es Teil der Arbeit von Suchmaschinen, Preisvergleichsdiensten und vielen anderen Plattformen ist.

Wie man die Aktivität von Bots auf der Website verfolgt

Das Auftreten von Bots kann anhand mehrerer Kriterien verfolgt werden:

-

Traffic-Spitzen — wenn Ihr Traffic plötzlich «springt», was nicht mit Marketingaktionen in Verbindung steht, kann dies auf die Aktivität von Bots hindeuten.

-

Eine erhöhte Serverlast kann ebenfalls auf die Aktivität von Bots hinweisen.

-

Das Auftreten von Anfragen aus Regionen, in denen Sie kein Geschäft betreiben.

-

Hohe Absprungrate: Bots erzeugen Anfragen, verbringen jedoch nicht genügend Zeit auf der Website. Die IP-Adressen von Bots weisen eine Absprungrate von 100% auf.

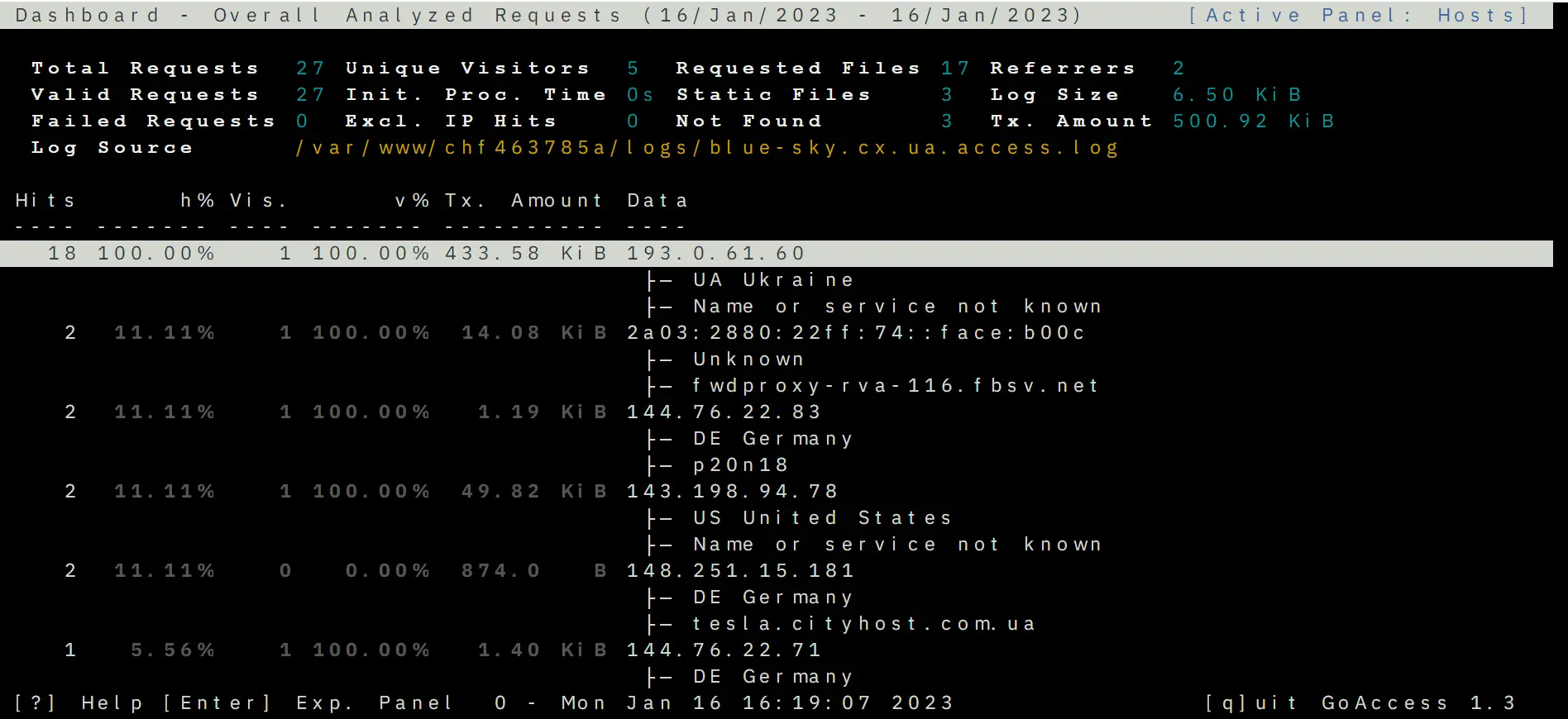

Aber die beste Möglichkeit, die Aktivitäten von Bots auf der Website zu sehen, besteht darin, die Protokolle zu analysieren — das sind Aufzeichnungen über die Sitzungen des Website-Besuchs, in denen eine Reihe von Daten zum Besucher angegeben ist. Insbesondere ist dies ein Indikator wie der User-Agent — Software-Agenten, anhand deren Namen man das Gerät oder Programm erkennen kann, das auf die Website zugegriffen hat. User-Agents gibt es bei Browsern, Suchrobotern, mobilen Anwendungen usw.

Jeder Bot hat seinen eigenen Namen, zum Beispiel heißt der User-Agent von Google Googlebot, der Parser von Ahrefs – AhrefsBot, SE Ranking – SE Ranking bot.

Um die Protokolle anzuzeigen, verwenden Sie das spezielle Tool GoAccess von Cityhost, das Anfragen sortiert und Statistiken anzeigt. Es ist im Abschnitt Hosting => Verwaltung => SSH => Web SSH: Öffnen zu finden. Danach empfehlen wir, die Anleitung zu nutzen, wie man Protokolle mit GoAccess analysiert.

Mit diesem Tool können Sie das Land sehen, aus dem auf die Website zugegriffen wurde, die IP-Adresse, den User-Agent und andere Parameter.

Wenn der Bot jedoch keinen User-Agent hat (wird als Unknown robot angezeigt) — dann ist es wahrscheinlich die Arbeit eines Amateur-Hackers oder eines einzelnen Hackers, den man nach der IP-Adresse sperren kann. Lesen Sie weiter unten, wie man das macht.

Schutz der Website vor bösartigen Bots

Eine der Herausforderungen beim Schutz vor Bots besteht darin, dass sie die Aktionen von Benutzern nachahmen, und der Server die Anfragen von Bots und Menschen nicht unterscheidet. Es gibt keinen magischen Knopf «Schutz vor Bots auf der Website», der mit einer einzigen Bewegung von Problemen befreit. Für jede Klasse von Bots gibt es einen separaten Schutz, zudem müssen viele ungebetene Gäste manuell gefiltert werden.

Der Zugang zur Website sollte nicht nur für offen bösartige Bots gesperrt werden, sondern auch für diejenigen, die keinen Nutzen bringen, aber zusätzliche Last erzeugen. Zum Beispiel, wenn ein Website-Analyse-Service oder ein Suchrobot, der für Ihre Arbeit nicht notwendig ist, die Website scannt.

Webmaster stehen vor einer ganzen Reihe von komplexen Fragen, die nicht immer gelöst werden können — zum Beispiel der gleiche Schutz vor Parsing. Mit automatisierten Methoden ist es unmöglich, gutes und schlechtes Parsing zu unterscheiden, zudem ist diese Methode de facto nicht illegal. Daten von Websites zu durchsuchen und zu sammeln, kann jeder, dafür wurden sie geschaffen. Wenn ein Benutzer durch Seiten blättert und Preise notiert, ist das ebenfalls ein Datensammelprozess, nur macht der Parser das schneller. Solche Feinheiten komplizieren den Schutz der Website und machen ihn zu einem fortlaufenden Prozess. Es ist notwendig, den Traffic ständig zu überwachen und die Protokolle zu analysieren, um die Sitzungen bösartiger Bots auf der Website zu sehen und sie manuell zu blockieren.

Da Bots häufig für DDoS-Angriffe verwendet werden, empfehlen wir Ihnen, den Artikel zu lesen, wie man sich vor DDoS-Angriffen schützt.

Methoden zur Blockierung bösartiger Bots

Hier werden wir über die Werkzeuge sprechen, die hauptsächlich von Cityhost-Kunden bereitgestellt werden. Wenn Sie die Dienste anderer Anbieter nutzen, können die Methoden etwas abweichen.

-

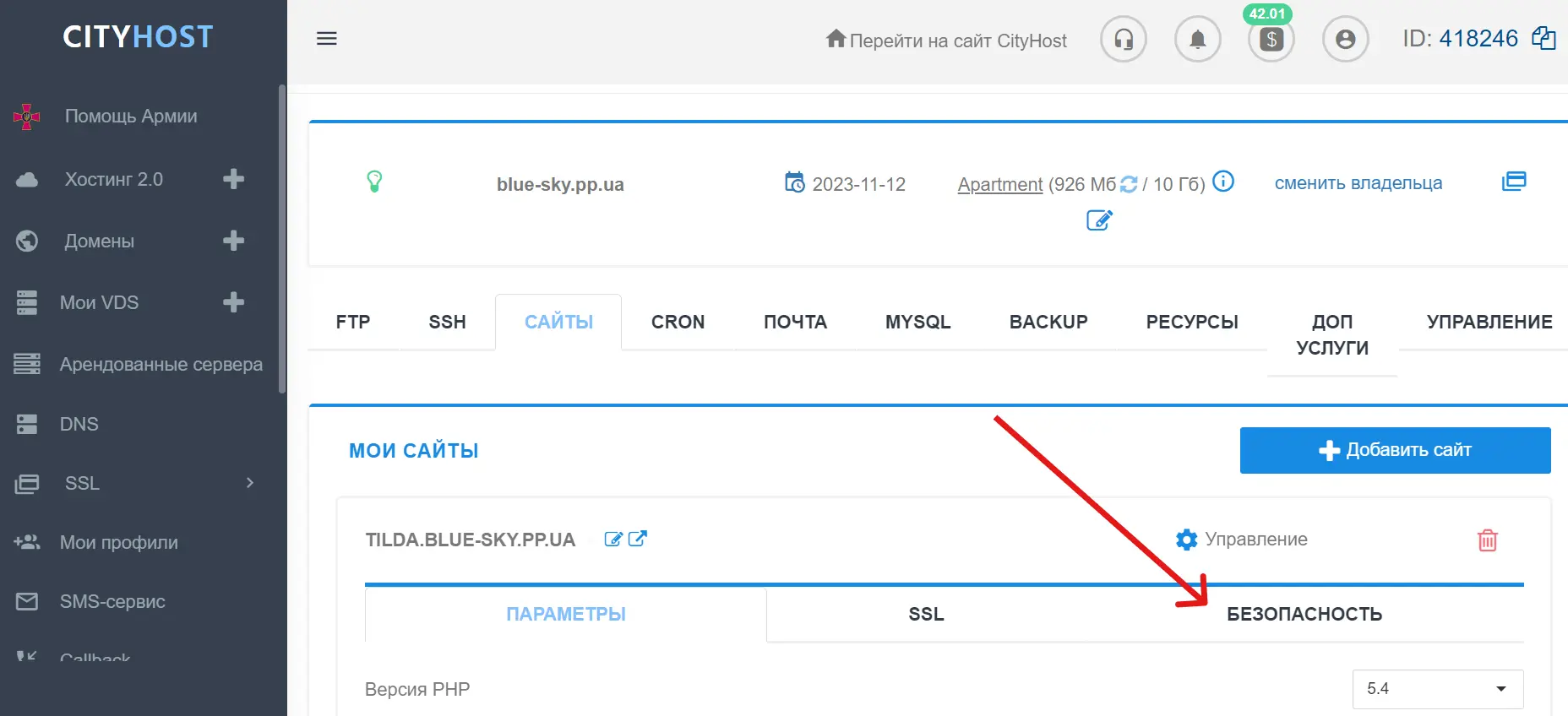

Blockierung von Traffic-Quellen

Im Control Panel von Cityhost können Sie verdächtige Traffic-Quellen manuell nach IP-Adresse und URL blockieren. Die Werkzeuge zur Blockierung finden Sie im Abschnitt Hosting => Verwaltung => Sicherheit.

Besonders erwähnenswert ist die Blockierung nach User-Agent — in diesem Tool gibt es bereits eine integrierte Liste verbreiteter bösartiger Bots. Der Benutzer kann das Tool aktivieren oder deaktivieren, sowie Markierungen von bestimmten User-Agents entfernen oder alle auswählen. Wenn Sie jedoch spezifische User-Agents manuell blockieren möchten – dafür gibt es einen separaten Handlungsalgorithmus, der weiter unten im Artikel beschrieben ist.

Zusätzlich können Sie im Abschnitt «Sicherheit» ein Passwort für bestimmte Verzeichnisse festlegen, damit nur diejenigen, die dieses Passwort kennen, Zugriff auf wichtige Ordner der Website im Dateimanager haben.

-

Captcha für den Zugang zum Administratorkonto

Im selben Abschnitt finden Sie die von Cityhost erstellte Captcha — sie schützt den Zugang zum Adminbereich auf unserer Website und in den auf Hosting installierten CMS. Dies ist ein sehr einfacher und unaufdringlicher Filter, bei dem das Kontrollkästchen «Ich bin kein Roboter» angekreuzt werden muss (keine komplizierten Verfahren). Aber selbst diese einfache Handlung kann der Bot nicht ausführen.

-

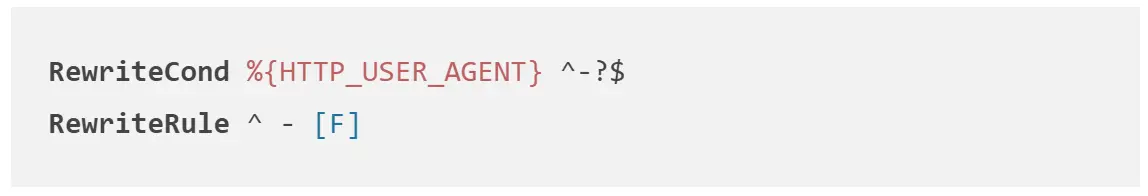

Blockierung von Bots in .htaccess

.htaccess — das ist eine Datei im Stammverzeichnis der Website, die bestimmte Einstellungen für den Betrieb der Webressource enthält (Redirect, Erstellung von Fehlerseiten, Zugriff auf die Website und bestimmte Dateien blockieren). In dieser Datei können Verbote für die User-Agents bösartiger Bots festgelegt werden, die die Website in Zukunft nicht mehr scannen können.

Dazu muss .htaccess im Dateimanager geöffnet werden und die folgenden Regeln eingegeben werden, wobei UserAgentName durch den tatsächlichen User-Agent ersetzt wird.

Sie können auch Anfragen von Agenten blockieren, die keinen Namen haben.

-

Schutz vor Spam-Bots

Bots, die Kommentare auf der Website hinterlassen und Feedback-Formulare ausfüllen, erfordern besondere Aufmerksamkeit. Zum Schutz vor ihnen werden folgende Methoden verwendet:

-

Captcha im Formular — sie sieht normalerweise aus wie das Ankreuzen des Kontrollkästchens «Ich bin kein Roboter» und erschwert die Interaktion des Benutzers mit der Website nicht zu sehr.

-

E-Mail-Verifizierung — das Versenden einer E-Mail an die angegebene Adresse, damit der Benutzer dem Link folgt und diese bestätigt. Bots generieren Hunderte von nicht existierenden Adressen, daher ermöglicht diese Methode, Kommentare oder Formulare nur für echte E-Mails zu hinterlassen.

-

Fallen für Bots — das sind unsichtbare Felder, die Benutzer nicht ausfüllen, einfach weil sie nicht sichtbar sind. Bots füllen alle Felder aus, daher können sie auf diese Weise erkannt und gefiltert werden.

Wie man die Aktivitäten nützlicher Bots verwaltet

Nützliche Bots wissen manchmal auch nicht, wann genug ist, und senden zu viele Anfragen, wodurch die Website überlastet wird. Aber sie können «gebremst» werden. Für jeden Bot gibt es eigene Einstellungen, die in den meisten Fällen in den Anleitungen auf der offiziellen Website zu finden sind. Zum Beispiel hier sind Seiten, die den Crawlers von Google, Ahrefs und Serpstat gewidmet sind:

Sie können solche Anleitungen selbst für alle nützlichen Bots finden und die Dauer sowie Frequenz des Scannens einschränken, damit sie die Website nicht überlasten.

Abschließend sei darauf hingewiesen, dass alle Arten von bösartigen Bots mit dem Cloudflare-Service blockiert werden können, über den wir einen separaten Artikel geschrieben haben. Lesen Sie ihn und nutzen Sie diese Plattform für zusätzlichen Schutz.

Wie man den Traffic von Bots auf der Website analysiert

Um zu sehen, ob die Last auf der Website nach der Einführung einer der Schutzmethoden gesunken ist, können Sie in Ihrem Administrationspanel im Hosting nachsehen: Hosting 2.0 => Verwaltung => Ressourcen => Abschnitte «Allgemeine Informationen», CPU, MySQL. Aber Sie sollten verstehen, dass Sie die Änderungen nicht sofort sehen werden — es muss mindestens ein paar Stunden vergangen sein.

Um die Website vor unnötigen Anfragen zu schützen, empfehlen wir, regelmäßig die Ladekennzahlen, Protokolle und den Traffic zu überwachen, um Bots rechtzeitig zu blockieren.

In dem Material wurden folgende Quellen verwendet: