Czym są boty — to oprogramowanie, które ma na celu zbieranie i analizowanie informacji w internecie, a także wykonywanie powtarzalnych działań, które mógłby wykonać użytkownik. Na przykład, boty mogą zbierać dane ze stron, klikać w reklamy, wypełniać formularze kontaktowe, udzielać zaprogramowanych odpowiedzi w czatach.

Termin «bot» ma szerokie zastosowanie, określa zarówno zautomatyzowane odpowiedzi w mediach społecznościowych i na stronach (chatboty), jak i ludzi zarządzających fikcyjnymi kontami w mediach społecznościowych. My będziemy mówić o tych botach, które wchodzą na stronę i wykonują tam określone działania bez wiedzy właściciela.

Dzięki większej szybkości bot może wykonać setki razy więcej operacji niż człowiek w tym samym czasie. Ponadto, korzystanie z bota jest tańsze niż zatrudnianie pracowników – na przykład do zbierania danych. Dlatego roboty leżą u podstaw automatyzacji wielu procesów w sieci.

Prawie połowa ruchu w Internecie jest generowana przez boty. Zgodnie z badaniami Statista w 2021 roku złośliwe boty generowały 27,7% ruchu, podczas gdy pożyteczne boty tylko 14,6%. Ludzie w tym podziale otrzymali 57,7% ruchu.

Każdy bot, wchodząc na stronę, generuje określony ruch. I jeśli z ruchem od pożytecznych botów trzeba się pogodzić, to złośliwe boty niosą ze sobą kilka problemów w zależności od celu swojego istnienia. Oprócz obciążenia strony, to także nieautoryzowane zbieranie danych, ataki DDoS i omijanie systemów ochrony.

Niezależnie od tego, gdzie znajduje się Twoja strona — na hostingu, serwerze dedykowanym lub VDS, boty zabierają zasoby i szkodzą wskaźnikom szybkiego ładowania.

Zajmijmy się tym, czym są złośliwe i pożyteczne boty oraz jakie są ich rodzaje.

Czym są złośliwe boty i czym różnią się od pożytecznych

Pożyteczne i złośliwe boty są bardzo podobne pod względem technicznym — różnica polega na celu ich użycia. W zależności od celów dzielą się na węższe kategorie.

Złośliwe boty:

-

Boty szpiegowskie – skanują strony w poszukiwaniu słabo chronionych danych kontaktowych użytkowników w celu stworzenia bazy do spamu i innych nieautoryzowanych działań. Jeśli na Twoją skrzynkę e-mail zaczęły przychodzić podejrzane wiadomości, to jednym z możliwych scenariuszy jest to, że zostawiłeś adres na słabo zabezpieczonej stronie, którą znalazł bot i dodał do bazy.

-

Clickboty — z nazwy można się domyślić, że zajmują się klikanie, a dokładniej, przechodzą przez linki. Najwięcej problemów stwarzają w sektorze reklamowym w Google, marnując budżet na reklamach płatnych za kliknięcia. Tę metodę często wykorzystują konkurenci.

-

Hackerzy dobierają hasła dostępu do kont administratorów lub użytkowników na stronie.

-

Boty spamujące wypełniają formularze kontaktowe i zostawiają reklamowe komentarze z linkami, często prowadzącymi do stron phishingowych.

-

Pobieracze ściągają pliki – używają ich, aby stworzyć wrażenie popularnej treści.

-

Boty do DDoS – często stają się nimi urządzenia użytkowników zainfekowane złośliwym oprogramowaniem. Takie boty wysyłają bardzo wiele zapytań do serwera w celu «zablokowania» go.

Pożyteczne boty:

-

Boty wyszukiwarek (crawlerzy) — to roboty wyszukiwarek, które skanują strony internetowe w celu ich indeksacji, rankingowania i wyświetlania w SERP.

-

Boty narzędzi SEO — to narzędzia takie jak Ahrefs, Serpstat, Semrush i inne, które monitorują na stronach określone wskaźniki potrzebne do pracy specjalistów SEO (ruch, linki zwrotne, słowa kluczowe, na które strona jest rankingowana).

-

Skanery do określania unikalności treści — używane są do sprawdzania tekstów przez copywriterów. Antyplagiaty sprawdzają wszystkie dostępne w sieci artykuły w celu porównania i wykrycia skopiowanych tekstów.

W tej klasyfikacji zebrano najczęściej występujące boty — w rzeczywistości jest ich znacznie więcej. Ponadto, taka klasyfikacja jest dość umowna. Ten sam bot można wykorzystać do różnych celów — na przykład, agresywne zbieranie danych może spowodować spowolnienie, a nawet zatrzymanie działania strony. Ale to samo zbieranie danych jest przydatne dla stron, ponieważ jest częścią pracy wyszukiwarek, serwisów porównujących ceny i wielu innych platform.

Jak śledzić aktywność botów na stronie

Pojawienie się botów można śledzić według kilku kryteriów:

-

Wzrost ruchu — jeśli nagle Twój ruch «skoczył», co nie jest związane z akcjami marketingowymi, może to świadczyć o aktywności botów.

-

Wzrost obciążenia serwera może również wskazywać na aktywność botów.

-

Pojawienie się zapytań z regionów, w których nie prowadzisz działalności.

-

Wysoki wskaźnik odrzuceń: boty generują zapytania, ale nie spędzają na stronie wystarczająco dużo czasu. W adresach IP botów będzie wskaźnik 100% odrzuceń.

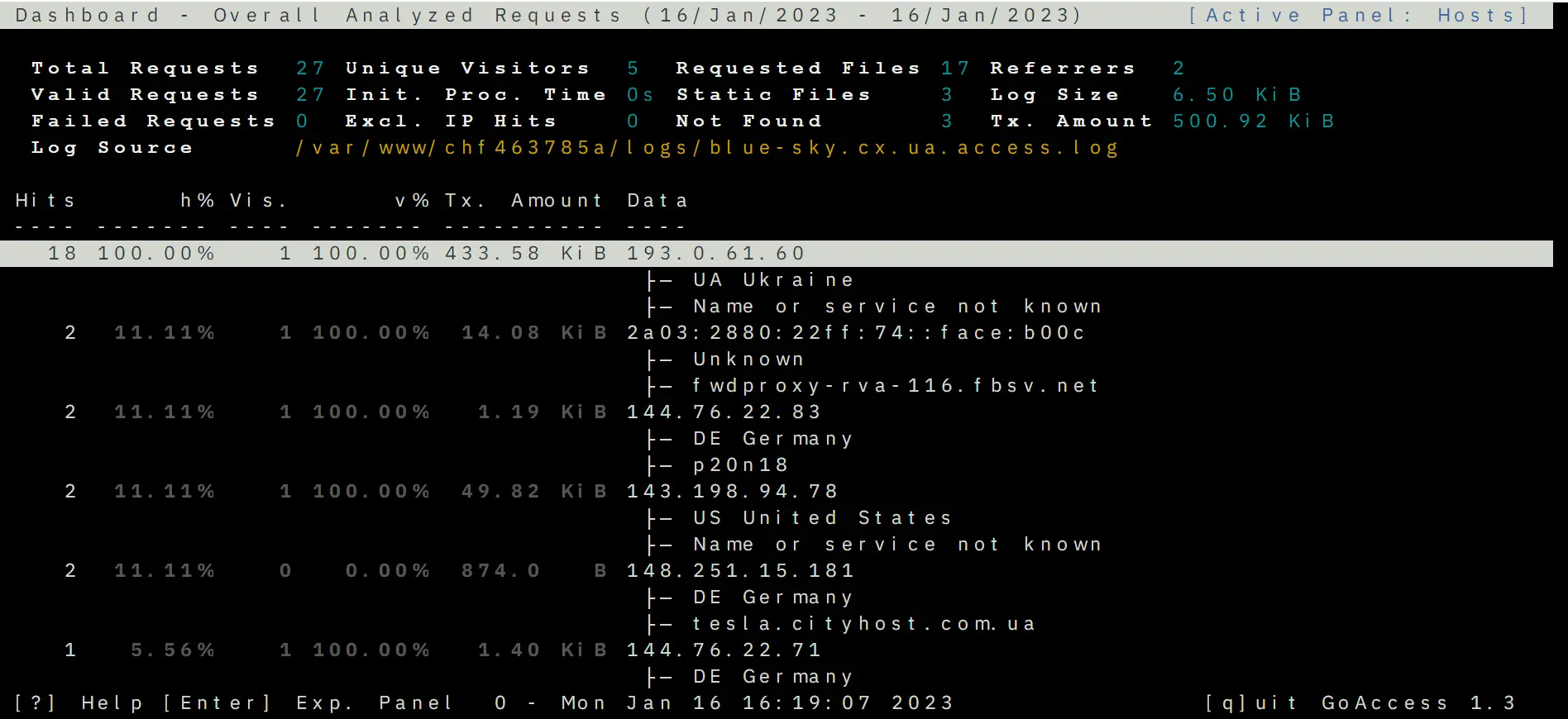

Jednak najlepiej działalność botów na stronie można zobaczyć, analizując logi — to zapisy o sesjach odwiedzin strony, w których podano szereg danych o odwiedzającym. W szczególności jest to taki wskaźnik jak user-agent — programowe agenty, pod nazwą których można określić urządzenie lub program, który odwiedzał stronę. User-agenty mają przeglądarki, roboty wyszukiwarek, aplikacje mobilne itd.

Każdy bot ma swoją nazwę, na przykład user-agent Google nazywa się Googlebot, parser Ahrefs — AhrefsBot, SE Ranking — SE Ranking bot.

Aby zobaczyć logi, użyj specjalnego narzędzia GoAccess od Cityhost, które sortuje zapytania i podaje statystyki. Można je znaleźć w sekcji Hosting => Zarządzanie => SSH => Web SSH: Otwórz. Następnie zalecamy skorzystać z instrukcji, jak analizować logi za pomocą GoAccess.

Dzięki temu można zobaczyć kraj, z którego wchodzono na stronę, adres IP, user-agent i inne parametry.

Jeśli bot nie ma user-agenta (pisze się jako Unknown robot) — wtedy najprawdopodobniej jest to działanie jakiegoś amatora lub pojedynczego hakera, którego można zablokować po adresie IP. Czytaj dalej, jak to zrobić.

Ochrona strony przed złośliwymi botami

Jednym z trudności w ochronie przed botami jest to, że naśladują one działania użytkowników, a serwer nie odróżnia zapytań od botów i ludzi. Nie ma magicznego przycisku «Ochrona przed botami na stronie», który jednym ruchem pozbawiłby problemów. Dla każdej klasy robotów istnieje osobna ochrona, ponadto część nieproszonych gości trzeba filtrować ręcznie.

Zamykanie dostępu do strony należy nie tylko złośliwym botom, ale także tym, które nie przynoszą korzyści, ale generują dodatkowe obciążenie. Na przykład, gdy strona jest skanowana przez usługę analityczną lub robota wyszukiwarki, który nie jest potrzebny do Twojej pracy.

Przed webmasterami staje szereg trudnych pytań, które nie zawsze można rozwiązać — na przykład, ta sama ochrona przed zbieraniem danych. Automatycznymi metodami nie można odróżnić dobrego i złego zbierania danych, ponadto w rzeczywistości ta metoda nie jest nielegalna. Przeglądanie i zbieranie danych ze stron może robić każdy, do tego są stworzone. Kiedy użytkownik przegląda strony i zapisuje ceny, to również jest proces zbierania danych, po prostu parser robi to szybciej. Takie subtelności utrudniają proces ochrony strony i czynią go nieprzerwanym. Należy stale monitorować ruch i analizować logi, aby zobaczyć sesje wejścia na stronę złośliwych botów i ręcznie je zablokować.

Ponieważ boty często są wykorzystywane do DDoS, zalecamy przeczytać artykuł o tym, jak chronić się przed atakami DDoS.

Metody blokowania złośliwych botów

Tutaj opowiemy o narzędziach, głównie dostarczanych klientom Cityhost. Jeśli korzystasz z usług innych dostawców, metody mogą się nieco różnić.

-

Blokowanie źródeł ruchu

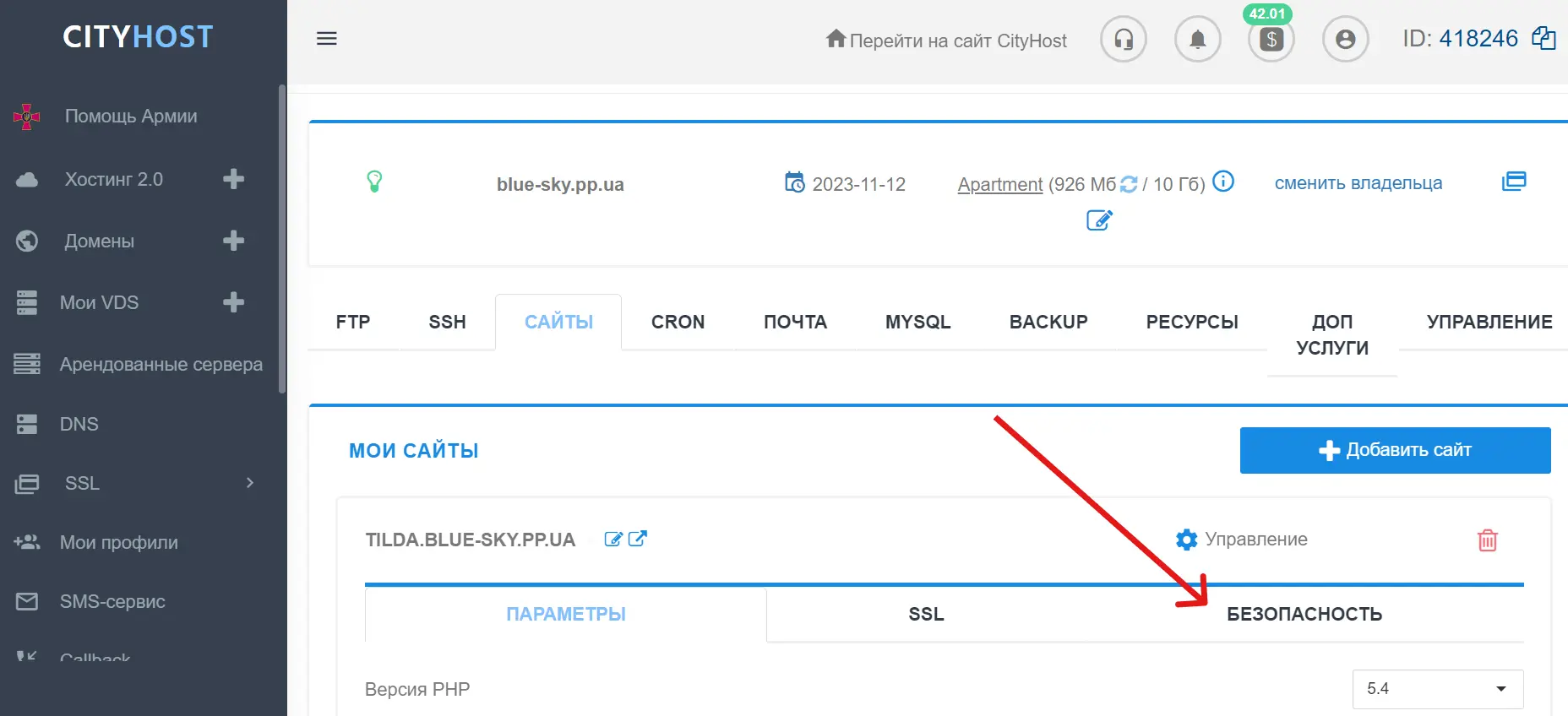

W panelu zarządzania Cityhost można ręcznie zablokować podejrzane źródła ruchu po adresie IP i URL. Narzędzia do blokowania można znaleźć w sekcji Hosting => Zarządzanie => Bezpieczeństwo.

Osobno warto wspomnieć o blokowaniu po user-agent — w tym narzędziu znajduje się już wbudowana lista powszechnych złośliwych botów. Użytkownik może włączyć lub wyłączyć narzędzie, a także usunąć zaznaczenia z określonych user-agentów lub wybrać wszystkie. Jeśli chcesz ręcznie zablokować konkretne user-agenty – do tego jest osobny algorytm działań, opisany poniżej w artykule.

Dodatkowo w sekcji «Bezpieczeństwo» można ustawić hasło na określone katalogi, aby do ważnych folderów strony w menedżerze plików mieli dostęp tylko ci, którzy znają to hasło.

-

Captcha do logowania do konta administratora

W tej samej sekcji znajdziesz captcha stworzoną przez Cityhost — chroni ona logowanie do panelu administracyjnego na naszej stronie i w zainstalowanych na hostingu CMS. To bardzo prosty i nienachalny filtr, w którym należy zaznaczyć pole «Nie jestem robotem» (żadnych skomplikowanych procedur). Ale nawet tak proste działanie bot już nie może wykonać.

-

Blokowanie botów w .htaccess

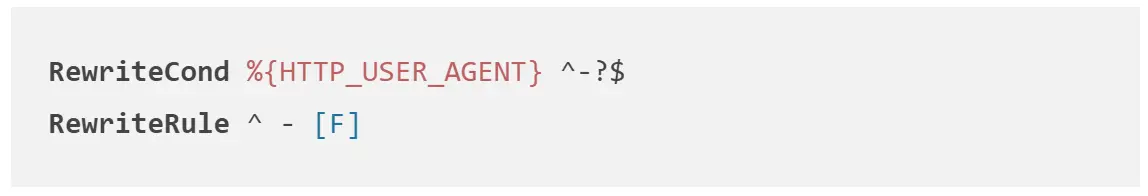

.htaccess — to plik w głównym folderze strony, zawierający określone ustawienia działania zasobu internetowego (przekierowanie, tworzenie stron błędów, blokowanie dostępu do strony i poszczególnych plików). W tym pliku można wpisać zakazy dla user-agentów złośliwych robotów, które nie będą mogły później skanować strony.

Aby to zrobić, należy otworzyć .htaccess w menedżerze plików i wpisać w nim następujące zasady, gdzie UserAgentName zastąpić rzeczywistym user-agentem.

Można również zablokować zapytania od agentów, którzy nie mają nazwy.

-

Ochrona przed botami spamującymi

Boty, które zostawiają komentarze na stronie i wypełniają formularze kontaktowe, wymagają szczególnej uwagi. Do ochrony przed nimi stosuje się następujące metody:

-

Captcha w formularzu — zazwyczaj wygląda jak zaznaczenie pola «Nie jestem robotem» i nie utrudnia zbytnio interakcji użytkownika z stroną.

-

Weryfikacja e-maila — wysyłanie wiadomości na podany adres, aby użytkownik przeszedł przez link i potwierdził go. Boty generują setki nieistniejących adresów, dlatego taka metoda pozwala zostawiać komentarze lub wypełniać formularze tylko dla rzeczywistych e-maili.

-

Pułapki dla botów — to niewidoczne pola, które użytkownicy nie wypełnią tylko dlatego, że ich nie zobaczą. Boty wypełniają wszystkie pola, dlatego w ten sposób można je wykrywać i filtrować.

Jak zarządzać działalnością pożytecznych botów

Pożyteczne boty czasami również nie znają miary i wysyłają zbyt wiele zapytań, przeciążając stronę. Ale można je «spowolnić». Dla każdego bota istnieją swoje ustawienia, w większości można je znaleźć w instrukcjach na oficjalnej stronie. Na przykład, oto strony poświęcone crawlerom Google, Ahrefs i Serpstat:

Możesz samodzielnie znaleźć takie instrukcje dla wszystkich pożytecznych botów i ograniczyć czas oraz częstotliwość skanowania, aby nie przeciążały strony.

Na koniec warto zaznaczyć, że wszystkie rodzaje złośliwych botów można zablokować za pomocą usługi Cloudflare, o której pisaliśmy osobny artykuł. Zapoznaj się z nim i korzystaj z tej platformy dla dodatkowej ochrony.

Jak analizować ruch od botów na stronie

Można sprawdzić, czy obciążenie strony zmniejszyło się po wdrożeniu którejkolwiek z metod ochrony, w swoim panelu administratora na hostingu: Hosting 2.0 => Zarządzanie => Zasoby => sekcje «Ogólne informacje», CPU, MySQL. Należy jednak zrozumieć, że zmiany nie będą widoczne od razu — musi minąć przynajmniej kilka godzin.

Aby zabezpieczyć stronę przed niepotrzebnymi zapytaniami, zalecamy regularne monitorowanie wskaźników obciążenia, logów i ruchu, aby na czas zablokować boty.

W materiale wykorzystano źródła: