Bardzo często roboty wyszukiwarek dość agresywnie skanują stronę, co powoduje zwiększone obciążenie. Aby zatrzymać indeksację, należy wpisać w pliku robots.txt (w głównym folderze strony) następującą zasadę:

User-agent: *

Disallow: /

Ta zasada całkowicie wyklucza skanowanie strony przez roboty. Jeśli całkowicie ograniczysz dostęp do strony do skanowania, strona może zniknąć z wyników wyszukiwania.

1. Dlatego można ograniczyć dostęp tylko do konkretnych folderów, linków, plików i rozszerzeń za pomocą dyrektywy Disallow

Przykłady:

User-agent: *

Disallow: /directoria

User-agent: *

Disallow: /privatinfo.php

User-agent: *

Disallow: /privatpic.jpg

User-agent: *

Disallow: / *jpg$

Więcej informacji na temat pracy z plikiem można znaleźć w instrukcjach google.

2. Można również ograniczyć dostęp przez plik .htaccess do określonych stron witryny, jak opisano w instrukcji.

Aby ograniczyć dostęp z konkretnego adresu IP, wystarczy wpisać zasadę:

Order Allow,Deny

Allow from all

Deny from ***.***.***.***

***.***.***.*** - zamień na adres IP. Adres IP można znaleźć, otwierając logi serwera w FTP w folderze logs.

3. Aby zablokować dostęp dla określonych krajów poza ukraińskimi (na przykład) IP, można skorzystać z instrukcji.

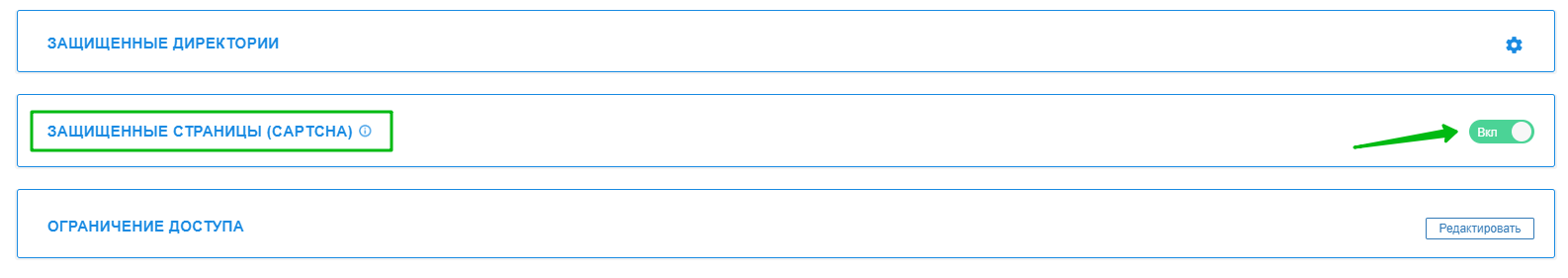

4. Zablokować dostęp robotom do wrażliwych stron można za pomocą wewnętrznej captchy, którą można znaleźć w sekcji Hosting 2.0 - Strony - Bezpieczeństwo - ZABEZPIECZONE STRONY (CAPTCHA)*:

*domyślnie captcha jest włączona dla następujących stron:

STRONA LOGOWANIA WP : wp-admin, wp-login.php

STRONA ADMINISTRACYJNA JOOMLA: /administrator, view=login

STRONA REJESTRACJI JOOMLA : view=registration

STRONA ADMINISTRACYJNA OC : /admin

STRONA ADMINISTRACYJNA MODX: /manager

STRONA ADMINISTRACYJNA PRESTA SHOP: /Backoffice

STRONA ADMINISTRACYJNA DRUPAL : /user/login/

Podstawowe kwestie dotyczące pracy z robots.txt opisano w naszym blogu - https://cityhost.ua/blog/chto-takoe-robots-txt-kak-nastroit-robots-txt-dlya-wordpress.html

Wszystkie kategorie pytań